Localisation du son 3D - 3D sound localization

La localisation sonore 3D fait référence à une technologie acoustique qui est utilisée pour localiser la source d'un son dans un espace tridimensionnel . L'emplacement de la source est généralement déterminé par la direction des ondes sonores entrantes (angles horizontaux et verticaux) et la distance entre la source et les capteurs. Cela implique la conception de l'agencement de la structure des capteurs et des techniques de traitement du signal .

La plupart des mammifères (y compris les humains) utilisent l' audition binaurale pour localiser le son, en comparant les informations reçues de chaque oreille dans un processus complexe qui implique une quantité importante de synthèse. Il est difficile de localiser en utilisant l' audition monaurale , en particulier dans l'espace 3D .

La technologie

La technologie de localisation du son est utilisée dans certains domaines audio et acoustiques , tels que les prothèses auditives , la surveillance et la navigation . Les systèmes de localisation passive du son en temps réel existants sont principalement basés sur l' approche de différence de temps d'arrivée ( TDOA ), limitant la localisation du son à un espace bidimensionnel , et ne sont pas pratiques dans des conditions bruyantes.

Applications

Les applications de la localisation des sources sonores comprennent la séparation des sources sonores, le suivi des sources sonores et l'amélioration de la parole. Le sonar utilise des techniques de localisation de source sonore pour identifier l'emplacement d'une cible. La localisation du son 3D est également utilisée pour une interaction homme-robot efficace. Avec la demande croissante d'audition robotique, certaines applications de la localisation sonore 3D telles que l'interface homme-machine, l'aide aux personnes handicapées et les applications militaires sont à l'étude.

Indices pour la localisation du son

Les indices de localisation sont des fonctionnalités qui aident à localiser le son. Les indices pour la localisation du son comprennent les indices binauraux et monophoniques.

- Les signaux monophoniques peuvent être obtenus par analyse spectrale et sont généralement utilisés en localisation verticale.

- Les signaux binauraux sont générés par la différence d'audition entre les oreilles gauche et droite. Ces différences incluent la différence de temps interaurale (ITD) et la différence d'intensité interaurale (IID). Les indices binauraux sont principalement utilisés pour la localisation horizontale.

Comment localiser le son ?

Le premier indice que notre audition utilise est la différence de temps interaurale. Le son d'une source directement devant ou derrière nous arrivera simultanément aux deux oreilles. Si la source se déplace vers la gauche ou la droite, nos oreilles captent le son de la même source arrivant aux deux oreilles - mais avec un certain retard. Une autre façon de le dire pourrait être que les deux oreilles captent des phases différentes du même signal.

Méthodes

Il existe de nombreuses méthodes différentes de localisation du son 3D. Par exemple:

- Différents types de structure de capteur, tels qu'un réseau de microphones et une tête de robot auditif binaural.

- Différentes techniques pour des résultats optimaux, telles que le réseau de neurones , le maximum de vraisemblance et la classification de signaux multiples (MUSIC).

- Méthodes en temps réel utilisant une matrice de capteurs vectoriels acoustiques (AVS)

- Méthodes hors ligne (selon l'actualité)

- Approche du réseau de microphones

Approche de formation de faisceau dirigée

Cette approche utilise huit microphones combinés à un formateur de faisceau dirigé amélioré par la transformée de phase pondérée en fiabilité (RWPHAT). Les résultats finaux sont filtrés à travers un filtre à particules qui traque les sources et empêche les fausses directions.

La motivation de l'utilisation de cette méthode est celle basée sur des recherches antérieures. Cette méthode est utilisée pour le suivi et la localisation de plusieurs sources sonores, bien que le suivi et la localisation ne s'appliquent qu'à une seule source sonore.

Localisation du son basée sur le Beamformer

Maximiser l'énergie de sortie d'un beamformer à retard et somme afin de trouver la valeur maximale de la sortie d'un beamformer orienté dans toutes les directions possibles. En utilisant la méthode RWPHAT (Reliability Weighted Phase Transform), l'énergie de sortie du M-microphone delay-and-sum beamformer est

Où E indique l'énergie, et K est une constante, est la corrélation croisée des paires de microphones définie par la Transformée de Phase Pondérée par la Fiabilité :

le facteur pondéré reflète la fiabilité de chaque composante de fréquence et est défini comme le gain du filtre de Wiener , où est une estimation d'un SNR antérieur au microphone, à une période de temps , pour la fréquence , calculé à l'aide de l'approche décisionnelle.

Le est le signal du microphone et est le délai d'arrivée pour ce microphone. La procédure plus spécifique de cette méthode est proposée par Valin et Michaud

L'avantage de cette méthode est qu'elle détecte la direction du son et en déduit la distance des sources sonores. Le principal inconvénient de l'approche de formation de faisceau est la nature imparfaite de la précision et de la capacité de localisation du son, par rapport à l'approche du réseau de neurones, qui utilise des haut-parleurs mobiles.

Approche du réseau de microphones colocalisé

Cette approche concerne la localisation du son en temps réel qui utilise un réseau de capteurs vectoriels acoustiques (AVS).

Tableau vectoriel acoustique

• Contient trois microphones acoustiques à gradient de vitesse des particules installés orthogonalement (indiqués par un réseau X, Y et Z) et un microphone acoustique omnidirectionnel (O).

• Couramment utilisé sous l'eau.

• Utilise le processus d'étalonnage hors ligne pour mesurer et interpoler la réponse impulsionnelle des matrices X, Y, Z et O, afin d'obtenir leur vecteur de pilotage.

Un signal sonore est d'abord fenêtré à l'aide d'une fenêtre rectangulaire, puis chaque signal de segment résultant est créé sous forme de trame. 4 trames parallèles sont détectées à partir du tableau XYZO et utilisées pour l'estimation DOA. Les 4 trames sont divisées en petits blocs de taille égale, puis la fenêtre de Hamming et la FFT sont utilisées pour convertir chaque bloc d'un domaine temporel en un domaine fréquentiel. Ensuite, la sortie de ce système est représentée par un angle horizontal et un angle vertical des sources sonores qui se trouve par le pic dans le spectre spatial 3D combiné.

Les avantages de ce réseau, par rapport au réseau de microphones antérieurs, sont que cet appareil a des performances élevées même si l'ouverture est petite, et il peut localiser simultanément plusieurs sources sonores à large bande basse fréquence et haute fréquence . L'application d'un réseau O peut rendre plus d'informations acoustiques disponibles, telles que l'amplitude et la différence de temps. Plus important encore, la baie XYZO a de meilleures performances avec une petite taille.

L'AVS est un type de réseau de microphones multiples colocalisés, il utilise une approche de réseau de microphones multiples pour estimer les directions du son par plusieurs réseaux, puis trouve les emplacements en utilisant des informations de réflexion telles que l'endroit où la direction est détectée où différents réseaux se croisent.

Motivation de la gamme de microphones avancés

Les réflexions sonores se produisent toujours dans un environnement réel et les réseaux de microphones ne peuvent éviter d'observer ces réflexions. Cette approche multi-réseaux a été testée en utilisant des réseaux fixes dans le plafond ; les performances du scénario de déménagement doivent encore être testées.

Apprendre à appliquer un réseau de microphones multiples

L'incertitude d'angle (AU) se produira lors de l'estimation de la direction, et l'incertitude de position (PU) s'aggravera également avec l'augmentation de la distance entre le réseau et la source. Nous savons que:

Où r est la distance entre le centre du réseau et la source, et AU est l'angle incertain. La mesure est utilisée pour juger si deux directions se croisent à un endroit ou non. Distance minimale entre deux lignes :

où et sont deux directions, sont des vecteurs parallèles à la direction détectée et sont la position des réseaux.

Si

Deux lignes sont considérées comme se croisant. Lorsque deux lignes se croisent, nous pouvons calculer l'emplacement de la source sonore en utilisant les éléments suivants :

est l'estimation de la position de la source sonore, est la position où chaque direction coupe la ligne avec une distance minimale, et est les facteurs pondérés. En tant que facteur de pondération , nous avons déterminé l'utilisation ou du tableau à la ligne avec une distance minimale.

Méthode d'apprentissage pour l'audition binaurale

L'apprentissage auditif binaural est une méthode bionique . Le capteur est une tête factice de robot avec 2 microphones à capteur avec le pavillon artificiel (réflecteur). La tête du robot possède 2 axes de rotation et peut pivoter horizontalement et verticalement. Le réflecteur provoque le changement du spectre dans un certain motif pour l'onde sonore de bruit blanc entrant et ce motif est utilisé pour le signal de la localisation verticale. L'indice pour la localisation horizontale est ITD. Le système utilise un processus d'apprentissage utilisant des réseaux de neurones en faisant tourner la tête avec une source sonore de bruit blanc fixe et en analysant le spectre. Les expériences montrent que le système peut bien identifier la direction de la source dans une certaine plage d'angle d'arrivée. Il ne peut pas identifier le son sortant de la plage en raison du modèle de spectre effondré du réflecteur. L'audition binaurale n'utilise que 2 microphones et est capable de se concentrer sur une source parmi plusieurs sources de bruits.

Dans la localisation sonore réelle, la tête du robot et le torse jouent un rôle fonctionnel, en plus des deux pavillons. Cela fonctionne comme un filtrage linéaire spatial et le filtrage est toujours quantifié en termes de fonction de transfert liée à la tête (HRTF). HRTF utilise également le capteur de tête de robot, qui est le modèle auditif binaural. Le HRTF peut être dérivé sur la base de divers indices de localisation. La localisation du son avec HRTF filtre le signal d'entrée avec un filtre conçu sur la base du HRTF. Au lieu d'utiliser les réseaux de neurones, une fonction de transfert liée à la tête est utilisée et la localisation est basée sur une approche de corrélation simple.

Voir plus : Fonction de transfert liée à la tête .

Analyse de phase spectrale de puissance croisée (CSP)

La méthode CSP est également utilisée pour le modèle binaural. L'idée est que l'angle d'arrivée peut être dérivé du délai d'arrivée (TDOA) entre deux microphones, et TDOA peut être estimé en trouvant les coefficients maximaux de CSP. Les coefficients CSP sont dérivés par :

Où et sont les signaux entrant dans le microphone et respectivement

le délai d'arrivée ( ) alors peut être estimé par :

La direction de la source sonore est

Où est la vitesse de propagation du son, est la fréquence d'échantillonnage et est la distance avec un délai maximum entre 2 microphones.

La méthode CPS ne nécessite pas les données de réponse impulsionnelle du système dont HRTF a besoin. Un algorithme d'espérance-maximisation est également utilisé pour localiser plusieurs sources sonores et réduire les erreurs de localisation. Le système est capable d'identifier plusieurs sources sonores en mouvement en utilisant seulement deux microphones.

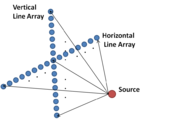

Réseau de lignes de capteurs 2D

Afin d'estimer l'emplacement d'une source dans l'espace 3D, deux réseaux de capteurs linéaires peuvent être placés horizontalement et verticalement. Un exemple est un line array 2D utilisé pour la localisation de sources sous-marines. En traitant les données de deux réseaux à l'aide de la méthode du maximum de vraisemblance , la direction, la portée et la profondeur de la source peuvent être identifiées simultanément. Contrairement au modèle auditif binaural, cette méthode est similaire à la méthode d' analyse spectrale . La méthode peut être utilisée pour localiser une source distante.

Réseau de bi-microphones auto-rotatifs

La rotation du réseau de deux microphones (également appelé réseau de deux microphones) conduit à un signal de différence de temps intercanal sinusoïdal (ICTD). Le déphasage du signal sinusoïdal résultant peut être directement mappé à l'angle d'azimut de la source sonore, et l'amplitude du signal ICTD peut être représentée en fonction de l'angle d'élévation de la source sonore et de la distance entre les deux microphones.

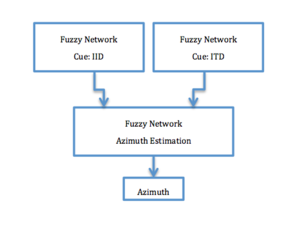

Approche des réseaux de neurones artificiels flous hiérarchiques

Le système de localisation du son de l'approche des réseaux de neurones artificiels hiérarchiques flous a été modélisé sur la localisation du son biologiquement binaurale. Certains animaux primitifs dotés de deux oreilles et d'un petit cerveau peuvent percevoir l'espace 3D et traiter les sons, bien que le processus ne soit pas entièrement compris. Certains animaux éprouvent des difficultés à localiser le son en 3D en raison de la petite taille de leur tête. De plus, la longueur d'onde du son de communication peut être beaucoup plus grande que le diamètre de leur tête, comme c'est le cas avec les grenouilles .

Basé sur des méthodes de localisation sonore binaurale antérieures, un système de réseau de neurones artificiels flous hiérarchiques combine des méthodes de localisation sonore de différence de temps interaural (basée sur l'ITD) et de différence d'intensité interaurale (basée sur l'IID) pour une précision plus élevée qui est similaire à celle des humains. Des réseaux de neurones artificiels flous hiérarchiques ont été utilisés dans le but d'obtenir la même précision de localisation du son que les oreilles humaines.

Les méthodes de localisation du son basées sur l'IID ou l'ITD ont un problème principal appelé confusion avant-arrière. Dans cette localisation sonore basée sur un système de réseau de neurones hiérarchique, pour résoudre ce problème, une estimation IID est avec estimation ITD. Ce système a été utilisé pour les sons à large bande et déployé pour des scénarios non stationnaires.

Localisation sonore 3D pour source sonore monaurale

En règle générale, la localisation du son est effectuée à l'aide de deux (ou plus) microphones. En utilisant la différence des temps d'arrivée d'un son aux deux microphones, on peut estimer mathématiquement la direction de la source sonore. Cependant, la précision avec laquelle un réseau de microphones peut localiser un son (en utilisant la différence de temps interaural ) est fondamentalement limitée par la taille physique du réseau. Si le réseau est trop petit, les microphones sont trop espacés les uns des autres de sorte qu'ils enregistrent tous essentiellement le même son (avec un ITF proche de zéro), ce qui rend extrêmement difficile l'estimation de l'orientation. Ainsi, il n'est pas rare que les réseaux de microphones s'étendent de quelques dizaines de centimètres (pour les applications de bureau) à plusieurs dizaines de mètres (pour la localisation sous-marine). Cependant, les réseaux de microphones de cette taille deviennent alors peu pratiques à utiliser sur de petits robots. même pour les gros robots, de tels réseaux de microphones peuvent être encombrants à monter et à manœuvrer. En revanche, la possibilité de localiser le son à l'aide d'un seul microphone (qui peut être extrêmement petit) offre le potentiel de dispositifs de localisation beaucoup plus compacts, ainsi que moins coûteux et moins puissants.

Approche HRTF conventionnelle

Une manière générale de mettre en œuvre la localisation du son 3D consiste à utiliser la fonction HRTF ( Head-related transfer function ). Tout d'abord, calculez les HRTF pour la localisation du son 3D, en formulant deux équations ; l'un représente le signal d'une source sonore donnée et l'autre indique le signal émis par les microphones de la tête du robot pour le son transféré depuis la source. Les données d'entrée monaurales sont traitées par ces HRTF et les résultats sont émis par un casque stéréo. L'inconvénient de cette méthode est que de nombreuses opérations paramétriques sont nécessaires pour que l'ensemble des filtres réalise la localisation 3D du son, ce qui entraîne une complexité de calcul élevée.

Implémentation DSP de la localisation du son 3D

Une mise en œuvre à base de DSP d'une approche de localisation du son en temps réel en 3D avec l'utilisation d'un DSP intégré permet de réduire la complexité de calcul Comme le montre la figure, la procédure de mise en œuvre de cet algorithme en temps réel est divisé en trois phases, (i) Division de fréquence, ( ii) Localisation du son, et (iii) Mixage. Dans le cas de la localisation du son 3D pour une source sonore monaurale, les données d'entrée audio sont divisées en deux : les canaux gauche et droit et les données d'entrée audio en séries temporelles sont traitées l'une après l'autre.

Une particularité de cette approche est que la bande de fréquence audible est divisée en trois afin qu'une procédure distincte de localisation sonore 3D puisse être exploitée pour chacune des trois sous-bandes.

Approche à un seul microphone

La localisation monaurale est rendue possible par la structure du pavillon (oreille externe) qui modifie le son d'une manière dépendante de son angle d'incidence. Une approche d'apprentissage automatique est adaptée à la localisation monaurale en utilisant un seul microphone et un « pavillon artificiel » (qui déforme le son d'une manière dépendante de la direction). L'approche modélise la distribution typique des sons naturels et artificiels, ainsi que les changements dépendant de la direction des sons induits par le pavillon. Les résultats expérimentaux montrent également que l'algorithme est capable de localiser assez précisément une large gamme de sons, tels que la parole humaine, les aboiements de chiens, les chutes d'eau, le tonnerre, etc. Contrairement aux réseaux de microphones, cette approche offre également le potentiel de dispositifs de localisation du son beaucoup plus compacts, ainsi qu'un coût et une puissance inférieurs.

Voir également

- Reconstitution sonore 3D

- Localisation de la source acoustique

- Enregistrement binaural

- Fonction de transfert liée à la tête

- Localisation du son 3D basée sur la perception

- Localisation du son

- Localisation verticale du son

![{\displaystyle csp_{ij}(k)={\text{IFFT}}\left\{{\frac {{\text{FFT}}[s_{i}(n)]\cdot {\text{FFT} }[s_{j}(n)]^{*}}{\left|{\text{FFT}}[s_{i}(n)]\right\vert \cdot \left|{\text{FFT} }[s_{j}(n)]\right\vert \quad }}\right\}\quad }](https://wikimedia.org/api/rest_v1/media/math/render/svg/7edeb234c5d51c97f20561585f8b3d5c55149f50)