Analyse de variance - Analysis of variance

L'analyse de la variance ( ANOVA ) est un ensemble de modèles statistiques et de leurs procédures d'estimation associées (telles que la « variation » parmi et entre les groupes) utilisés pour analyser les différences entre les moyennes. L'ANOVA a été développée par le statisticien Ronald Fisher . L'ANOVA est basée sur la loi de la variance totale , où la variance observée dans une variable particulière est divisée en composants attribuables à différentes sources de variation. Dans sa forme la plus simple, l'ANOVA fournit un test statistique pour savoir si deux ou plusieurs moyennes de population sont égales, et généralise donc le test t au-delà de deux moyennes.

Histoire

Alors que l'analyse de la variance a porté ses fruits au 20ème siècle, les antécédents s'étendent des siècles dans le passé selon Stigler. Ceux-ci incluent les tests d'hypothèses, le partitionnement de sommes de carrés, les techniques expérimentales et le modèle additif. Laplace effectuait des tests d'hypothèses dans les années 1770. Vers 1800, Laplace et Gauss ont développé la méthode des moindres carrés pour combiner les observations, qui a amélioré les méthodes alors utilisées en astronomie et en géodésie. Il a également initié de nombreuses études sur les contributions aux sommes de carrés. Laplace savait estimer une variance à partir d'une somme résiduelle (plutôt que totale) des carrés. En 1827, Laplace utilisait les méthodes des moindres carrés pour résoudre les problèmes d'ANOVA concernant les mesures des marées atmosphériques. Avant 1800, les astronomes avaient isolé les erreurs d'observation résultant des temps de réaction (l'« équation personnelle ») et avaient développé des méthodes pour réduire les erreurs. Les méthodes expérimentales utilisées dans l'étude de l'équation personnelle ont ensuite été acceptées par le domaine émergent de la psychologie qui a développé des méthodes expérimentales solides (complètement factorielles) auxquelles la randomisation et la mise en aveugle ont rapidement été ajoutées. Une explication non mathématique éloquente du modèle des effets additifs était disponible en 1885.

Ronald Fisher a introduit le terme variance et a proposé son analyse formelle dans un article de 1918 intitulé The Correlation Between Relatives on the Supposition of Mendelian Inheritance . Sa première application de l'analyse de la variance a été publiée en 1921. L'analyse de la variance est devenue largement connue après avoir été incluse dans le livre de Fisher de 1925, Statistical Methods for Research Workers .

Des modèles de randomisation ont été développés par plusieurs chercheurs. Le premier a été publié en polonais par Jerzy Neyman en 1923.

Exemple

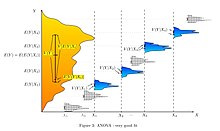

L'analyse de la variance peut être utilisée pour décrire des relations autrement complexes entre les variables. Une exposition canine en fournit un exemple. Une exposition canine n'est pas un échantillonnage aléatoire de la race : elle est généralement limitée aux chiens adultes, de race pure et exemplaires. Un histogramme du poids des chiens d'une exposition pourrait vraisemblablement être assez complexe, comme la distribution jaune-orange montrée dans les illustrations. Supposons que nous voulions prédire le poids d'un chien sur la base d'un certain ensemble de caractéristiques de chaque chien. Une façon de le faire est d' expliquer la distribution des poids en divisant la population canine en groupes en fonction de ces caractéristiques. Un regroupement réussi divisera les chiens de telle sorte que (a) chaque groupe a une faible variance de poids de chien (ce qui signifie que le groupe est relativement homogène) et (b) la moyenne de chaque groupe est distincte (si deux groupes ont la même moyenne, alors il n'est pas raisonnable de conclure que les groupes sont, en fait, séparés de manière significative).

Dans les illustrations de droite, les groupes sont identifiés comme X 1 , X 2 , etc. Dans la première illustration, les chiens sont divisés en fonction du produit (interaction) de deux groupes binaires : jeune vs vieux, et poil court vs long -à poil (par exemple, le groupe 1 est composé de jeunes chiens à poil court, le groupe 2 est composé de jeunes chiens à poil long, etc.). Étant donné que les distributions du poids des chiens au sein de chacun des groupes (indiquées en bleu) présentent une variance relativement importante et que les moyennes sont très similaires d'un groupe à l'autre, le regroupement des chiens selon ces caractéristiques ne permet pas d'expliquer efficacement la variation du poids des chiens. : savoir dans quel groupe appartient un chien ne nous permet pas de prédire son poids beaucoup mieux que de simplement savoir que le chien est dans une exposition canine. Ainsi, ce regroupement n'explique pas la variation de la distribution globale (jaune-orange).

Une tentative d'expliquer la répartition du poids en regroupant les chiens comme animal de compagnie par rapport à la race de travail et moins athlétique par rapport à plus athlétique serait probablement un peu plus réussie (ajustement juste). Les chiens d'exposition les plus lourds sont probablement de grandes races fortes et de travail, tandis que les races gardées comme animaux de compagnie ont tendance à être plus petites et donc plus légères. Comme le montre la deuxième illustration, les distributions ont des variances considérablement plus faibles que dans le premier cas, et les moyennes sont plus distinguables. Cependant, le chevauchement important des distributions, par exemple, signifie que nous ne pouvons pas distinguer X 1 et X 2 de manière fiable. Regrouper les chiens selon un tirage au sort peut produire des distributions qui se ressemblent.

Une tentative d'expliquer le poids par race est susceptible de produire un très bon ajustement. Tous les Chihuahuas sont légers et tous les St Bernard sont lourds. La différence de poids entre Setters et Pointers ne justifie pas des races séparées. L'analyse de variance fournit les outils formels pour justifier ces jugements intuitifs. Une utilisation courante de la méthode est l'analyse de données expérimentales ou le développement de modèles. La méthode présente certains avantages par rapport à la corrélation : toutes les données ne doivent pas être numériques et l'un des résultats de la méthode est un jugement sur la confiance dans une relation explicative.

Classes de modèles

Il existe trois classes de modèles utilisés dans l'analyse de la variance, et ceux-ci sont décrits ici.

Modèles à effets fixes

Le modèle à effets fixes (classe I) d'analyse de la variance s'applique aux situations dans lesquelles l'expérimentateur applique un ou plusieurs traitements aux sujets de l'expérience pour voir si les valeurs des variables de réponse changent. Cela permet à l'expérimentateur d'estimer les plages de valeurs des variables de réponse que le traitement générerait dans la population dans son ensemble.

Modèles à effets aléatoires

Le modèle à effets aléatoires (classe II) est utilisé lorsque les traitements ne sont pas fixes. Cela se produit lorsque les divers niveaux de facteurs sont échantillonnés à partir d'une population plus large. Parce que les niveaux eux-mêmes sont des variables aléatoires , certaines hypothèses et la méthode de contraste des traitements (une généralisation multivariable de différences simples) diffèrent du modèle à effets fixes.

Modèles à effets mixtes

Un modèle à effets mixtes (classe III) contient des facteurs expérimentaux de types à effets fixes et aléatoires, avec des interprétations et des analyses convenablement différentes pour les deux types.

Exemple : Des expériences d'enseignement pourraient être réalisées par un département collégial ou universitaire pour trouver un bon manuel d'introduction, chaque texte étant considéré comme un traitement. Le modèle à effets fixes comparerait une liste de textes candidats. Le modèle à effets aléatoires déterminerait s'il existe des différences importantes entre une liste de textes choisis au hasard. Le modèle à effets mixtes comparerait les textes (fixes) en place à des alternatives sélectionnées au hasard.

Définir des effets fixes et aléatoires s'est avéré insaisissable, avec des définitions concurrentes conduisant sans doute à un bourbier linguistique.

Hypothèses

L'analyse de la variance a été étudiée à partir de plusieurs approches, dont la plus courante utilise un modèle linéaire qui relie la réponse aux traitements et aux blocs. Notez que le modèle est linéaire dans les paramètres mais peut être non linéaire à travers les niveaux de facteur. L'interprétation est facile lorsque les données sont équilibrées entre les facteurs, mais une compréhension beaucoup plus approfondie est nécessaire pour les données déséquilibrées.

Analyse de manuels utilisant une distribution normale

L'analyse de la variance peut être présentée en termes de modèle linéaire , qui fait les hypothèses suivantes sur la distribution de probabilité des réponses :

- Indépendance des observations – il s'agit d'une hypothèse du modèle qui simplifie l'analyse statistique.

- Normalité – les distributions des résidus sont normales .

- Égalité (ou « homogénéité ») des variances, appelée homoscédasticité — la variance des données dans les groupes doit être la même.

Les hypothèses distinctes du modèle de manuel impliquent que les erreurs sont indépendantes, identiques et normalement distribuées pour les modèles à effets fixes, c'est-à-dire que les erreurs ( ) sont indépendantes et

Analyse basée sur la randomisation

Dans une expérience contrôlée randomisée , les traitements sont assignés au hasard à des unités expérimentales, suivant le protocole expérimental. Cette randomisation est objective et déclarée avant la réalisation de l'expérimentation. L'assignation aléatoire objective est utilisée pour tester la signification de l' hypothèse nulle , suivant les idées de CS Peirce et Ronald Fisher . Cette analyse basée sur la conception a été discutée et développée par Francis J. Anscombe à la station expérimentale de Rothamsted et par Oscar Kempthorne à l' Iowa State University . Kempthorne et ses étudiants font une hypothèse d' additivité de traitement unitaire , qui est discutée dans les livres de Kempthorne et David R. Cox .

Additivité de traitement unitaire

Dans sa forme la plus simple, l'hypothèse d'additivité du traitement unitaire stipule que la réponse observée de l'unité expérimentale lors de la réception du traitement peut être écrite comme la somme de la réponse de l'unité et de l'effet du traitement , c'est-à-dire

L'hypothèse d'additivité des traitements unitaires implique que, pour chaque traitement , le ième traitement a exactement le même effet sur chaque unité expérimentale.

L'hypothèse de l'additivité du traitement unitaire ne peut généralement pas être directement falsifiée , selon Cox et Kempthorne. Cependant, de nombreuses conséquences de l'additivité en unité de traitement peuvent être falsifiées. Pour une expérience randomisée, l'hypothèse d'additivité des traitements unitaires implique que la variance est constante pour tous les traitements. Par conséquent, par contraposition , une condition nécessaire pour l'additivité des traitements unitaires est que la variance soit constante.

L'utilisation de l'additivité du traitement unitaire et de la randomisation est similaire à l'inférence fondée sur le plan qui est standard dans l' échantillonnage d'enquêtes en population finie .

Modèle linéaire dérivé

Kempthorne utilise la distribution aléatoire et l'hypothèse d' additivité de traitement unitaire pour produire un modèle linéaire dérivé , très similaire au modèle de manuel discuté précédemment. Les statistiques de test de ce modèle linéaire dérivé sont étroitement approchées par les statistiques de test d'un modèle linéaire normal approprié, selon des théorèmes d'approximation et des études de simulation. Cependant, il existe des différences. Par exemple, l'analyse basée sur la randomisation aboutit à une corrélation faible mais (strictement) négative entre les observations. Dans l'analyse basée sur la randomisation, il n'y a aucune hypothèse de distribution normale et certainement aucune hypothèse d' indépendance . Au contraire, les observations sont dépendantes !

L'analyse basée sur la randomisation a l'inconvénient que son exposition implique une algèbre fastidieuse et beaucoup de temps. Étant donné que l'analyse basée sur la randomisation est compliquée et est étroitement approchée par l'approche utilisant un modèle linéaire normal, la plupart des enseignants mettent l'accent sur l'approche du modèle linéaire normal. Peu de statisticiens s'opposent à l'analyse basée sur un modèle d'expériences randomisées équilibrées.

Modèles statistiques pour les données d'observation

Cependant, lorsqu'elle est appliquée à des données provenant d'expériences non randomisées ou d' études observationnelles , l'analyse basée sur un modèle n'a pas la garantie de la randomisation. Pour les données d'observation, la dérivation des intervalles de confiance doit utiliser des modèles subjectifs , comme l'ont souligné Ronald Fisher et ses partisans. Dans la pratique, les estimations des effets du traitement à partir des études d'observation sont généralement souvent incohérentes. En pratique, les « modèles statistiques » et les données d'observation sont utiles pour proposer des hypothèses qui doivent être traitées avec la plus grande prudence par le public.

Résumé des hypothèses

L'analyse ANOVA basée sur un modèle normal suppose l'indépendance, la normalité et l'homogénéité des variances des résidus. L'analyse basée sur la randomisation suppose uniquement l'homogénéité des variances des résidus (en conséquence de l'additivité des traitements unitaires) et utilise la procédure de randomisation de l'expérience. Ces deux analyses nécessitent l' homoscédasticité , comme hypothèse pour l'analyse du modèle normal et comme conséquence de la randomisation et de l'additivité pour l'analyse basée sur la randomisation.

Cependant, des études de processus qui modifient les variances plutôt que les moyennes (appelées effets de dispersion) ont été menées avec succès à l'aide de l'ANOVA. Il n'y a pas d' hypothèses nécessaires pour l'ANOVA dans toute sa généralité, mais le test F utilisé pour les tests d'hypothèses ANOVA a des hypothèses et des limites pratiques qui sont d'un intérêt continu.

Les problèmes qui ne satisfont pas aux hypothèses de l'ANOVA peuvent souvent être transformés pour satisfaire les hypothèses. La propriété d'additivité de traitement unitaire n'est pas invariante sous un « changement d'échelle », de sorte que les statisticiens utilisent souvent des transformations pour atteindre l'additivité de traitement unitaire. Si la variable de réponse est censée suivre une famille paramétrique de distributions de probabilité, le statisticien peut alors spécifier (dans le protocole de l'expérience ou de l'étude d'observation) que les réponses doivent être transformées pour stabiliser la variance. En outre, un statisticien peut spécifier que des transformations logarithmiques soient appliquées aux réponses, qui sont censées suivre un modèle multiplicatif. Selon le théorème de l' équation fonctionnelle de Cauchy , le logarithme est la seule transformation continue qui transforme la multiplication réelle en addition.

Caractéristiques

L'ANOVA est utilisée dans l'analyse d'expériences comparatives, celles dans lesquelles seule la différence de résultats est intéressante. La signification statistique de l'expérience est déterminée par un rapport de deux variances. Ce rapport est indépendant de plusieurs modifications possibles des observations expérimentales : L'ajout d'une constante à toutes les observations ne modifie pas la signification. Multiplier toutes les observations par une constante n'altère pas la signification. Ainsi, le résultat de la signification statistique de l'ANOVA est indépendant du biais constant et des erreurs d'échelle ainsi que des unités utilisées pour exprimer les observations. À l'ère du calcul mécanique, il était courant de soustraire une constante de toutes les observations (lorsqu'elle équivalait à supprimer les chiffres de tête) pour simplifier la saisie des données. Ceci est un exemple de codage de données .

Logique

Les calculs de l'ANOVA peuvent être caractérisés comme le calcul d'un certain nombre de moyennes et de variances, la division de deux variances et la comparaison du rapport à une valeur du manuel pour déterminer la signification statistique. Le calcul d'un effet de traitement est alors trivial : « l'effet de tout traitement est estimé en faisant la différence entre la moyenne des observations qui reçoivent le traitement et la moyenne générale ».

Partitionnement de la somme des carrés

L'ANOVA utilise une terminologie standardisée traditionnelle. L'équation définitionnelle de la variance de l'échantillon est , où le diviseur est appelé les degrés de liberté (DF), la somme est appelée la somme des carrés (SS), le résultat est appelé le carré moyen (MS) et les termes au carré sont des écarts par rapport à la moyenne de l'échantillon. L'ANOVA estime 3 variances d'échantillon : une variance totale basée sur tous les écarts d'observation par rapport à la moyenne générale, une variance d'erreur basée sur tous les écarts d'observation par rapport à leurs moyennes de traitement appropriées et une variance de traitement. La variance de traitement est basée sur les écarts des moyennes de traitement par rapport à la moyenne générale, le résultat étant multiplié par le nombre d'observations dans chaque traitement pour tenir compte de la différence entre la variance des observations et la variance des moyennes.

La technique fondamentale est un partitionnement de la somme totale des carrés SS en composantes liées aux effets utilisés dans le modèle. Par exemple, le modèle d'une ANOVA simplifiée avec un type de traitement à différents niveaux.

Le nombre de degrés de liberté DF peut être partitionné de manière similaire : l'une de ces composantes (celle de l'erreur) spécifie une distribution du chi carré qui décrit la somme des carrés associée, alors qu'il en est de même pour les "traitements" s'il y a aucun effet thérapeutique.

Voir aussi Somme des carrés sans ajustement .

Le test F

Le test F est utilisé pour comparer les facteurs de l'écart total. Par exemple, dans l'ANOVA à un facteur ou à un facteur, la signification statistique est testée en comparant la statistique du test F

où MS est le carré moyen, = nombre de traitements et = nombre total de cas

à la distribution F avec , degrés de liberté. L'utilisation de la distribution F est un candidat naturel parce que la statistique de test est le rapport de deux sommes de carrés échelonnées dont chacune suit une distribution chi-carré échelonnée .

La valeur attendue de F est (où est la taille de l'échantillon de traitement) qui est 1 pour aucun effet de traitement. À mesure que les valeurs de F augmentent au-dessus de 1, les preuves sont de plus en plus incohérentes avec l'hypothèse nulle. Deux méthodes expérimentales apparentes d'augmentation de F consistent à augmenter la taille de l'échantillon et à réduire la variance d'erreur par des contrôles expérimentaux stricts.

Il existe deux méthodes pour conclure le test d'hypothèse ANOVA, qui produisent toutes deux le même résultat :

- La méthode du manuel consiste à comparer la valeur observée de F avec la valeur critique de F déterminée à partir des tableaux. La valeur critique de F est fonction des degrés de liberté du numérateur et du dénominateur et du niveau de signification (α). Si F F Critical , l'hypothèse nulle est rejetée.

- La méthode informatique calcule la probabilité (valeur p) d'une valeur de F supérieure ou égale à la valeur observée. L'hypothèse nulle est rejetée si cette probabilité est inférieure ou égale au seuil de signification (α).

Le test ANOVA F est connu pour être presque optimal dans le sens de minimiser les erreurs faussement négatives pour un taux fixe d'erreurs faussement positives (c'est-à-dire maximiser la puissance pour un niveau de signification fixe). Par exemple, pour tester l'hypothèse selon laquelle les divers traitements médicaux ont exactement le même effet, le F -test « de p de -values se rapproche de près le test de permutation » de valeurs p : L'approximation est particulièrement étroite lorsque la conception est équilibrée. De tels tests de permutation caractérisent les tests avec une puissance maximale contre toutes les hypothèses alternatives , comme observé par Rosenbaum. Le test ANOVA F (de l'hypothèse nulle selon laquelle tous les traitements ont exactement le même effet) est recommandé comme test pratique, en raison de sa robustesse contre de nombreuses distributions alternatives.

Logique étendue

L'ANOVA se compose de parties séparables ; le partitionnement des sources de variance et les tests d'hypothèses peuvent être utilisés individuellement. L'ANOVA est utilisée pour soutenir d'autres outils statistiques. La régression est d'abord utilisée pour ajuster des modèles plus complexes aux données, puis l'ANOVA est utilisée pour comparer les modèles dans le but de sélectionner des modèles simples (r) qui décrivent adéquatement les données. "De tels modèles pourraient être ajustés sans aucune référence à l'ANOVA, mais les outils ANOVA pourraient ensuite être utilisés pour donner un sens aux modèles ajustés et pour tester des hypothèses sur des lots de coefficients." « [Nous] pensons que l'analyse de la variance est un moyen de comprendre et de structurer des modèles à plusieurs niveaux, non pas comme une alternative à la régression, mais comme un outil permettant de résumer des inférences complexes de grande dimension... »

Pour un seul facteur

L'expérience la plus simple adaptée à l'analyse ANOVA est l'expérience complètement randomisée avec un seul facteur. Des expériences plus complexes avec un seul facteur impliquent des contraintes sur la randomisation et incluent des blocs complètement aléatoires et des carrés latins (et variantes : carrés gréco-latins, etc.). Les expériences les plus complexes partagent bon nombre des complexités de plusieurs facteurs. Une discussion relativement complète de l'analyse (modèles, résumés de données, table ANOVA) de l'expérience complètement randomisée est disponible .

Pour un seul facteur, il existe des alternatives d'analyse de variance à sens unique ; à savoir, le test F hétéroscédastique de Welch, le test F hétéroscédastique de Welch avec des moyennes tronquées et des variances winsorisées, le test de Brown-Forsythe, le test d'Alexander-Govern, le test du second ordre de James et le test de Kruskal-Wallis, disponibles dans le package R onewaytests .

Pour plusieurs facteurs

L'ANOVA se généralise à l'étude des effets de multiples facteurs. Lorsque l'expérience comprend des observations à toutes les combinaisons de niveaux de chaque facteur, elle est appelée factorielle . Les expériences factorielles sont plus efficaces qu'une série d'expériences à un seul facteur et l'efficacité augmente à mesure que le nombre de facteurs augmente. Par conséquent, les plans factoriels sont largement utilisés.

L'utilisation de l'ANOVA pour étudier les effets de plusieurs facteurs présente une complication. Dans une ANOVA à 3 facteurs avec des facteurs x, y et z, le modèle ANOVA inclut des termes pour les effets principaux (x, y, z) et des termes pour les interactions (xy, xz, yz, xyz). Tous les termes nécessitent des tests d'hypothèses. La prolifération des termes d'interaction augmente le risque qu'un test d'hypothèse produise un faux positif par hasard. Heureusement, l'expérience montre que les interactions d'ordre élevé sont rares. La capacité à détecter les interactions est un avantage majeur de l'ANOVA à facteurs multiples. Tester un facteur à la fois masque les interactions, mais produit des résultats expérimentaux apparemment incohérents.

La prudence est de mise en cas d'interactions ; Testez d'abord les termes d'interaction et développez l'analyse au-delà de l'ANOVA si des interactions sont trouvées. Les textes varient dans leurs recommandations concernant la poursuite de la procédure ANOVA après avoir rencontré une interaction. Les interactions compliquent l'interprétation des données expérimentales. Ni les calculs de signification ni les effets estimés du traitement ne peuvent être pris pour argent comptant. "Une interaction significative masquera souvent l'importance des effets principaux." Des méthodes graphiques sont recommandées pour améliorer la compréhension. La régression est souvent utile. Une longue discussion sur les interactions est disponible dans Cox (1958). Certaines interactions peuvent être supprimées (par des transformations) tandis que d'autres ne le peuvent pas.

Diverses techniques sont utilisées avec l'ANOVA à facteurs multiples pour réduire les dépenses. Une technique utilisée dans les plans factoriels consiste à minimiser la réplication (éventuellement pas de réplication avec le soutien de la supercherie analytique ) et à combiner des groupes lorsque les effets s'avèrent statistiquement (ou pratiquement) insignifiants. Une expérience avec de nombreux facteurs insignifiants peut s'effondrer en une seule avec quelques facteurs pris en charge par de nombreuses réplications.

Analyse associée

Certaines analyses sont nécessaires à l'appui de la conception de l'expérience tandis que d'autres analyses sont effectuées après que des changements dans les facteurs se sont avérés formellement produire des changements statistiquement significatifs dans les réponses. Parce que l'expérimentation est itérative, les résultats d'une expérience modifient les plans des expériences suivantes.

Analyse préparatoire

Le nombre d'unités expérimentales

Dans la conception d'une expérience, le nombre d'unités expérimentales est prévu pour satisfaire les objectifs de l'expérience. L'expérimentation est souvent séquentielle.

Les premières expériences sont souvent conçues pour fournir des estimations moyennes non biaisées des effets du traitement et de l'erreur expérimentale. Les expériences ultérieures sont souvent conçues pour tester une hypothèse selon laquelle un effet de traitement a une ampleur importante ; dans ce cas, le nombre d'unités expérimentales est choisi de manière à ce que l'expérience respecte le budget et ait une puissance adéquate, entre autres objectifs.

L'analyse de la taille de l'échantillon est généralement requise en psychologie. « Fournir des informations sur la taille de l'échantillon et le processus qui a conduit aux décisions relatives à la taille de l'échantillon. » L'analyse, qui est écrite dans le protocole expérimental avant la réalisation de l'expérimentation, est examinée dans les demandes de subvention et les commissions de révision administrative.

Outre l'analyse de puissance, il existe des méthodes moins formelles pour sélectionner le nombre d'unités expérimentales. Celles-ci incluent des méthodes graphiques basées sur la limitation de la probabilité d'erreurs faussement négatives, des méthodes graphiques basées sur une augmentation de variation attendue (au-dessus des résidus) et des méthodes basées sur l'obtention d'un intervalle de confiance souhaité.

Analyse de puissance

L'analyse de puissance est souvent appliquée dans le contexte de l'ANOVA afin d'évaluer la probabilité de rejeter avec succès l'hypothèse nulle si nous supposons un certain plan d'ANOVA, la taille de l'effet dans la population, la taille de l'échantillon et le niveau de signification. L'analyse de puissance peut aider à la conception de l'étude en déterminant quelle taille d'échantillon serait nécessaire afin d'avoir une chance raisonnable de rejeter l'hypothèse nulle lorsque l'hypothèse alternative est vraie.

Taille de l'effet

Plusieurs mesures d'effet standardisées ont été proposées pour l'ANOVA afin de résumer la force de l'association entre un ou plusieurs prédicteurs et la variable dépendante ou la différence standardisée globale du modèle complet. Les estimations standardisées de la taille de l'effet facilitent la comparaison des résultats entre les études et les disciplines. Cependant, alors que les tailles d'effet standardisées sont couramment utilisées dans une grande partie de la littérature professionnelle, une mesure non standardisée de la taille d'effet qui a des unités immédiatement « significatives » peut être préférable à des fins de rapport.

Confirmation du modèle

Parfois, des tests sont effectués pour déterminer si les hypothèses de l'ANOVA semblent être violées. Les résidus sont examinés ou analysés pour confirmer l' homoscédasticité et la normalité brute. Les résidus doivent avoir l'apparence d'un bruit (distribution normale moyenne nulle) lorsqu'ils sont tracés en fonction de tout, y compris le temps et les valeurs de données modélisées. Les tendances suggèrent des interactions entre les facteurs ou entre les observations.

Essais de suivi

Un effet statistiquement significatif dans l'ANOVA est souvent suivi de tests supplémentaires. Cela peut être fait afin d'évaluer quels groupes sont différents de quels autres groupes ou pour tester diverses autres hypothèses ciblées. Les tests de suivi sont souvent distingués selon qu'ils sont « planifiés » ( a priori ) ou « post hoc ». Les tests planifiés sont déterminés avant d'examiner les données, et les tests post hoc ne sont conçus qu'après avoir examiné les données (bien que le terme « post hoc » soit utilisé de manière incohérente).

Les tests de suivi peuvent être des comparaisons "simples" par paires de moyennes de groupes individuels ou peuvent être des comparaisons "composées" (par exemple, comparer la moyenne des groupes A, B et C à la moyenne du groupe D). Les comparaisons peuvent également examiner des tests de tendance, tels que des relations linéaires et quadratiques, lorsque la variable indépendante implique des niveaux ordonnés. Souvent, les tests de suivi intègrent une méthode d'ajustement pour le problème des comparaisons multiples .

Conceptions d'études

Il existe plusieurs types d'ANOVA. De nombreux statisticiens basent l'ANOVA sur la conception de l'expérience , en particulier sur le protocole qui spécifie l' assignation aléatoire des traitements aux sujets ; la description du protocole du mécanisme d'attribution doit inclure une spécification de la structure des traitements et de tout blocage . Il est également courant d'appliquer l'ANOVA aux données d'observation en utilisant un modèle statistique approprié.

Certaines conceptions populaires utilisent les types d'ANOVA suivants :

- L'ANOVA à un facteur est utilisée pour tester les différences entre deux ou plusieurs groupes indépendants (moyennes), par exemple différents niveaux d'application d'urée dans une culture, ou différents niveaux d'action antibiotique sur plusieurs espèces bactériennes différentes, ou différents niveaux d'effet de certains médicaments sur des groupes de patients. Cependant, si ces groupes ne sont pas indépendants et qu'il existe un ordre dans les groupes (comme une maladie légère, modérée et grave), ou dans la dose d'un médicament (comme 5 mg/mL, 10 mg/mL, 20 mg /mL) donnée au même groupe de patients, une estimation de tendance linéaire doit être utilisée. En règle générale, cependant, l'ANOVA à un facteur est utilisée pour tester les différences entre au moins trois groupes, puisque le cas à deux groupes peut être couvert par un test t . Quand il n'y a que deux moyens pour comparer, le test t et ANOVA F -test sont équivalentes; la relation entre l'ANOVA et t est donnée par F = t 2 .

- L' ANOVA factorielle est utilisée lorsqu'il y a plus d'un facteur.

- L' ANOVA à mesures répétées est utilisée lorsque les mêmes sujets sont utilisés pour chaque facteur (par exemple, dans une étude longitudinale ).

- L'analyse multivariée de la variance (MANOVA) est utilisée lorsqu'il y a plus d'une variable de réponse .

Précautions

Les expériences équilibrées (celles avec une taille d'échantillon égale pour chaque traitement) sont relativement faciles à interpréter ; les expériences déséquilibrées offrent plus de complexité. Pour l'ANOVA à un facteur (unidirectionnel), l'ajustement pour les données déséquilibrées est facile, mais l'analyse déséquilibrée manque à la fois de robustesse et de puissance. Pour les conceptions plus complexes, le manque d'équilibre entraîne d'autres complications. "La propriété d'orthogonalité des effets principaux et des interactions présentes dans les données équilibrées ne s'applique pas au cas déséquilibré. Cela signifie que les techniques habituelles d'analyse de la variance ne s'appliquent pas. Par conséquent, l'analyse des factorielles déséquilibrées est beaucoup plus difficile que celle des dessins." Dans le cas général, « L'analyse de la variance peut également être appliquée à des données déséquilibrées, mais alors les sommes des carrés, des carrés moyens et des rapports F dépendront de l'ordre dans lequel les sources de variation sont considérées. »

L'ANOVA est (en partie) un test de signification statistique. L'American Psychological Association (et de nombreuses autres organisations) est d'avis que le simple fait de déclarer une signification statistique est insuffisant et qu'il est préférable de déclarer des limites de confiance.

Généralisations

L'ANOVA est considérée comme un cas particulier de régression linéaire qui à son tour est un cas particulier du modèle linéaire général . Tous considèrent les observations comme la somme d'un modèle (ajustement) et d'un résidu (erreur) à minimiser.

Le test de Kruskal-Wallis et le test de Friedman sont des tests non paramétriques , qui ne reposent pas sur une hypothèse de normalité.

Lien avec la régression linéaire

Ci-dessous, nous clarifions le lien entre l'ANOVA à plusieurs facteurs et la régression linéaire.

Réorganisez linéairement les données de sorte que l' observation soit associée à une réponse et à des facteurs où désigne les différents facteurs et représente le nombre total de facteurs. En ANOVA unidirectionnelle et en ANOVA bidirectionnelle . De plus, nous supposons que le facteur a des niveaux, à savoir . Maintenant, nous pouvons encoder à chaud les facteurs dans le vecteur dimensionnel .

La fonction d'encodage à chaud est définie de telle sorte que l' entrée de soit

Avec cette notation en place, nous avons maintenant le lien exact avec la régression linéaire. Nous régressons simplement la réponse par rapport au vecteur . Cependant, il y a un problème d' identifiabilité . Afin de surmonter ces problèmes, nous supposons que la somme des paramètres dans chaque ensemble d'interactions est égale à zéro. À partir de là, on peut utiliser les statistiques F ou d'autres méthodes pour déterminer la pertinence des facteurs individuels.

Exemple

Nous pouvons considérer l'exemple d'interaction à 2 voies où nous supposons que le premier facteur a 2 niveaux et le deuxième facteur a 3 niveaux.

Définissez si et si , c'est-à - dire est l'encodage one-hot du premier facteur et est l'encodage one-hot du second facteur.

Avec ça,

Voir également

- Analyse de variance à un facteur ( ANOVA à un facteur )

- Analyse de variance à deux facteurs ( ANOVA à deux facteurs )

- ANOVA sur les rangs

- Analyse de composants ANOVA-simultanée

- Analyse de covariance ( ANCOVA )

- Analyse de la variance moléculaire (AMOVA)

- Analyse de la variance rythmique (ANORVA)

- Variante expliquée

- Estimation de tendance linéaire

- Analyse de variance à plan mixte

- Analyse multivariée de la variance ( MANOVA )

- Analyse multivariée de covariance ( MANCOVA )

- Analyse permutationnelle de la variance

- ANOVA à mesures répétées

- Décomposition de la variance

- Carrés moyens attendus

Notes de bas de page

Remarques

Les références

- Anscombe, FJ (1948). "La validité des expériences comparatives". Journal de la Royal Statistical Society. Série A (Général) . 111 (3) : 181-211. doi : 10.2307/2984159 . JSTOR 2984159 . MR 0030181 .

- Bailey, RA (2008). Conception d'expériences comparatives . La presse de l'Universite de Cambridge. ISBN 978-0-521-68357-9. Les chapitres de pré-publication sont disponibles en ligne.

- Belle, Gerald van (2008). Règles statistiques empiriques (2e éd.). Hoboken, New Jersey : Wiley. ISBN 978-0-470-14448-0.

- Cochran, William G. ; Cox, Gertrude M. (1992). Modèles expérimentaux (2e éd.). New York : Wiley. ISBN 978-0-471-54567-5.

- Cohen, Jacob (1988). Analyse de puissance statistique pour les sciences du comportement (2e éd.). Routledge ISBN 978-0-8058-0283-2

- Cohen, Jacob (1992). "Les statistiques une amorce de puissance". Bulletin psychologique . 112 (1) : 155-159. doi : 10.1037/0033-2909.112.1.155 . PMID 19565683 .

- Cox, David R. (1958). Planification des expériences . Réimprimé sous le numéro ISBN 978-0-471-57429-3

- Cox, David R. (2006). Principes d'inférence statistique . Cambridge New York : Cambridge University Press. ISBN 978-0-521-68567-2.

- Freedman, David A. (2005). Modèles statistiques : théorie et pratique , Cambridge University Press. ISBN 978-0-521-67105-7

- Gelman, André (2005). "L'analyse de la variance ? Pourquoi est-elle plus importante que jamais". Les Annales de la statistique . 33 : 1–53. arXiv : math/0504499 . doi : 10.1214/009053604000001048 . S2CID 13529149 .

- Gelman, André (2008). "Ecart, analyse de". Le nouveau dictionnaire Palgrave d'économie (2e éd.). Basingstoke, Hampshire New York : Palgrave Macmillan. ISBN 978-0-333-78676-5.

- Hinkelmann, Klaus & Kempthorne, Oscar (2008). Conception et analyse des expériences . I et II (deuxième éd.). Wiley. ISBN 978-0-470-38551-7.

- Howell, David C. (2002). Méthodes statistiques pour la psychologie (5e éd.). Pacific Grove, Californie : Duxbury/Thomson Learning. ISBN 978-0-534-37770-0.

- Kempthorne, Oscar (1979). La conception et l'analyse des expériences (réimpression corrigée de (1952) Wiley ed.). Robert E. Krieger. ISBN 978-0-88275-105-4.

- Lehmann, EL (1959) Test d'hypothèses statistiques. John Wiley & Fils.

- Montgomery, Douglas C. (2001). Conception et analyse d'expériences (5e éd.). New York : Wiley. ISBN 978-0-471-31649-7.

- Moore, David S. & McCabe, George P. (2003). Introduction à la pratique de la statistique (4e). WH Freeman & Co. ISBN 0-7167-9657-0

- Rosenbaum, Paul R. (2002). Études d'observation (2e éd.). New York : Springer-Verlag. ISBN 978-0-387-98967-9

- Scheffé, Henri (1959). L'analyse des écarts . New York : Wiley.

- Stigler, Stephen M. (1986). L' histoire de la statistique : la mesure de l' incertitude avant 1900 . Cambridge, Mass : Belknap Press de Harvard University Press. ISBN 978-0-674-40340-6.

- Wilkinson, Leland (1999). "Méthodes statistiques dans les revues de psychologie; Lignes directrices et explications". Psychologue américain . 5 (8) : 594–604. CiteSeerX 10.1.1.120.4818 . doi : 10.1037/0003-066X.54.8.594 .

Lectures complémentaires

- Box, G. ep (1953). "Non-normalité et tests sur les écarts". Biometrika . 40 (3/4) : 318-335. doi : 10.1093/biomet/40.3-4.318 . JSTOR 2333350 .

- Boîte, GEP (1954). "Certains théorèmes sur les formes quadratiques appliquées dans l'étude de l'analyse des problèmes de variance, I. Effet de l'inégalité de la variance dans la classification à sens unique" . Les Annales de la statistique mathématique . 25 (2) : 290. doi : 10.1214/aoms/1177728786 .

- Boîte, GEP (1954). "Quelques théorèmes sur les formes quadratiques appliquées dans l'étude de l'analyse des problèmes de variance, II. Effets de l'inégalité de la variance et de la corrélation entre les erreurs dans la classification à double sens" . Les Annales de la statistique mathématique . 25 (3) : 484. doi : 10.1214/aoms/1177728717 .

- Caliński, Tadeusz ; Kageyama, Sanpei (2000). Conceptions de blocs : Une approche de randomisation, Volume I : Analyse . Notes de cours en statistique. 150 . New York : Springer-Verlag. ISBN 978-0-387-98578-7.

- Christensen, Ronald (2002). Réponses d'avion aux questions complexes : La théorie des modèles linéaires (le troisième rédacteur). New York : Springer. ISBN 978-0-387-95361-8.

- Cox, David R. & Reid, Nancy M. (2000). La théorie des plans d'expériences . (Chapman & Hall/CRC). ISBN 978-1-58488-195-7

- Fisher, Ronald (1918). "Études sur la variation des cultures. I. Un examen du rendement du grain habillé de Broadbalk" (PDF) . Journal des sciences agricoles . 11 (2) : 107-135. doi : 10.1017/S0021859600003750 . hdl : 2440/15170 . Archivé de l'original (PDF) le 12 juin 2001.

- Freedman, David A. ; Pisani, Robert ; Purves, Roger (2007) Statistiques , 4e édition. WW Norton & Company ISBN 978-0-393-92972-0

-

Hettmansperger, TP ; McKean, JW (1998). Edward Arnold (éd.). Méthodes statistiques non paramétriques robustes . Bibliothèque de statistiques de Kendall. Tome 5 (première édition). New York : John Wiley & Sons, Inc. p. xiv+467 p. ISBN 978-0-340-54937-7. MR 1604954 .

|volume=a du texte supplémentaire ( aide ) - Lentner, Marvin ; Thomas Évêque (1993). Conception expérimentale et analyse (deuxième éd.). Blacksburg, Virginie : Compagnie de livre de vallée. ISBN 978-0-9616255-2-8.

- Tabachnick, Barbara G. & Fidell, Linda S. (2007). Utilisation de statistiques multivariées (5e éd.). Boston : édition internationale Pearson. ISBN 978-0-205-45938-4

- Wichura, Michael J. (2006). L'approche sans coordonnées des modèles linéaires . Série Cambridge en mathématiques statistiques et probabilistes. Cambridge : Cambridge University Press. p. xiv+199. ISBN 978-0-521-86842-6. MR 2283455 .

- Phadke, Madhav S. (1989). Ingénierie de la qualité utilisant une conception robuste . New Jersey : Prentice Hall PTR. ISBN 978-0-13-745167-8.

Liens externes

- Activité SOCR ANOVA

- Exemples de tous les modèles ANOVA et ANCOVA avec jusqu'à trois facteurs de traitement, y compris le bloc randomisé, le split plot, les mesures répétées et les carrés latins, et leur analyse en R (Université de Southampton)

- NIST/SEMATECH e-Handbook of Statistical Methods, section 7.4.3 : « Les moyennes sont-elles égales ?

- Analyse de variance : Introduction

![{\displaystyle v_{k}=[g_{1}(Z_{k,1}),g_{2}(Z_{k,2}),\ldots ,g_{B}(Z_{k,B}) ]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8476d72369317405eaaeddaea47d3d02a6f65689)

![{\displaystyle X_{k}=[a_{1},a_{2},b_{1},b_{2},b_{3},a_{1}\times b_{1},a_{1}\ fois b_{2},a_{1}\fois b_{3},a_{2}\fois b_{1},a_{2}\fois b_{2},a_{2}\fois b_{3}, 1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/9b0fb1da30e53e31a5462b3d096076dada5f8295)

![{\displaystyle X_{k}=[0,1,1,0,0,0,0,0,1,0,0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/71b98d7ab058cee5179fa785b602b7b6a44ff624)