Interférence catastrophique - Catastrophic interference

L'interférence catastrophique , également connue sous le nom d' oubli catastrophique , est la tendance d'un réseau de neurones artificiels à oublier complètement et brusquement des informations précédemment apprises lors de l'apprentissage de nouvelles informations. Les réseaux de neurones sont une partie importante de l' approche réseau et approche connexionniste de sciences cognitives. Avec ces réseaux, les capacités humaines telles que la mémoire et l'apprentissage peuvent être modélisées à l'aide de simulations informatiques. Les interférences catastrophiques sont un problème important à prendre en compte lors de la création de modèles de mémoire connexionnistes. Il a été initialement porté à l'attention de la communauté scientifique par des recherches de McCloskey et Cohen (1989) et de Ratcliff (1990). C'est une manifestation radicale du dilemme « sensibilité-stabilité » ou du dilemme « stabilité-plasticité ». Plus précisément, ces problèmes font référence au défi de créer un réseau de neurones artificiels sensible aux nouvelles informations, mais non perturbé par celles-ci. Les tables de correspondance et les réseaux connexionnistes se situent des deux côtés du spectre de plasticité de stabilité. Le premier reste complètement stable en présence de nouvelles informations mais n'a pas la capacité degénéraliser , c'est-à-dire inférer des principes généraux à partir de nouvelles entrées. D'un autre côté, les réseaux connexionnistes comme le réseau de rétropropagation standard peuvent se généraliser à des entrées invisibles, mais ils sont très sensibles aux nouvelles informations. Les modèles de rétropropagation peuvent être considérés comme de bons modèles de mémoire humaine dans la mesure où ils reflètent la capacité humaine à généraliser, mais ces réseaux présentent souvent moins de stabilité que la mémoire humaine. Notamment, ces réseaux de rétropropagation sont sensibles à des interférences catastrophiques. C'est un problème lors de la modélisation de la mémoire humaine, car contrairement à ces réseaux, les humains ne présentent généralement pas d'oubli catastrophique.

Historique des interférences catastrophiques

Le terme d'interférence catastrophique a été inventé à l'origine par McCloskey et Cohen (1989), mais a également été porté à l'attention de la communauté scientifique par les recherches de Ratcliff (1990).

Le problème d'apprentissage séquentiel : McCloskey et Cohen (1989)

McCloskey et Cohen (1989) ont noté le problème des interférences catastrophiques au cours de deux expériences différentes avec la modélisation du réseau de neurones par rétropropagation.

- Expérience 1 : Apprendre les faits d'addition des uns et des deux

Dans leur première expérience, ils ont entraîné un réseau de neurones à rétropropagation standard sur un seul ensemble d'entraînement composé de 17 problèmes à un chiffre (c'est-à-dire 1 + 1 à 9 + 1 et 1 + 2 à 1 + 9) jusqu'à ce que le réseau puisse représenter et répondre correctement à chacun d'eux. L'erreur entre le résultat réel et le résultat souhaité diminuait régulièrement au fil des sessions de formation, ce qui reflétait le fait que le réseau avait appris à mieux représenter les résultats cibles au cours des essais. Ensuite, ils ont formé le réseau sur un seul ensemble d'apprentissage composé de 17 problèmes à deux chiffres (c'est-à-dire 2 + 1 à 2 + 9, et 1 + 2 à 9 + 2) jusqu'à ce que le réseau puisse représenter, répondre correctement à tous les eux. Ils ont noté que leur procédure était similaire à la façon dont un enfant apprendrait leurs faits supplémentaires. Après chaque essai d'apprentissage sur les faits à deux, le réseau a été testé pour sa connaissance à la fois des faits d'addition à un et à deux. Comme les faits un, les faits deux ont été facilement appris par le réseau. Cependant, McCloskey et Cohen ont noté que le réseau n'était plus en mesure de répondre correctement aux problèmes d'addition de un même après un essai d'apprentissage des problèmes d'addition de deux. Le modèle de sortie produit en réponse à ces faits ressemblait souvent plus à un modèle de sortie pour un nombre incorrect qu'au modèle de sortie pour un nombre correct. Ceci est considéré comme une quantité drastique d'erreurs. De plus, les problèmes 2+1 et 2+1, qui ont été inclus dans les deux ensembles d'apprentissage, ont même montré des perturbations dramatiques lors des premiers essais d'apprentissage des deux faits.

- Expérience 2 : Réplication de l'étude de Barnes et Underwood (1959) Dans leur deuxième modèle connexionniste, McCloskey et Cohen ont tenté de répliquer l'étude sur l'interférence rétroactive chez l'homme de Barnes et Underwood (1959). Ils ont entraîné le modèle sur des listes AB et AC et ont utilisé un modèle de contexte dans le vecteur d'entrée (modèle d'entrée), pour différencier les listes. Plus précisément, le réseau a été formé pour répondre avec la bonne réponse B lorsqu'on lui montre le stimulus A et le modèle de contexte AB et pour répondre avec la bonne réponse C lorsqu'on lui montre le stimulus A et le modèle de contexte AC. Lorsque le modèle a été entraîné simultanément sur les éléments AB et AC, le réseau a facilement appris toutes les associations correctement. Dans la formation séquentielle, la liste AB a été formée en premier, suivie de la liste AC. Après chaque présentation de la liste AC, les performances ont été mesurées pour les listes AB et AC. Ils ont constaté que la quantité de formation sur la liste AC dans l'étude de Barnes et Underwood qui a conduit à 50% de réponses correctes, conduit à près de 0% de réponses correctes par le réseau de rétropropagation. En outre, ils ont constaté que le réseau avait tendance à afficher des réponses qui ressemblaient au modèle de réponse C lorsque le réseau était invité à donner le modèle de réponse B. Cela indiquait que la liste AC avait apparemment écrasé la liste AB. Cela pourrait être comparé à l'apprentissage du mot chien, suivi de l'apprentissage du mot tabouret, puis de la découverte que vous ne pouvez pas bien reconnaître le mot chat, mais pensez plutôt au mot tabouret lorsqu'il est présenté avec le mot chien.

McCloskey et Cohen ont essayé de réduire les interférences grâce à un certain nombre de manipulations, notamment la modification du nombre d'unités cachées, la modification de la valeur du paramètre de taux d'apprentissage, le surentraînement sur la liste AB, le gel de certains poids de connexion, la modification des valeurs cibles 0 et 1 au lieu de 0,1 et 0,9 . Cependant, aucune de ces manipulations n'a réduit de manière satisfaisante les interférences catastrophiques présentées par les réseaux.

Dans l'ensemble, McCloskey et Cohen (1989) ont conclu que :

- au moins une certaine interférence se produira chaque fois qu'un nouvel apprentissage modifie les poids impliqués représentant

- plus la quantité de nouveaux apprentissages est importante, plus la perturbation des anciennes connaissances est importante

- l'interférence était catastrophique dans les réseaux de rétropropagation lorsque l'apprentissage était séquentiel mais pas simultané

Contraintes imposées par les fonctions d'apprentissage et d'oubli : Ratcliff (1990)

Ratcliff (1990) a utilisé plusieurs ensembles de modèles de rétropropagation appliqués aux procédures de mémoire de reconnaissance standard, dans lesquelles les éléments étaient appris de manière séquentielle. Après avoir inspecté les modèles de performance de reconnaissance, il a découvert deux problèmes majeurs :

- Les informations bien apprises ont été catastrophiquement oubliées alors que de nouvelles informations ont été apprises dans les petits et grands réseaux de rétropropagation.

Même un essai d'apprentissage avec de nouvelles informations a entraîné une perte significative des anciennes informations, en parallèle avec les conclusions de McCloskey et Cohen (1989). Ratcliff a également constaté que les sorties résultantes étaient souvent un mélange de l'entrée précédente et de la nouvelle entrée. Dans les réseaux plus vastes, les éléments appris en groupe (par exemple AB puis CD) étaient plus résistants à l'oubli que les éléments appris individuellement (par exemple A puis B puis C...). Cependant, l'oubli des éléments appris en groupe était encore important. L'ajout de nouvelles unités cachées au réseau n'a pas réduit les interférences.

- La discrimination entre les éléments étudiés et les éléments inédits diminuait à mesure que le réseau en apprenait davantage.

Ce résultat contredit les études sur la mémoire humaine, qui indiquaient que la discrimination augmente avec l'apprentissage. Ratcliff a tenté d'atténuer ce problème en ajoutant des « nœuds de réponse » qui répondraient de manière sélective aux anciennes et nouvelles entrées. Cependant, cette méthode n'a pas fonctionné car ces nœuds de réponse deviendraient actifs pour toutes les entrées. Un modèle qui utilisait un modèle de contexte n'a pas non plus réussi à augmenter la discrimination entre les éléments nouveaux et anciens.

Solutions proposées

La principale cause d'interférence catastrophique semble être le chevauchement des représentations au niveau de la couche cachée des réseaux de neurones distribués. Dans une représentation distribuée, chaque entrée a tendance à créer des changements dans les poids de nombreux nœuds. L'oubli catastrophique se produit parce que lorsque de nombreux poids où "la connaissance est stockée" sont modifiés, il est peu probable que la connaissance antérieure soit conservée intacte. Au cours de l'apprentissage séquentiel, les entrées se mélangent, les nouvelles entrées se superposant aux anciennes. Une autre façon de conceptualiser cela est de visualiser l'apprentissage comme un mouvement à travers un espace de poids. Cet espace de poids peut être assimilé à une représentation spatiale de toutes les combinaisons possibles de poids que pourrait posséder le réseau. Lorsqu'un réseau apprend pour la première fois à représenter un ensemble de modèles, il trouve un point dans l'espace des poids qui lui permet de reconnaître tous ces modèles. Cependant, lorsque le réseau apprend alors un nouvel ensemble de modèles, il se déplacera vers un endroit dans l'espace de poids pour lequel la seule préoccupation est la reconnaissance des nouveaux modèles. Pour reconnaître les deux ensembles de modèles, le réseau doit trouver une place dans l'espace de poids appropriée pour reconnaître à la fois les nouveaux et les anciens modèles.

Vous trouverez ci-dessous un certain nombre de techniques qui ont un soutien empirique pour réduire avec succès les interférences catastrophiques dans les réseaux de neurones à rétropropagation :

Orthogonalité

Bon nombre des premières techniques pour réduire le chevauchement des représentations impliquaient de rendre les vecteurs d'entrée ou les modèles d'activation des unités cachées orthogonaux les uns aux autres. Lewandowsky et Li (1995) ont noté que l'interférence entre les modèles séquentiellement appris est minimisée si les vecteurs d'entrée sont orthogonaux les uns aux autres. Les vecteurs d'entrée sont dits orthogonaux les uns aux autres si le produit par paires de leurs éléments sur les deux vecteurs est égal à zéro. Par exemple, les motifs [0,0,1,0] et [0,1,0,0] sont dits orthogonaux car (0×0 + 0×1 + 1×0 + 0×0) = 0. L'une des techniques permettant de créer des représentations orthogonales au niveau des couches cachées implique un codage de caractéristiques bipolaire (c'est-à-dire un codage utilisant -1 et 1 plutôt que 0 et 1). Les motifs orthogonaux ont tendance à produire moins d'interférences les uns avec les autres. Cependant, tous les problèmes d'apprentissage ne peuvent pas être représentés à l'aide de ces types de vecteurs et certaines études rapportent que le degré d'interférence est toujours problématique avec les vecteurs orthogonaux.

Technique d'affûtage des nœuds

Selon français (1991), l' interférence catastrophique se pose dans feedforward réseaux de rétropropagation du fait de l'interaction des activations de noeud ou de chevauchement d'activation, qui se produit dans les représentations distribuées dans la couche cachée. Les réseaux de neurones qui emploient des représentations très localisées ne présentent pas d'interférences catastrophiques en raison de l'absence de chevauchement au niveau de la couche cachée. French a donc suggéré que la réduction de la valeur du chevauchement d'activation au niveau de la couche cachée réduirait les interférences catastrophiques dans les réseaux distribués. Plus précisément, il a proposé que cela puisse être fait en changeant les représentations distribuées au niveau de la couche cachée en représentations «semi-distribuées». Une représentation 'semi-distribuée' a moins de nœuds cachés actifs, et/ou une valeur d'activation plus faible pour ces nœuds, pour chaque représentation, ce qui fera que les représentations des différentes entrées se chevaucheront moins au niveau de la couche cachée. French a recommandé que cela puisse être fait par « l'affûtage d'activation », une technique qui augmente légèrement l'activation d'un certain nombre des nœuds les plus actifs de la couche cachée, réduit légèrement l'activation de toutes les autres unités, puis modifie l'entrée en -des poids de couche cachés pour refléter ces changements d'activation (similaire à la rétropropagation d'erreurs).

Règle de nouveauté

Kortge (1990) a proposé une règle d'apprentissage pour l'entraînement des réseaux de neurones, appelée « règle de nouveauté », pour aider à atténuer les interférences catastrophiques. Comme son nom l'indique, cette règle aide le réseau de neurones à apprendre uniquement les composants d'une nouvelle entrée qui diffèrent d'une ancienne entrée. Par conséquent, la règle de nouveauté ne modifie que les poids qui n'étaient pas auparavant dédiés au stockage d'informations, réduisant ainsi le chevauchement des représentations au niveau des unités cachées. Afin d'appliquer la règle de nouveauté, lors de l'apprentissage, le modèle d'entrée est remplacé par un vecteur de nouveauté qui représente les composants qui diffèrent. Lorsque la règle de nouveauté est utilisée dans un réseau de rétropropagation standard, il n'y a pas ou moins d'oubli des anciens éléments lorsque de nouveaux éléments sont présentés séquentiellement. Cependant, une limitation est que cette règle ne peut être utilisée qu'avec des réseaux à encodeur automatique ou auto-associatifs, dans lesquels la réponse cible pour la couche de sortie est identique au modèle d'entrée.

Réseaux de pré-formation

McRae et Hetherington (1993) ont soutenu que les humains, contrairement à la plupart des réseaux de neurones, n'assument pas de nouvelles tâches d'apprentissage avec un ensemble aléatoire de poids. Au contraire, les gens ont tendance à apporter une richesse de connaissances préalables à une tâche, ce qui permet d'éviter le problème des interférences. Ils ont montré que lorsqu'un réseau est pré-entraîné sur un échantillon aléatoire de données avant de commencer une tâche d'apprentissage séquentiel, cette connaissance préalable limitera naturellement la manière dont les nouvelles informations peuvent être incorporées. Cela se produirait parce qu'un échantillon aléatoire de données d'un domaine qui a un degré élevé de structure interne, comme la langue anglaise, la formation capturerait les régularités, ou les modèles récurrents, trouvés dans ce domaine. Étant donné que le domaine est basé sur des régularités, un élément nouvellement appris aura tendance à être similaire aux informations apprises précédemment, ce qui permettra au réseau d'incorporer de nouvelles données avec peu d'interférences avec les données existantes. Plus précisément, un vecteur d'entrée qui suit le même modèle de régularités que les données précédemment formées ne devrait pas provoquer un modèle d'activation radicalement différent au niveau de la couche cachée ou modifier radicalement les poids.

Répétition

Robins (1995) a décrit que l'oubli catastrophique peut être évité par des mécanismes de répétition. Cela signifie que lorsque de nouvelles informations sont ajoutées, le réseau de neurones est recyclé sur certaines des informations précédemment apprises. En général, cependant, les informations apprises précédemment peuvent ne pas être disponibles pour un tel recyclage. Une solution pour cela est la "pseudo-répétition", dans laquelle le réseau n'est pas recyclé sur les données réelles précédentes mais sur leurs représentations. Plusieurs méthodes sont basées sur ce mécanisme général.

Réseaux pseudo-récurrents

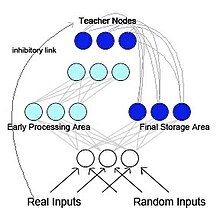

French (1997) a proposé un réseau de rétropropagation pseudo-récurrent (voir Figure 2). Dans ce modèle, le réseau est séparé en deux sous-réseaux fonctionnellement distincts mais en interaction. Ce modèle est d'inspiration biologique et est basé sur les recherches de McClelland et al. (1995) McClelland et ses collègues ont suggéré que l' hippocampe et le néocortex agissent comme des systèmes de mémoire séparés mais complémentaires, l'hippocampe pour le stockage de la mémoire à court terme et le néocortex pour le stockage de la mémoire à long terme . Les informations initialement stockées dans l'hippocampe peuvent être "transférées" vers le néocortex au moyen d'une réactivation ou d'une relecture. Dans le réseau pseudo-récurrent, l'un des sous-réseaux agit comme une zone de traitement précoce, semblable à l'hippocampe, et fonctionne pour apprendre de nouveaux modèles d'entrée. L'autre sous-réseau agit comme une zone de stockage final, semblable au néocortex. Cependant, contrairement à McClelland et al. (1995), la zone de stockage final renvoie la représentation générée en interne à la zone de traitement précoce. Cela crée un réseau récurrent. French a proposé que cet entrelacement d'anciennes représentations avec de nouvelles représentations soit le seul moyen de réduire l'oubli radical. Étant donné que le cerveau n'aurait probablement pas accès aux modèles d'entrée d'origine, les modèles qui seraient renvoyés au néocortex seraient des représentations générées en interne appelées pseudo-modèles . Ces pseudo-modèles sont des approximations des entrées précédentes et ils peuvent être entrelacés avec l'apprentissage de nouvelles entrées.

Mémoire auto-rafraichissante

Inspiré par et indépendamment d'Ans et Rousset (1997) a également proposé une architecture neuronale artificielle à deux réseaux avec auto-rafraîchissement de la mémoire qui surmonte les interférences catastrophiques lorsque des tâches d'apprentissage séquentiel sont effectuées dans des réseaux distribués formés par rétropropagation. Le principe est d'apprendre de nouveaux modèles externes en même temps que des pseudo-modèles générés en interne, ou « pseudo-mémoires », qui reflètent les informations précédemment apprises. Ce qui distingue principalement ce modèle de ceux qui utilisent la pseudo-répétition classique dans les réseaux multicouches à action anticipée est un processus de réverbération utilisé pour générer des pseudo-modèles. Après un certain nombre de réinjections d'activité à partir d'une seule graine aléatoire, ce processus a tendance à aller jusqu'aux attracteurs de réseau non linéaires qui sont plus adaptés pour capturer de manière optimale la structure profonde de la connaissance distribuée dans les poids de connexion que la seule passe d'activité anticipée utilisée dans le pseudo -répétition. La procédure d'auto-rafraîchissement de la mémoire s'est avérée très efficace dans les processus de transfert et dans l'apprentissage en série de séquences temporelles de motifs sans oubli catastrophique.

Relecture générative

Ces dernières années, la pseudo-répétition a regagné en popularité grâce aux progrès des capacités des modèles génératifs profonds . Lorsque de tels modèles génératifs profonds sont utilisés pour générer les « pseudo-données » à répéter, cette méthode est généralement appelée relecture générative. Une telle relecture générative peut prévenir efficacement l'oubli catastrophique, en particulier lorsque la relecture est effectuée dans les couches cachées plutôt qu'au niveau de l'entrée.

Apprentissage latent

L'apprentissage latent est une technique utilisée par Gutstein & Stump (2015) pour atténuer les interférences catastrophiques en tirant parti de l' apprentissage par transfert . Cette approche essaie de trouver des encodages optimaux pour toutes les nouvelles classes à apprendre, afin qu'elles soient le moins susceptibles d'interférer de manière catastrophique avec les réponses existantes. Étant donné qu'un réseau a appris à discriminer parmi un ensemble de classes à l'aide de codes de sortie de correction d'erreur (ECOC) (par opposition à 1 codes chauds ), les codages optimaux pour les nouvelles classes sont choisis en observant les réponses moyennes du réseau à celles-ci. Étant donné que ces réponses moyennes sont survenues lors de l'apprentissage de l'ensemble de classes d'origine sans aucune exposition aux nouvelles classes , elles sont appelées « encodages appris de manière latente ». Cette terminologie emprunte au concept d' apprentissage latent , tel qu'introduit par Tolman en 1930. En effet, cette technique utilise l'apprentissage par transfert pour éviter les interférences catastrophiques, en rendant les réponses d'un réseau aux nouvelles classes aussi cohérentes que possible avec les réponses existantes aux classes déjà apprises.

Consolidation élastique du poids

Kirkpatrick et al. (2017) ont proposé la consolidation de poids élastique (EWC), une méthode pour entraîner séquentiellement un seul réseau de neurones artificiels sur plusieurs tâches. Cette technique suppose que certains poids du réseau de neurones entraînés sont plus importants que d'autres pour les tâches déjà apprises. Au cours de l'entraînement du réseau de neurones sur une nouvelle tâche, les modifications apportées aux poids du réseau sont d'autant moins probables que leur importance est grande. Pour estimer l'importance des poids du réseau, l'EWC utilise des mécanismes probabilistes, en particulier la matrice d'information de Fisher, mais cela peut être fait d'autres manières également.