Taille de l'effet - Effect size

En statistique , une taille d'effet est un nombre mesurant la force de la relation entre deux variables dans une population, ou une estimation basée sur un échantillon de cette quantité. Il peut faire référence à la valeur d'une statistique calculée à partir d'un échantillon de données , à la valeur d'un paramètre pour une population hypothétique ou à l'équation qui opérationnalise la manière dont les statistiques ou les paramètres conduisent à la valeur de la taille de l'effet. Des exemples de tailles d'effet incluent la corrélation entre deux variables, le coefficient de régression dans une régression, la différence moyenne ou le risque qu'un événement particulier (comme une crise cardiaque) se produise. Les tailles d'effet complètent les tests d'hypothèses statistiques et jouent un rôle important dans les analyses de puissance , la planification de la taille de l'échantillon et dans les méta-analyses . Le groupe de méthodes d'analyse des données concernant les tailles d'effet est appelé statistiques d'estimation .

La taille de l'effet est un élément essentiel lors de l'évaluation de la force d'une allégation statistique, et c'est le premier élément (ampleur) des critères MAGIC . L' écart type de la taille de l'effet est d'une importance critique, car il indique le degré d'incertitude inclus dans la mesure. Un écart type trop grand rendra la mesure presque dénuée de sens. Dans la méta-analyse, où le but est de combiner plusieurs tailles d'effet, l'incertitude de la taille de l'effet est utilisée pour peser les tailles d'effet, de sorte que les grandes études sont considérées comme plus importantes que les petites études. L'incertitude de la taille de l'effet est calculée différemment pour chaque type de taille de l'effet, mais nécessite généralement de connaître uniquement la taille de l'échantillon de l'étude ( N ) ou le nombre d'observations ( n ) dans chaque groupe.

La déclaration des tailles d'effet ou des estimations de celles-ci (estimation de l'effet [EE], estimation de l'effet) est considérée comme une bonne pratique lors de la présentation des résultats de la recherche empirique dans de nombreux domaines. La déclaration des tailles d'effet facilite l'interprétation de l'importance d'un résultat de recherche, contrairement à sa signification statistique . Les tailles d'effet sont particulièrement importantes en sciences sociales et en recherche médicale (où la taille de l' effet du traitement est importante).

Les tailles d'effet peuvent être mesurées en termes relatifs ou absolus. Dans les tailles d'effet relatives, deux groupes sont directement comparés l'un à l'autre, comme dans les rapports de cotes et les risques relatifs . Pour les tailles d'effet absolues, une valeur absolue plus élevée indique toujours un effet plus fort. De nombreux types de mesures peuvent être exprimés en termes absolus ou relatifs, et ceux-ci peuvent être utilisés ensemble car ils véhiculent des informations différentes. Un groupe de travail de premier plan dans la communauté de la recherche en psychologie a fait la recommandation suivante :

Présentez toujours les tailles d'effet pour les critères de jugement principaux... Si les unités de mesure sont significatives à un niveau pratique (par exemple, le nombre de cigarettes fumées par jour), alors nous préférons généralement une mesure non standardisée (coefficient de régression ou différence moyenne) à une mesure standardisée ( r ou d ).

Aperçu

Tailles de l'effet de la population et de l'échantillon

Comme dans l'estimation statistique , la véritable taille de l'effet est distinguée de la taille de l'effet observé, par exemple pour mesurer le risque de maladie dans une population (la taille de l'effet de la population), on peut mesurer le risque au sein d'un échantillon de cette population (la taille de l'effet de l'échantillon) . Les conventions pour décrire les tailles d'effet vraies et observées suivent les pratiques statistiques standard. Une approche courante consiste à utiliser des lettres grecques comme ρ [rho] pour désigner les paramètres de population et des lettres latines comme r pour désigner la statistique correspondante. Alternativement, un "chapeau" peut être placé sur le paramètre de population pour désigner la statistique, par exemple avec l'estimation du paramètre .

Comme dans tout contexte statistique, les tailles d'effet sont estimées avec une erreur d'échantillonnage et peuvent être biaisées à moins que l'estimateur de taille d'effet utilisé ne soit approprié à la manière dont les données ont été échantillonnées et à la manière dont les mesures ont été effectuées. Un exemple de ceci est le biais de publication , qui se produit lorsque les scientifiques ne rapportent des résultats que lorsque les tailles d'effet estimées sont importantes ou statistiquement significatives. Par conséquent, si de nombreux chercheurs mènent des études avec une faible puissance statistique, les tailles d'effet rapportées auront tendance à être plus importantes que les effets réels (de population), le cas échéant. Un autre exemple où les tailles d'effet peuvent être faussées est dans une expérience à essais multiples, où le calcul de la taille d'effet est basé sur la réponse moyenne ou agrégée à travers les essais.

Relation avec les statistiques de test

Les tailles d'effet basées sur l'échantillon se distinguent des statistiques de test utilisées dans les tests d'hypothèses, en ce sens qu'elles estiment la force (l'ampleur) d'une relation apparente, par exemple, plutôt que d'attribuer un niveau de signification indiquant si l'ampleur de la relation observée pourrait être due au hasard. La taille de l'effet ne détermine pas directement le niveau de signification, ou vice versa. Étant donné une taille d'échantillon suffisamment grande, une comparaison statistique non nulle montrera toujours un résultat statistiquement significatif à moins que la taille de l'effet de population soit exactement zéro (et même là, elle montrera une signification statistique au taux de l'erreur de type I utilisée). Par exemple, un échantillon de corrélation de Pearson coefficient de 0,01 est statistiquement significatif si la taille de l' échantillon est 1000. Rapport que l'importante p -value de cette analyse pourrait induire en erreur si une corrélation de 0,01 est trop faible pour être d'intérêt pour une application particulière.

Tailles d'effet standardisées et non standardisées

Le terme taille de l'effet peut désigner une mesure standardisée de l'effet (telle que r , le d de Cohen ou le rapport des cotes ) ou une mesure non standardisée (par exemple, la différence entre les moyennes des groupes ou les coefficients de régression non standardisés). Les mesures standardisées de l'ampleur de l'effet sont généralement utilisées lorsque :

- les métriques des variables étudiées n'ont pas de signification intrinsèque (par exemple, un score à un test de personnalité sur une échelle arbitraire),

- les résultats de plusieurs études sont combinés,

- certaines ou toutes les études utilisent des échelles différentes, ou

- on souhaite exprimer l'ampleur d'un effet par rapport à la variabilité de la population.

Dans les méta-analyses, les tailles d'effet standardisées sont utilisées comme mesure commune qui peut être calculée pour différentes études, puis combinées dans un résumé global.

Interprétation

Le fait qu'une taille d'effet doive être interprétée comme petite, moyenne ou grande dépend de son contexte substantiel et de sa définition opérationnelle. Les critères conventionnels de Cohen petit , moyen ou grand sont presque omniprésents dans de nombreux domaines, bien que Cohen ait mis en garde :

"Les termes "petit", "moyen" et "grand" sont relatifs, non seulement l'un à l'autre, mais au domaine des sciences du comportement ou même plus particulièrement au contenu et à la méthode de recherche spécifiques utilisés dans une enquête donnée. ..Face à cette relativité, il existe un certain risque inhérent à proposer des définitions opérationnelles conventionnelles de ces termes pour une utilisation en analyse de pouvoir dans un domaine d'investigation aussi diversifié que les sciences du comportement. Ce risque est néanmoins accepté dans la conviction que plus est à gagner qu'à perdre en fournissant un cadre de référence conventionnel commun dont l'utilisation est recommandée uniquement lorsqu'aucune meilleure base pour estimer l'indice ES n'est disponible. » (p. 25)

Dans la mise en page des deux échantillons, Sawilowsky a conclu « sur la base des résultats de recherche actuels dans la littérature appliquée, il semble approprié de réviser les règles empiriques pour les tailles d'effet », en gardant à l'esprit les mises en garde de Cohen, et a élargi les descriptions pour inclure très petit , très grand , et énorme . Les mêmes normes de facto pourraient être développées pour d'autres configurations.

Lenth a noté pour une taille d'effet "moyenne", "vous choisirez le même n indépendamment de la précision ou de la fiabilité de votre instrument, ou de l'étroitesse ou de la diversité de vos sujets. De toute évidence, des considérations importantes sont ignorées ici. Les chercheurs doivent interpréter le l'importance substantielle de leurs résultats en les ancrant dans un contexte significatif ou en quantifiant leur contribution à la connaissance, et les descriptions de la taille de l'effet de Cohen peuvent être utiles comme point de départ. De même, un rapport parrainé par le ministère américain de l'Éducation a déclaré que « l'utilisation généralisée et sans discernement des valeurs génériques de taille d'effet petite, moyenne et grande de Cohen pour caractériser les tailles d'effet dans les domaines auxquels ses valeurs normatives ne s'appliquent pas est donc également inappropriée et trompeuse ».

Ils ont suggéré que "les normes appropriées sont celles basées sur les distributions de tailles d'effet pour des mesures de résultats comparables à partir d'interventions comparables ciblées sur des échantillons comparables". Ainsi, si une étude dans un domaine où la plupart des interventions sont minuscules produisait un petit effet (selon les critères de Cohen), ces nouveaux critères l'appelleraient "grand". Dans un point connexe, voir le paradoxe d'Abelson et le paradoxe de Sawilowsky.

Les types

Environ 50 à 100 mesures différentes de la taille de l'effet sont connues. De nombreuses tailles d'effet de différents types peuvent être converties en d'autres types, car beaucoup estiment la séparation de deux distributions et sont donc mathématiquement liées. Par exemple, un coefficient de corrélation peut être converti en un d de Cohen et vice versa.

Famille de corrélation : tailles d'effet basées sur la « variance expliquée »

Ces tailles d'effet estiment la quantité de variance au sein d'une expérience qui est « expliquée » ou « prise en compte » par le modèle de l'expérience ( Variation expliquée ).

Pearson r ou coefficient de corrélation

La corrélation de Pearson , souvent notée r et introduite par Karl Pearson , est largement utilisée comme taille d'effet lorsque des données quantitatives appariées sont disponibles ; par exemple si l'on étudiait la relation entre le poids à la naissance et la longévité. Le coefficient de corrélation peut également être utilisé lorsque les données sont binaires. Le r de Pearson peut varier en amplitude de -1 à 1, avec -1 indiquant une relation linéaire négative parfaite, 1 indiquant une relation linéaire positive parfaite et 0 indiquant aucune relation linéaire entre deux variables. Cohen donne les lignes directrices suivantes pour les sciences sociales :

| Taille de l'effet | r |

|---|---|

| Petit | 0,10 |

| Moyen | 0,30 |

| Grand | 0,50 |

Coefficient de détermination ( r 2 ou R 2 )

Une taille d'effet connexe est r 2 , le coefficient de détermination (également appelé R 2 ou « r au carré »), calculé comme le carré de la corrélation de Pearson r . Dans le cas de données appariées, il s'agit d'une mesure de la proportion de variance partagée par les deux variables, et varie de 0 à 1. Par exemple, avec un r de 0,21 le coefficient de détermination est de 0,0441, ce qui signifie que 4,4 % de la la variance de l'une des variables est partagée avec l'autre variable. Le r 2 est toujours positif et ne donne donc pas le sens de la corrélation entre les deux variables.

Eta-carré ( η 2 )

Eta-carré décrit le rapport de variance expliqué dans la variable dépendante par un prédicteur tout en contrôlant les autres prédicteurs, ce qui le rend analogue au r 2 . Eta-carré est un estimateur biaisé de la variance expliquée par le modèle dans la population (il estime uniquement la taille de l'effet dans l'échantillon). Cette estimation partage la faiblesse avec r 2 que chaque variable supplémentaire augmentera automatiquement la valeur de 2 . De plus, il mesure la variance expliquée de l'échantillon, et non de la population, ce qui signifie qu'il surestimera toujours la taille de l'effet, bien que le biais diminue à mesure que l'échantillon s'agrandit.

Oméga au carré (ω 2 )

Un estimateur moins biaisé de la variance expliquée dans la population est ω 2

Cette forme de formule est limitée à l'analyse inter-sujets avec des tailles d'échantillon égales dans toutes les cellules. Comme il est moins biaisé (mais pas sans biais), ω 2 est préférable à η 2 ; cependant, il peut être plus gênant de calculer pour des analyses complexes. Une forme généralisée de l'estimateur a été publiée pour les analyses inter-sujets et intra-sujets, les mesures répétées, les plans mixtes et les plans d'expérience en blocs aléatoires. De plus, des méthodes de calcul du ω 2 partiel pour les facteurs individuels et les facteurs combinés dans des plans comportant jusqu'à trois variables indépendantes ont été publiées.

Cohen ƒ 2

Cohen de ƒ 2 est l' une des mesures de la taille de l' effet à utiliser dans le cadre d'un test F pour ANOVA ou régression multiple . Sa quantité de polarisation (surestimation de la taille de l' effet de l'ANOVA) dépend de la polarisation de sa mesure sous - jacente de la variance expliquée (par exemple, R 2 , r 2 , ω 2 ).

La mesure de la taille de l'effet ƒ 2 pour la régression multiple est définie comme :

- où R 2 est la corrélation multiple au carré .

De même, ƒ 2 peut être défini comme :

- ou

- pour les modèles décrits par ces mesures de taille d'effet.

La mesure de la taille de l'effet pour la régression multiple séquentielle et également courante pour la modélisation PLS est définie comme suit :

- où R 2 A est la variance représentée par un ensemble d'une ou plusieurs variables indépendantes A , et R 2 AB est la variance combinée représentée par A et un autre ensemble d'une ou plusieurs variables indépendantes d'intérêt B . Par convention, ƒ 2 tailles d'effet de , et sont appelées petites , moyennes et grandes , respectivement.

L' analyse de Cohen peut également être trouvée pour l'analyse factorielle de la variance (ANOVA) en travaillant à rebours, en utilisant :

Dans une conception équilibrée (taille d'échantillon équivalente à travers les groupes) d'ANOVA, le paramètre de population correspondant de est

dans lequel μ j représente la moyenne de la population dans la j ème groupe de la totalité des K groupes, et σ la population équivalente écarts - types au sein de chacun des groupes. SS est la somme des carrés dans l'ANOVA.

q de Cohen

Une autre mesure utilisée avec les différences de corrélation est le q de Cohen. Il s'agit de la différence entre deux coefficients de régression de Pearson transformés par Fisher. Dans les symboles c'est

où r 1 et r 2 sont les régressions comparées. La valeur attendue de q est zéro et sa variance est

où N 1 et N 2 sont respectivement le nombre de points de données dans la première et la deuxième régression.

Famille de différence : tailles d'effet basées sur les différences entre les moyennes

La taille de l'effet brut se rapportant à une comparaison de deux groupes est intrinsèquement calculée comme étant les différences entre les deux moyennes. Cependant, pour faciliter l'interprétation, il est courant de standardiser la taille de l'effet ; diverses conventions de normalisation statistique sont présentées ci-dessous.

Différence moyenne standardisée

Un effet de taille (population) θ basée sur des moyens considère habituellement la différence moyenne normalisée entre les deux populations

où μ 1 est la moyenne pour une population, u 2 est la moyenne de l'autre population, et σ est un écart - type sur la base de l' un ou les deux populations.

Dans la pratique, les valeurs de population ne sont généralement pas connues et doivent être estimées à partir de statistiques d'échantillon. Les différentes versions des tailles d'effet basées sur les moyennes diffèrent quant aux statistiques utilisées.

Cette forme pour la taille de l'effet ressemble au calcul d'une statistique de test t , avec la différence critique que la statistique de test t inclut un facteur de . Cela signifie que pour une taille d'effet donnée, le niveau de signification augmente avec la taille de l'échantillon. Contrairement à la statistique du test t , la taille de l'effet vise à estimer un paramètre de population et n'est pas affectée par la taille de l'échantillon.

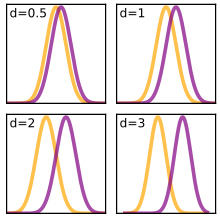

d de Cohen

Le d de Cohen est défini comme la différence entre deux moyennes divisée par un écart type des données, c'est-à - dire

Jacob Cohen a défini s , l' écart type regroupé , comme (pour deux échantillons indépendants) :

où la variance pour l'un des groupes est définie comme

et de même pour l'autre groupe.

Le tableau ci-dessous contient des descripteurs pour les magnitudes de d = 0,01 à 2,0, comme suggéré initialement par Cohen et développé par Sawilowsky.

| Taille de l'effet | ré | Référence |

|---|---|---|

| Très petit | 0,01 | |

| Petit | 0,20 | |

| Moyen | 0,50 | |

| Grand | 0,80 | |

| Très grand | 1,20 | |

| Énorme | 2.0 |

D'autres auteurs choisissent un calcul légèrement différent de l'écart type lorsqu'ils se réfèrent au « d de Cohen » où le dénominateur est sans « -2 »

Cette définition du « d de Cohen » est appelée estimateur du maximum de vraisemblance par Hedges et Olkin, et elle est liée au g de Hedges par un facteur d'échelle (voir ci-dessous).

Avec deux échantillons appariés, nous examinons la distribution des scores de différence. Dans ce cas, s est l'écart type de cette distribution des scores de différence. Cela crée la relation suivante entre la statistique t pour tester une différence dans les moyennes des deux groupes et le d de Cohen :

et

Le d de Cohen est fréquemment utilisé pour estimer la taille des échantillons à des fins de tests statistiques. Un d de Cohen inférieur indique la nécessité d'échantillons plus grands, et vice versa, comme cela peut être déterminé par la suite avec les paramètres supplémentaires du niveau de signification et de la puissance statistique souhaités .

Pour les échantillons appariés, Cohen suggère que le d calculé est en fait un d', ce qui ne fournit pas la réponse correcte pour obtenir la puissance du test, et qu'avant de rechercher les valeurs dans les tableaux fournis, il doit être corrigé pour r comme dans la formule suivante :

Verre'

En 1976, Gene V. Glass a proposé un estimateur de la taille de l'effet qui utilise uniquement l'écart type du deuxième groupe

Le deuxième groupe peut être considéré comme un groupe de contrôle, et Glass a fait valoir que si plusieurs traitements étaient comparés au groupe de contrôle, il serait préférable d'utiliser uniquement l'écart type calculé à partir du groupe de contrôle, afin que les tailles d'effet ne diffèrent pas sous des moyennes égales. et différentes variantes.

Dans le cadre d' une hypothèse correcte de population égale variances une estimation globale pour σ est plus précise.

Les haies g

Hedges' g , suggéré par Larry Hedges en 1981, est comme les autres mesures basées sur une différence standardisée

où l'écart type regroupé est calculé comme suit :

Cependant, comme un estimateur de la taille de l' effet de la population thetav il est biaisé . Néanmoins, ce biais peut être approximativement corrigé par multiplication par un facteur

Hedges et Olkin se réfèrent à cet estimateur moins biaisé comme d , mais ce ne sont pas la même chose que de Cohen de d . La forme exacte du facteur de correction J() implique la fonction gamma

Ψ, effet standardisé de la moyenne quadratique

Un estimateur similaire de la taille de l'effet pour les comparaisons multiples (p. ex. ANOVA ) est l'effet standardisé de la moyenne quadratique Ψ. Cela présente essentiellement la différence omnibus de l'ensemble du modèle ajusté par la moyenne quadratique, analogue à d ou g . La formule la plus simple pour Ψ, adaptée à l'ANOVA à un facteur, est

De plus, une généralisation pour les plans multifactoriels a été fournie.

Distribution des tailles d'effet en fonction des moyennes

À condition que les données soient distribuées gaussiennes, une échelle de Hedges g , , suit une distribution t non centrale avec le paramètre de non- centralité et ( n 1 + n 2 − 2) degrés de liberté. De même, le Glass' mis à l'échelle est distribué avec n 2 − 1 degrés de liberté.

A partir de la distribution, il est possible de calculer l' espérance et la variance des tailles d'effet.

Dans certains cas, des approximations pour de grands échantillons de la variance sont utilisées. Une suggestion pour la variance de l'estimateur sans biais de Hedges est

Autres métriques

La distance de Mahalanobis (D) est une généralisation multivariée du d de Cohen, qui prend en compte les relations entre les variables.

Famille catégorielle : tailles d'effet pour les associations entre les variables catégorielles

|

|

|

| Phi ( φ ) | Cramer V ( φ c ) |

|---|

Les mesures d'association couramment utilisées pour le test du chi carré sont le coefficient Phi et le V de Cramér (parfois appelé phi de Cramér et noté φ c ). Phi est lié au coefficient de corrélation point-bisérial et au d de Cohen et estime l'étendue de la relation entre deux variables (2 × 2). Le V de Cramér peut être utilisé avec des variables ayant plus de deux niveaux.

Phi peut être calculé en trouvant la racine carrée de la statistique du chi carré divisée par la taille de l'échantillon.

De même, le V de Cramér est calculé en prenant la racine carrée de la statistique du chi carré divisée par la taille de l'échantillon et la longueur de la dimension minimale ( k est le plus petit du nombre de lignes r ou de colonnes c ).

φ c est l'intercorrélation des deux variables discrètes et peut être calculé pour toute valeur de r ou c . Cependant, comme les valeurs du chi carré ont tendance à augmenter avec le nombre de cellules, plus la différence entre r et c est grande , plus V tendra probablement à 1 sans preuve solide d'une corrélation significative.

Le V de Cramér peut également être appliqué aux modèles chi-carré de « qualité d'ajustement » (c'est-à-dire ceux où c = 1). Dans ce cas, il fonctionne comme une mesure de la tendance vers un résultat unique (c'est-à-dire sur k résultats). Dans un tel cas, il faut utiliser r pour k , afin de préserver la plage 0 à 1 de V . Sinon, l'utilisation de c réduirait l'équation à celle de Phi.

le w de Cohen

Une autre mesure de la taille de l'effet utilisée pour les tests du chi carré est le w de Cohen . Ceci est défini comme

où p 0 i est la valeur de la i ème cellule sous H 0 , p 1 i est la valeur de la i ème cellule sous H 1 et m est le nombre de cellules.

| Taille de l'effet | w |

|---|---|

| Petit | 0,10 |

| Moyen | 0,30 |

| Grand | 0,50 |

Rapport de cotes

Le rapport de cotes (OR) est une autre taille d'effet utile. Elle est appropriée lorsque la question de recherche porte sur le degré d'association entre deux variables binaires. Par exemple, considérons une étude de la capacité d'orthographe. Dans un groupe témoin, deux élèves réussissent le cours pour chaque échec, donc les chances de réussite sont de deux à un (ou 2/1 = 2). Dans le groupe de traitement, six étudiants réussissent pour chaque échec, donc les chances de réussite sont de six à un (ou 6/1 = 6). La taille de l'effet peut être calculée en notant que les chances de réussite dans le groupe de traitement sont trois fois plus élevées que dans le groupe témoin (car 6 divisé par 2 fait 3). Par conséquent, le rapport de cotes est de 3. Les statistiques du rapport de cotes sont sur une échelle différente de celle du d de Cohen , donc ce « 3 » n'est pas comparable à un d de Cohen de 3.

Risque relatif

Le risque relatif (RR), également appelé risque relatif, est simplement le risque (probabilité) d'un événement par rapport à une variable indépendante. Cette mesure de la taille de l'effet diffère du rapport des cotes en ce qu'elle compare les probabilités au lieu des cotes , mais s'approche asymptotiquement de cette dernière pour les petites probabilités. En utilisant l'exemple ci-dessus, les probabilités pour les personnes du groupe témoin et du groupe de traitement de réussir sont de 2/3 (ou 0,67) et 6/7 (ou 0,86), respectivement. La taille de l'effet peut être calculée de la même manière que ci-dessus, mais en utilisant les probabilités à la place. Par conséquent, le risque relatif est de 1,28. Étant donné que des probabilités de réussite assez élevées ont été utilisées, il existe une grande différence entre le risque relatif et le rapport de cotes. Si l' échec (une probabilité plus faible) avait été utilisé comme événement (plutôt que la réussite ), la différence entre les deux mesures de la taille de l'effet n'aurait pas été si grande.

Bien que les deux mesures soient utiles, elles ont des utilisations statistiques différentes. Dans la recherche médicale, le rapport de cotes est couramment utilisé pour les études cas-témoins , car les cotes, mais pas les probabilités, sont généralement estimées. Le risque relatif est couramment utilisé dans les essais contrôlés randomisés et les études de cohorte , mais le risque relatif contribue à surestimer l'efficacité des interventions.

Différence de risque

La différence de risque (DR), parfois appelée réduction du risque absolu, est simplement la différence de risque (probabilité) d'un événement entre deux groupes. C'est une mesure utile dans la recherche expérimentale, car la RD vous indique dans quelle mesure une intervention expérimentale modifie la probabilité d'un événement ou d'un résultat. En utilisant l'exemple ci-dessus, les probabilités de réussite des membres du groupe témoin et du groupe de traitement sont respectivement de 2/3 (ou 0,67) et 6/7 (ou 0,86), et donc la taille de l'effet DR est de 0,86 - 0,67 = 0,19 (ou 19%). Le DR est la mesure supérieure pour évaluer l'efficacité des interventions.

h de Cohen

Une mesure utilisée dans l'analyse de puissance lors de la comparaison de deux proportions indépendantes est le h de Cohen . Ceci est défini comme suit

où p 1 et p 2 sont les proportions des deux échantillons comparés et arcsin est la transformation arcsinus.

Taille de l'effet du langage commun

Pour décrire plus facilement la signification d'une taille d'effet aux personnes extérieures aux statistiques, la taille d'effet en langage courant, comme son nom l'indique, a été conçue pour la communiquer en anglais simple. Il est utilisé pour décrire une différence entre deux groupes et a été proposé, ainsi que nommé, par Kenneth McGraw et SP Wong en 1992. Ils ont utilisé l'exemple suivant (à propos de la taille des hommes et des femmes) : "dans tout appariement aléatoire de jeunes adultes hommes et femmes, la probabilité que l'homme soit plus grand que la femme est de 0,92, ou en termes plus simples encore, dans 92 rendez-vous à l'aveugle sur 100 chez les jeunes adultes, l'homme sera plus grand que la femme", lors de la description de la valeur de la population de la taille de l'effet du langage commun.

La valeur de la population, pour la taille de l'effet de langue commune, est souvent rapportée comme ceci, en termes de paires choisies au hasard dans la population. Kerby (2014) note qu'une paire , définie comme un score dans un groupe jumelé à un score dans un autre groupe, est un concept central de la taille de l'effet de langage commun.

Comme autre exemple, considérons une étude scientifique (peut-être sur un traitement pour certaines maladies chroniques, comme l'arthrite) avec dix personnes dans le groupe de traitement et dix personnes dans un groupe témoin. Si tout le monde dans le groupe de traitement est comparé à tout le monde dans le groupe témoin, alors il y a (10×10=) 100 paires. A la fin de l'étude, le résultat est noté en un score, pour chaque individu (par exemple sur une échelle de mobilité et de douleur, dans le cas d'une étude sur l'arthrite), puis tous les scores sont comparés entre les paires. Le résultat, en pourcentage de paires qui appuient l'hypothèse, est la taille de l'effet du langage commun. Dans l'exemple d'étude, cela pourrait être (disons) 0,80, si 80 des 100 paires de comparaison montrent un meilleur résultat pour le groupe de traitement que le groupe de contrôle, et le rapport peut se lire comme suit : « Quand un patient dans le groupe de traitement groupe a été comparé à un patient du groupe témoin, dans 80 des 100 paires, le patient traité a montré un meilleur résultat de traitement." La valeur de l'échantillon, par exemple dans une étude comme celle-ci, est un estimateur sans biais de la valeur de la population.

Vargha et Delaney ont généralisé la taille de l'effet de langage commun (Vargha-Delaney A ), pour couvrir les données de niveau ordinal.

Corrélation rang-bisérie

Une taille d'effet liée à la taille d'effet de la langue commune est la corrélation rang-bisérie. Cette mesure a été introduite par Cureton comme taille d'effet pour le test U de Mann-Whitney . C'est-à-dire qu'il y a deux groupes et que les scores des groupes ont été convertis en rangs. La formule de différence simple de Kerby calcule la corrélation rang-bisérie à partir de la taille de l'effet de langue commune. Soit f la proportion de paires favorables à l'hypothèse (la taille de l'effet de langue commune), et soit u la proportion de paires non favorables, le rang bisérial r est la simple différence entre les deux proportions : r = f − u . En d'autres termes, la corrélation est la différence entre la taille de l'effet de langue commune et son complément. Par exemple, si la taille de l'effet du langage commun est de 60 %, le rang bisérial r est égal à 60 % moins 40 %, ou r = 0,20. La formule Kerby est directionnelle, avec des valeurs positives indiquant que les résultats soutiennent l'hypothèse.

Une formule non directionnelle pour la corrélation rang-bisérie a été fournie par Wendt, de sorte que la corrélation est toujours positive. L'avantage de la formule de Wendt est qu'elle peut être calculée avec des informations facilement disponibles dans les articles publiés. La formule utilise uniquement la valeur de test de U du test U de Mann-Whitney et les tailles d'échantillon des deux groupes : r = 1 – (2 U )/( n 1 n 2 ). Notez que U est défini ici selon la définition classique comme la plus petite des deux valeurs U qui peuvent être calculées à partir des données. Cela garantit que 2 U < n 1 n 2 , car n 1 n 2 est la valeur maximale de la statistique U .

Un exemple peut illustrer l'utilisation des deux formules. Considérons une étude sur la santé de vingt personnes âgées, dont dix dans le groupe de traitement et dix dans le groupe témoin ; par conséquent, il y a dix fois dix ou 100 paires. Le programme de santé utilise l'alimentation, l'exercice et des suppléments pour améliorer la mémoire, et la mémoire est mesurée par un test standardisé. Un test de Mann-Whitney U montre que l'adulte du groupe de traitement avait la meilleure mémoire dans 70 des 100 paires et la moins bonne mémoire dans 30 paires. Le Mann-Whitney U est le plus petit de 70 et 30, donc U = 30. La corrélation entre la mémoire et les performances de traitement par la formule de différence simple Kerby est r = (70/100) − (30/100) = 0,40. La corrélation par la formule de Wendt est r = 1 − (2,30)/(10,10) = 0,40.

Taille de l'effet pour les données ordinales

Le delta de Cliff ou , développé à l'origine par Norman Cliff pour être utilisé avec des données ordinales, est une mesure de la fréquence à laquelle les valeurs d'une distribution sont supérieures aux valeurs d'une seconde distribution. Surtout, il ne nécessite aucune hypothèse sur la forme ou la propagation des deux distributions.

L'estimation de l'échantillon est donnée par :

où les deux distributions sont de taille et avec des éléments et , respectivement, et est le crochet d'Iverson , qui est 1 lorsque le contenu est vrai et 0 lorsqu'il est faux.

est linéairement lié à la statistique U de Mann-Whitney ; cependant, il capture la direction de la différence dans son signe. Étant donné le Mann-Whitney , est :

Intervalles de confiance au moyen de paramètres de non-centralité

Les intervalles de confiance des tailles d'effet standardisées, en particulier celles de Cohen et , reposent sur le calcul des intervalles de confiance des paramètres de non - centralité ( ncp ). Une approche courante pour construire l'intervalle de confiance de ncp consiste à trouver les valeurs critiques de ncp pour ajuster la statistique observée aux quantiles de queue α /2 et (1 − α /2). Le SAS et le R-package MBESS fournissent des fonctions pour trouver les valeurs critiques de ncp .

Pour un seul groupe, M représente la moyenne de l' échantillon, μ la moyenne de la population, SD écart - type de l'échantillon, σ l' écart - type de la population, et n est la taille de l' échantillon du groupe. La valeur t est utilisée pour tester l'hypothèse sur la différence entre la moyenne et une ligne de base μ ligne de base . Habituellement, la ligne de base μ est nulle. Dans le cas de deux groupes liés, le groupe unique est constitué par les différences de paires d'échantillons, tandis que SD et σ représentent les écarts - types de l'échantillon et de la population de différences plutôt que dans les deux groupes d' origine.

et Cohen

est l'estimation ponctuelle de

Donc,

Test t pour la différence moyenne entre deux groupes indépendants

n 1 ou n 2 sont les tailles d'échantillon respectives.

où

et Cohen

- est l'estimation ponctuelle de

Donc,

Test ANOVA à un facteur pour la différence moyenne entre plusieurs groupes indépendants

Le test ANOVA unidirectionnel applique une distribution F non centrale . Alors qu'avec un écart-type de population donné , la même question de test applique une distribution chi-carré non centrale .

Pour chaque j -ième échantillon au sein du i -ième groupe X i , j , désignent

Tandis que,

Donc, à la fois ncp ( s ) de F et égal

En cas de pour K groupes indépendants de même taille, la taille totale de l' échantillon est N : = n · K .

Le test t pour une paire de groupes indépendants est un cas particulier d'ANOVA à un facteur. Notez que le paramètre de non-centralité de F n'est pas comparable au paramètre de non-centralité du t correspondant . En fait, , et .

Voir également

- Statistiques d'estimation

- Signification statistique

- Facteur Z , une mesure alternative de la taille de l'effet

Les références

Lectures complémentaires

- Aaron, B., Kromrey, JD, & Ferron, JM (1998, novembre). Équation des indices de taille d'effet basés sur r et basés sur d : problèmes avec une formule couramment recommandée. Document présenté à la réunion annuelle de la Florida Educational Research Association, Orlando, FL. (Service de reproduction de documents ERIC n° ED433353)

- Bonett, DG (2008). « Intervalles de confiance pour les contrastes linéaires standardisés de moyennes ». Méthodes psychologiques . 13 (2) : 99-109. doi : 10.1037/1082-989x.13.2.99 . PMID 18557680 .

- Bonett, DG (2009). « Estimation des contrastes linéaires standardisés des moyennes avec la précision souhaitée ». Méthodes psychologiques . 14 (1) : 1-5. doi : 10.1037/a0014270 . PMID 19271844 .

- Brooks, moi; Dalal, DK ; Nolan, KP (2013). « Les tailles d'effet de langage courant sont-elles plus faciles à comprendre que les tailles d'effet traditionnelles ? » Journal de psychologie appliquée . 99 (2) : 332-340. doi : 10.1037/a0034745 . PMID 24188393 .

- Cumming, G.; Finch, S. (2001). « Abécédaire sur la compréhension, l'utilisation et le calcul des intervalles de confiance basés sur des distributions centrales et non centrales ». Mesure éducative et psychologique . 61 (4) : 530-572. doi : 10.1177/0013164401614002 . S2CID 120672914 .

- Kelley, K (2007). « Intervalles de confiance pour les tailles d'effet standardisées : théorie, application et mise en œuvre » . Journal des logiciels statistiques . 20 (8) : 1-24. doi : 10.18637/jss.v020.i08 .

- Lipsey, MW et Wilson, DB (2001). Méta-analyse pratique . Sauge : Thousand Oaks, Californie.

Liens externes

Plus d'explications

![{\displaystyle d={\frac {\sum _{i,j}[x_{i}>x_{j}]-[x_{i}<x_{j}]}{mn}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d161ce320bc658346872de788497eced043c8f2c)

![{\style d'affichage [\cdot ]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/41b4e841c71afe1890198191aab15bc225bbc0b6)