Philosophie de l'intelligence artificielle - Philosophy of artificial intelligence

| Fait partie d'une série sur |

| Intelligence artificielle |

|---|

La philosophie de l'intelligence artificielle est une branche de la philosophie de la technologie qui explore l' intelligence artificielle et ses implications pour la connaissance et la compréhension de l' intelligence , de l' éthique , de la conscience , de l' épistémologie et du libre arbitre . De plus, la technologie concerne la création d'animaux artificiels ou de personnes artificielles (ou, du moins, de créatures artificielles ; voir la vie artificielle ) de sorte que la discipline présente un intérêt considérable pour les philosophes. Ces facteurs ont contribué à l'émergence de la philosophie de l'intelligence artificielle . Certains chercheurs soutiennent que le rejet de la philosophie par la communauté de l'IA est préjudiciable.

La philosophie de l'intelligence artificielle tente de répondre à ces questions comme suit :

- Une machine peut-elle agir intelligemment ? Peut-il résoudre n'importe quel problème qu'une personne résoudrait en pensant ?

- L'intelligence humaine et l'intelligence artificielle sont-elles identiques ? Le cerveau humain est-il essentiellement un ordinateur ?

- Une machine peut-elle avoir un esprit , des états mentaux et une conscience dans le même sens qu'un être humain ? Peut-il sentir comment sont les choses ?

Des questions comme celles-ci reflètent les intérêts divergents des chercheurs en IA , des scientifiques cognitifs et des philosophes respectivement. Les réponses scientifiques à ces questions dépendent de la définition de « l'intelligence » et de la « conscience » et des « machines » exactement en discussion.

Les propositions importantes de la philosophie de l'IA comprennent certaines des suivantes :

- La « convention polie » de Turing : si une machine se comporte aussi intelligemment qu'un être humain, alors elle est aussi intelligente qu'un être humain.

- La proposition de Dartmouth : "Chaque aspect de l'apprentissage ou toute autre caractéristique de l'intelligence peut être décrit avec une telle précision qu'une machine peut être conçue pour le simuler."

- Allen Newell et Herbert A. Simon de système de symbole physique hypothèse: « Un système de symbole physique dispose des moyens nécessaires et suffisants d'action intelligente générale. »

- La forte hypothèse de l'IA de John Searle : "L'ordinateur correctement programmé avec les bonnes entrées et sorties aurait ainsi un esprit exactement dans le même sens que les êtres humains ont un esprit."

- Le mécanisme de Hobbes : "Car la 'raison'... n'est rien d'autre que 'compter', c'est-à-dire additionner et soustraire, les conséquences des noms généraux convenus pour le 'marquage' et la 'signification' de nos pensées..."

Une machine peut-elle faire preuve d'intelligence générale ?

Est-il possible de créer une machine capable de résoudre tous les problèmes que les humains résolvent en utilisant leur intelligence ? Cette question définit la portée de ce que les machines pourraient faire à l'avenir et guide la direction de la recherche en IA. Il ne concerne que le comportement des machines et ignore les questions d'intérêt pour les psychologues , les cognitivistes et les philosophes ; Pour répondre à cette question, peu importe qu'une machine pense vraiment (comme une personne pense) ou qu'elle agisse simplement comme si elle pensait.

La position de base de la plupart des chercheurs en IA est résumée dans cette déclaration, qui est apparue dans la proposition pour l' atelier de Dartmouth de 1956 :

- "Chaque aspect de l'apprentissage ou toute autre caractéristique de l'intelligence peut être décrit avec une telle précision qu'une machine peut être conçue pour le simuler."

Les arguments contre la prémisse de base doivent montrer que la construction d'un système d'IA fonctionnel est impossible parce qu'il existe une limite pratique aux capacités des ordinateurs ou qu'il existe une qualité particulière de l'esprit humain qui est nécessaire pour un comportement intelligent et pourtant ne peut pas être reproduite par un machine (ou par les méthodes de la recherche actuelle en IA). Les arguments en faveur de la prémisse de base doivent montrer qu'un tel système est possible.

Il est également possible de contourner le lien entre les deux parties de la proposition ci-dessus. Par exemple, l'apprentissage automatique, à commencer par la tristement célèbre proposition de machine enfant de Turing, atteint essentiellement la caractéristique souhaitée de l'intelligence sans une description précise au moment de la conception de la façon dont cela fonctionnerait exactement. Le compte sur la connaissance tacite du robot élimine le besoin d'une description précise tous ensemble.

La première étape pour répondre à la question est de définir clairement « l'intelligence ».

Intelligence

essai de Turing

Alan Turing a réduit le problème de la définition de l'intelligence à une simple question sur la conversation. Il suggère que : si une machine peut répondre à n'importe quelle question qui lui est posée, en utilisant les mêmes mots qu'une personne ordinaire, alors nous pouvons appeler cette machine intelligente. Une version moderne de sa conception expérimentale utiliserait une salle de discussion en ligne , où l'un des participants est une personne réelle et l'un des participants est un programme informatique. Le programme réussit le test si personne ne peut dire lequel des deux participants est humain. Turing note que personne (à l'exception des philosophes) ne pose jamais la question « les gens peuvent-ils penser ? » Il écrit "au lieu de discuter continuellement sur ce point, il est habituel d'avoir une convention polie que tout le monde pense". Le test de Turing étend cette convention polie aux machines :

- Si une machine agit aussi intelligemment qu'un être humain, alors elle est aussi intelligente qu'un être humain.

Une critique du test de Turing est qu'il ne mesure que "l'humanité" du comportement de la machine, plutôt que "l'intelligence" du comportement. Étant donné que le comportement humain et le comportement intelligent ne sont pas exactement la même chose, le test ne parvient pas à mesurer l'intelligence. Stuart J. Russell et Peter Norvig écrivent que "les textes d'ingénierie aéronautique ne définissent pas le but de leur domaine comme 'fabriquant des machines qui volent si exactement comme des pigeons qu'elles peuvent tromper d'autres pigeons'".

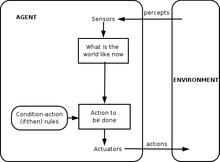

Définition d'agent intelligent

La recherche sur l'IA du XXIe siècle définit l'intelligence en termes d' agents intelligents . Un "agent" est quelque chose qui perçoit et agit dans un environnement. Une « mesure de performance » définit ce qui compte comme succès pour l'agent.

- "Si un agent agit de manière à maximiser la valeur attendue d'une mesure de performance basée sur l'expérience et les connaissances passées, alors il est intelligent."

Des définitions comme celle-ci tentent de saisir l'essence de l'intelligence. Ils ont l'avantage que, contrairement au test de Turing, ils ne testent pas également les traits humains non intelligents tels que les fautes de frappe ou la capacité d'être insulté. Ils ont l'inconvénient de ne pas pouvoir différencier les "choses qui pensent" des "choses qui ne pensent pas". Par cette définition, même un thermostat a une intelligence rudimentaire.

Arguments qu'une machine peut faire preuve d'intelligence générale

Le cerveau peut être simulé

Hubert Dreyfus décrit cet argument comme affirmant que « si le système nerveux obéit aux lois de la physique et de la chimie, ce que nous avons toutes les raisons de supposer qu'il le fait, alors .... nous ... devrions être capables de reproduire le comportement du système nerveux avec un certain dispositif physique » .Cette argument, d' abord introduit dès 1943 et vivement décrit par Hans Moravec en 1988, est maintenant associée à futurologue Ray Kurzweil , qui estime que la puissance de calcul sera suffisante pour une simulation du cerveau complète par l'année 2029. Une simulation en temps non réel d'un modèle thalamocortical ayant la taille du cerveau humain (10 11 neurones) a été réalisée en 2005 et il a fallu 50 jours pour simuler 1 seconde de dynamique cérébrale sur un cluster de 27 processeurs.

Même les critiques les plus sévères de l'IA (comme Hubert Dreyfus et John Searle ) s'accordent à dire qu'une simulation cérébrale est possible en théorie. Cependant, Searle souligne qu'en principe, tout peut être simulé par un ordinateur ; ainsi, amener la définition à son point de rupture conduit à la conclusion que tout processus peut techniquement être considéré comme un « calcul ». "Ce que nous voulions savoir, c'est ce qui distingue l'esprit des thermostats et des foies", écrit-il. Ainsi, simplement simuler le fonctionnement d'un cerveau vivant serait en soi un aveu d'ignorance concernant l'intelligence et la nature de l'esprit, comme essayer de construire un avion de ligne en copiant un oiseau vivant avec précision, plume par plume, sans aucune compréhension théorique de génie aéronautique .

La pensée humaine est un traitement de symboles

En 1963, Allen Newell et Herbert A. Simon ont proposé que la « manipulation de symboles » était l'essence de l'intelligence humaine et machine. Ils ont écrit:

- "Un système de symboles physiques a les moyens nécessaires et suffisants d'une action intelligente générale."

Cette affirmation est très forte : elle implique à la fois que la pensée humaine est une sorte de manipulation de symboles (car un système de symboles est nécessaire à l'intelligence) et que les machines peuvent être intelligentes (car un système de symboles est suffisant pour l'intelligence). Une autre version de cette position a été décrite par le philosophe Hubert Dreyfus, qui l'a appelée « l'hypothèse psychologique » :

- "L'esprit peut être considéré comme un appareil fonctionnant sur des bits d'information selon des règles formelles."

Les "symboles" dont Newell, Simon et Dreyfus ont discuté étaient semblables à des mots et de haut niveau - des symboles qui correspondent directement aux objets du monde, tels que <chien> et <queue>. La plupart des programmes d'IA écrits entre 1956 et 1990 utilisaient ce type de symbole. L'IA moderne, basée sur les statistiques et l'optimisation mathématique, n'utilise pas le "traitement des symboles" de haut niveau dont Newell et Simon ont parlé.

Arguments contre le traitement des symboles

Ces arguments montrent que la pensée humaine ne consiste pas (uniquement) en une manipulation de symboles de haut niveau. Ils ne montrent pas que l'intelligence artificielle est impossible, seulement qu'il faut plus que du traitement de symboles.

Arguments anti-mécaniciens de Gödel

En 1931, Kurt Gödel a prouvé avec un théorème d'incomplétude qu'il est toujours possible de construire une « déclaration de Gödel » qu'un système logique formel cohérent donné (comme un programme de manipulation de symboles de haut niveau) ne pourrait pas prouver. En dépit d'être une déclaration vraie, la déclaration de Gödel construite est impossible à prouver dans le système donné. (La vérité de la déclaration de Gödel construite dépend de la cohérence du système donné ; appliquer le même processus à un système subtilement incohérent semblera réussir, mais produira en fait une fausse « déclaration de Gödel ».) Plus spéculativement, Gödel a conjecturé que l'esprit humain peut éventuellement déterminer correctement la vérité ou la fausseté de tout énoncé mathématique bien fondé (y compris tout énoncé possible de Gödel), et que, par conséquent, le pouvoir de l'esprit humain n'est pas réductible à un mécanisme . Le philosophe John Lucas (depuis 1961) et Roger Penrose (depuis 1989) ont défendu cet argument philosophique anti-mécanicien.

Les arguments anti-mécaniciens de Gödel tendent à s'appuyer sur l'affirmation d'apparence anodine qu'un système de mathématiciens humains (ou une certaine idéalisation des mathématiciens humains) est à la fois cohérent (totalement exempt d'erreur) et croit pleinement en sa propre cohérence (et peut rendre tout logique inférences qui découlent de sa propre cohérence, y compris la croyance dans sa déclaration de Gödel). Ceci est manifestement impossible à faire pour une machine de Turing (voir Problème d'arrêt ); par conséquent, le Gödelien conclut que le raisonnement humain est trop puissant pour être capturé par une machine de Turing, et par extension, tout appareil mécanique numérique.

Cependant, le consensus moderne dans la communauté scientifique et mathématique est que le raisonnement humain réel est incohérent ; que toute « version idéalisée » cohérente de H du raisonnement humain serait logiquement forcée d'adopter un scepticisme d'esprit sain mais contre-intuitif quant à la cohérence de H (sinon H est manifestement incohérent) ; et que les théorèmes de Gödel ne conduisent à aucun argument valable selon lequel les humains ont des capacités de raisonnement mathématique au-delà de ce qu'une machine pourrait jamais reproduire. Ce consensus selon lequel les arguments anti-mécaniciens de Gödel sont voués à l'échec est énoncé avec force dans l'Intelligence Artificielle : « toute tentative d'utiliser (les résultats d'incomplétude de Gödel) pour attaquer la thèse computationnelle est forcément thèse."

Stuart Russell et Peter Norvig conviennent que l'argument de Gödel ne prend pas en compte la nature du raisonnement humain dans le monde réel. Elle s'applique à ce qui peut théoriquement être prouvé, étant donné une quantité infinie de mémoire et de temps. En pratique, les machines réelles (y compris les humains) ont des ressources finies et auront du mal à prouver de nombreux théorèmes. Il n'est pas nécessaire de pouvoir tout prouver pour être une personne intelligente.

De manière moins formelle, Douglas Hofstadter , dans son livre Gödel, Escher, Bach: An Eternal Golden Braid , lauréat du prix Pulitzer , déclare que ces « déclarations de Gödel » se réfèrent toujours au système lui-même, faisant une analogie avec la façon dont le paradoxe d'Épiménide utilise des déclarations qui se réfèrent à eux-mêmes, par exemple « cette déclaration est fausse » ou « je mens ». Mais, bien sûr, le paradoxe d'Épiménide s'applique à tout ce qui fait des déclarations, qu'il s'agisse de machines ou d' humains, même Lucas lui-même. Envisager:

- Lucas ne peut pas affirmer la vérité de cette déclaration.

Cette déclaration est vraie mais ne peut pas être affirmée par Lucas. Cela montre que Lucas lui-même est soumis aux mêmes limites qu'il décrit pour les machines, comme le sont toutes les personnes, et donc l'argument de Lucas est inutile.

Après avoir conclu que le raisonnement humain n'est pas calculable, Penrose a poursuivi en spéculant de manière controversée qu'une sorte de processus hypothétiques non calculables impliquant l'effondrement d' états de mécanique quantique donne aux humains un avantage particulier sur les ordinateurs existants. Les ordinateurs quantiques existants ne sont capables que de réduire la complexité des tâches calculables de Turing et sont toujours limités aux tâches dans le cadre des machines de Turing. physique, par exemple la gravité quantique qui pourrait manifester une nouvelle physique à l'échelle de la masse de Planck via l'effondrement quantique spontané de la fonction d'onde. Ces états, a-t-il suggéré, se produisent à la fois dans les neurones et s'étendent également sur plus d'un neurone. Cependant, d'autres scientifiques soulignent qu'il n'y a pas de mécanisme organique plausible dans le cerveau pour exploiter toute sorte de calcul quantique, et en outre que l'échelle de temps de la décohérence quantique semble trop rapide pour influencer le déclenchement des neurones.

Dreyfus : la primauté des compétences implicites

Hubert Dreyfus a soutenu que l'intelligence et l'expertise humaines dépendaient principalement de compétences implicites plutôt que d'une manipulation symbolique explicite, et a fait valoir que ces compétences ne seraient jamais capturées dans des règles formelles.

L'argument de Dreyfus avait été anticipé par Turing dans son article de 1950, Machines informatiques et intelligence , où il l'avait classé comme « l'argument de l'informalité du comportement ». Turing a répondu que, simplement parce que nous ne connaissons pas les règles qui régissent un comportement complexe, cela ne signifie pas qu'il n'existe pas de telles règles. Il écrivit : « nous ne pouvons pas nous convaincre si facilement de l'absence de lois complètes de comportement... La seule façon dont nous connaissons pour trouver de telles lois est l'observation scientifique, et nous ne connaissons certainement aucune circonstance dans laquelle nous pourrions dire : " Nous ont assez cherché. Il n'y a pas de telles lois.'"

Russell et Norvig soulignent que, dans les années qui ont suivi la publication de sa critique par Dreyfus, des progrès ont été accomplis vers la découverte des « règles » qui régissent le raisonnement inconscient. Le mouvement situé dans la recherche en robotique tente de capturer nos capacités inconscientes de perception et d'attention. Les paradigmes de l' intelligence informatique , tels que les réseaux neuronaux , les algorithmes évolutionnaires , etc., sont principalement orientés vers le raisonnement et l'apprentissage inconscients simulés. Les approches statistiques de l'IA peuvent faire des prédictions qui se rapprochent de la précision des suppositions intuitives humaines. La recherche sur les connaissances de sens commun s'est concentrée sur la reproduction de « l'arrière-plan » ou du contexte de la connaissance. En fait, la recherche sur l'IA en général s'est éloignée de la manipulation de symboles de haut niveau pour se tourner vers de nouveaux modèles destinés à capturer davantage notre raisonnement inconscient . L'historien et chercheur en IA Daniel Crevier a écrit que "le temps a prouvé l'exactitude et la perspicacité de certains des commentaires de Dreyfus. S'il les avait formulés de manière moins agressive, les actions constructives qu'ils suggéraient auraient pu être prises beaucoup plus tôt."

Une machine peut-elle avoir un esprit, une conscience et des états mentaux ?

C'est une question philosophique, liée au problème des autres esprits et au difficile problème de la conscience . La question tourne autour d'une position définie par John Searle comme « une IA forte » :

- Un système de symboles physiques peut avoir un esprit et des états mentaux.

Searle distinguait cette position de ce qu'il appelait « l'IA faible » :

- Un système de symboles physiques peut agir intelligemment.

Searle a introduit les termes pour isoler l'IA forte de l'IA faible afin qu'il puisse se concentrer sur ce qu'il pensait être le problème le plus intéressant et le plus discutable. Il a fait valoir que même si nous supposons que nous avons un programme informatique qui agit exactement comme un esprit humain, il y aurait toujours une question philosophique difficile à laquelle il fallait répondre.

Aucune des deux positions de Searle n'est très préoccupante pour la recherche en IA, car elles ne répondent pas directement à la question « une machine peut-elle afficher une intelligence générale ? » (à moins qu'on puisse aussi montrer que la conscience est nécessaire à l'intelligence). Turing a écrit : « Je ne souhaite pas donner l'impression que je pense qu'il n'y a pas de mystère sur la conscience… [mais] je ne pense pas que ces mystères doivent nécessairement être résolus avant que nous puissions répondre à la question [de savoir si les machines peuvent penser]. " Russell et Norvig sont d'accord : "La plupart des chercheurs en IA tiennent l'hypothèse de l'IA faible pour acquise et ne se soucient pas de l'hypothèse de l'IA forte."

Il y a quelques chercheurs qui croient que la conscience est un élément essentiel de l'intelligence, comme Igor Aleksander , Stan Franklin , Ron Sun et Pentti Haikonen , bien que leur définition de la "conscience" s'éloigne de très près de "l'intelligence". (Voir conscience artificielle .)

Avant de pouvoir répondre à cette question, nous devons être clairs sur ce que nous entendons par « esprits », « états mentaux » et « conscience ».

Conscience, esprits, états mentaux, sens

Les mots « esprit » et « conscience » sont utilisés par différentes communautés de différentes manières. Certains penseurs du nouvel âge , par exemple, utilisent le mot « conscience » pour décrire quelque chose de similaire à « l' élan vital » de Bergson : un fluide énergétique invisible qui imprègne la vie et surtout l'esprit. Les auteurs de science-fiction utilisent ce mot pour décrire une propriété essentielle qui fait de nous un être humain : une machine ou un extraterrestre « conscient » sera présenté comme un personnage pleinement humain, doté d'intelligence, de désirs, de volonté , de perspicacité, de fierté, etc. (Les auteurs de science-fiction utilisent également les mots "sentience", "sapience", "conscience de soi" ou " fantôme " - comme dans le manga et la série animée Ghost in the Shell - pour décrire cette propriété humaine essentielle). Pour d'autres, les mots « esprit » ou « conscience » sont utilisés comme une sorte de synonyme profane de l' âme .

Pour les philosophes , les neuroscientifiques et les chercheurs en sciences cognitives , les mots sont utilisés de manière à la fois plus précise et plus banale : ils renvoient à l'expérience familière et quotidienne d'avoir une "pensée dans la tête", comme une perception, un rêve, une intention ou un plan, et à la façon dont nous voyons quelque chose, savons quelque chose, voulons dire quelque chose ou comprenons quelque chose. « Il n'est pas difficile de donner une définition de bon sens de la conscience », observe le philosophe John Searle. Ce qui est mystérieux et fascinant n'est pas tant ce qu'il est mais comment c'est : comment une masse de tissu adipeux et d'électricité donne-t-elle naissance à cette expérience (familière) de perception, de sens ou de pensée ?

Les philosophes appellent cela le problème difficile de la conscience . C'est la dernière version d'un problème classique de la philosophie de l'esprit appelé « problème corps-esprit ». Un problème connexe est le problème du sens ou de la compréhension (que les philosophes appellent « intentionnalité ») : quel est le lien entre nos pensées et ce à quoi nous pensons (c'est-à-dire des objets et des situations dans le monde) ? Un troisième problème est le problème de l' expérience (ou « phénoménologie ») : si deux personnes voient la même chose, ont-elles la même expérience ? Ou y a-t-il des choses « à l'intérieur de leur tête » (appelées « qualia ») qui peuvent être différentes d'une personne à l'autre ?

Les neurobiologistes pensent que tous ces problèmes seront résolus lorsque nous commencerons à identifier les corrélats neuronaux de la conscience : la relation réelle entre la machinerie dans nos têtes et ses propriétés collectives ; tels que l'esprit, l'expérience et la compréhension. Certains des critiques les plus sévères de l' intelligence artificielle s'accordent à dire que le cerveau n'est qu'une machine et que la conscience et l'intelligence sont le résultat de processus physiques dans le cerveau. La question philosophique difficile est la suivante : un programme informatique, fonctionnant sur une machine numérique qui mélange les chiffres binaires de zéro et un, peut-il dupliquer la capacité des neurones à créer des esprits, avec des états mentaux (comme comprendre ou percevoir), et finalement, l'expérience de la conscience ?

Arguments selon lesquels un ordinateur ne peut pas avoir d'esprit et d'états mentaux

La chambre chinoise de Searle

John Searle nous demande de considérer une expérience de pensée : supposons que nous ayons écrit un programme informatique qui réussisse le test de Turing et démontre une action intelligente générale. Supposons, en particulier, que le programme puisse converser en chinois couramment. Écrivez le programme sur des cartes 3x5 et donnez-les à une personne ordinaire qui ne parle pas chinois. Enfermez la personne dans une pièce et demandez-lui de suivre les instructions sur les cartes. Il copiera les caractères chinois et les fera entrer et sortir de la pièce à travers une fente. De l'extérieur, il apparaîtra que la pièce chinoise contient une personne pleinement intelligente qui parle chinois. La question est la suivante : y a-t-il quelqu'un (ou quelque chose) dans la salle qui comprend le chinois ? C'est-à-dire, y a-t-il quelque chose qui a l'état mental de compréhension , ou qui a une conscience consciente de ce qui est discuté en chinois ? L'homme n'est clairement pas au courant. La salle ne peut pas être au courant. Les cartes ne sont certainement pas au courant. Searle conclut que la salle chinoise , ou tout autre système de symboles physiques, ne peut pas avoir d'esprit.

Searle poursuit en affirmant que les états mentaux et la conscience réels nécessitent (encore à être décrits) "les propriétés physico-chimiques réelles du cerveau humain réel". Il soutient qu'il existe des « propriétés causales » spéciales des cerveaux et des neurones qui donnent naissance aux esprits : selon ses mots, « les cerveaux provoquent les esprits ».

Arguments associés : moulin de Leibniz, central téléphonique de Davis, nation chinoise de Block et Blockhead

Gottfried Leibniz a présenté essentiellement le même argument que Searle en 1714, en utilisant l'expérience de pensée consistant à développer le cerveau jusqu'à ce qu'il ait la taille d'un moulin . En 1974, Lawrence Davis a imaginé dupliquer le cerveau en utilisant des lignes téléphoniques et des bureaux occupés par des personnes, et en 1978, Ned Block a imaginé l'ensemble de la population chinoise impliquée dans une telle simulation cérébrale. Cette expérience de pensée est appelée « la nation chinoise » ou « le gymnase chinois ». Ned Block a également proposé son argument Blockhead , qui est une version de la salle chinoise dans laquelle le programme a été remanié en un simple ensemble de règles de la forme "voir ceci, faire cela", supprimant tout mystère du programme.

Réponses à la salle chinoise

Les réponses à la salle chinoise mettent l'accent sur plusieurs points différents.

- La réponse des systèmes et la réponse de l'esprit virtuel : Cette réponse soutient que le système , y compris l'homme, le programme, la pièce et les cartes, est ce qui comprend le chinois. Searle prétend que l'homme dans la pièce est la seule chose qui pourrait éventuellement "avoir un esprit" ou "comprendre", mais d'autres ne sont pas d'accord, arguant qu'il est possible qu'il y ait deux esprits au même endroit physique, de la même manière un ordinateur peut simultanément « être » deux machines à la fois : une physique (comme un Macintosh ) et une « virtuelle » (comme un traitement de texte ).

- Rapidité, puissance et complexité des réponses : Plusieurs critiques soulignent que l'homme dans la pièce mettrait probablement des millions d'années à répondre à une simple question, et aurait besoin de « classeurs » de proportions astronomiques. Cela met en doute la clarté de l'intuition de Searle.

- Réponse du robot : Pour vraiment comprendre, certains pensent que la salle chinoise a besoin d'yeux et de mains. Hans Moravec écrit : « Si nous pouvions greffer un robot sur un programme de raisonnement, nous n'aurions plus besoin d'une personne pour en fournir le sens : cela viendrait du monde physique. »

- Réponse du simulateur de cerveau : Et si le programme simulait la séquence d'excitations nerveuses au niveau des synapses d'un vrai cerveau d'un vrai locuteur chinois ? L'homme dans la pièce simulerait un vrai cerveau. Il s'agit d'une variante de la "réponse des systèmes" qui semble plus plausible car "le système" fonctionne désormais clairement comme un cerveau humain, ce qui renforce l'intuition qu'il y a quelque chose en plus de l'homme dans la pièce qui pourrait comprendre le chinois.

- Les autres esprits répondent et les épiphénomènes répondent : Plusieurs personnes ont noté que l'argument de Searle n'est qu'une version du problème des autres esprits , appliqué aux machines. Puisqu'il est difficile de décider si les gens pensent "réellement", nous ne devrions pas être surpris qu'il soit difficile de répondre à la même question sur les machines.

- Une question connexe est de savoir si la « conscience » (comme Searle l'entend) existe. Searle soutient que l'expérience de la conscience ne peut être détectée en examinant le comportement d'une machine, d'un être humain ou de tout autre animal. Daniel Dennett souligne que la sélection naturelle ne peut pas préserver une caractéristique d'un animal qui n'a aucun effet sur le comportement de l'animal, et donc la conscience (comme Searle l'entend) ne peut pas être produite par la sélection naturelle. Par conséquent, soit la sélection naturelle n'a pas produit de conscience, soit une "IA forte" est correcte en ce sens que la conscience peut être détectée par un test de Turing conçu de manière appropriée.

La pensée est-elle une sorte de calcul ?

La théorie computationnelle de l'esprit ou « computationalisme » prétend que la relation entre l'esprit et le cerveau est similaire (sinon identique) à la relation entre un programme en cours d'exécution et un ordinateur. L'idée a des racines philosophiques chez Hobbes (qui prétendait que le raisonnement n'était « rien de plus que le calcul »), Leibniz (qui tenta de créer un calcul logique de toutes les idées humaines), Hume (qui pensait que la perception pouvait être réduite à des « impressions atomiques ») et même Kant (qui analysait toute expérience comme contrôlée par des règles formelles). La dernière version est associée aux philosophes Hilary Putnam et Jerry Fodor .

Cette question rejoint nos questions précédentes : si le cerveau humain est une sorte d'ordinateur, alors les ordinateurs peuvent être à la fois intelligents et conscients, répondant à la fois aux questions pratiques et philosophiques de l'IA. En ce qui concerne la question pratique de l'IA (« Une machine peut-elle afficher une intelligence générale ? »), certaines versions du computationalisme affirment que (comme l'a écrit Hobbes ) :

- Le raisonnement n'est rien d'autre que le calcul.

Autrement dit, notre intelligence dérive d'une forme de calcul , proche de l' arithmétique . C'est l' hypothèse du système de symboles physiques discutée ci-dessus, et elle implique que l'intelligence artificielle est possible. En termes de question philosophique de l'IA (« Une machine peut-elle avoir un esprit, des états mentaux et une conscience ? »), la plupart des versions du computationalisme affirment que (comme Stevan Harnad le caractérise) :

- Les états mentaux ne sont que des implémentations de (les bons) programmes informatiques.

C'est "l'IA forte" de John Searle discutée ci-dessus, et c'est la véritable cible de l' argument de la chambre chinoise (selon Harnad ).

Une machine peut-elle avoir des émotions ?

Si les « émotions » sont définies uniquement en fonction de leur effet sur le comportement ou sur la façon dont elles fonctionnent à l' intérieur d'un organisme, alors les émotions peuvent être considérées comme un mécanisme qu'un agent intelligent utilise pour maximiser l' utilité de ses actions. Compte tenu de cette définition de l'émotion, Hans Moravec estime que « les robots en général seront assez émotifs à l'idée d'être des gens sympas ». La peur est une source d'urgence. L'empathie est une composante nécessaire d'une bonne interaction homme-machine . Il dit que les robots "essayeront de vous plaire d'une manière apparemment désintéressée, car ce renforcement positif sera excitant. Vous pouvez interpréter cela comme une sorte d'amour." Daniel Crevier écrit : « Le point de Moravec est que les émotions ne sont que des dispositifs pour canaliser le comportement dans une direction bénéfique à la survie de son espèce. »

Une machine peut-elle être consciente d'elle-même ?

" Conscience de soi ", comme indiqué ci-dessus, est parfois utilisé par les auteurs de science-fiction comme un nom pour la propriété humaine essentielle qui rend un personnage pleinement humain. Turing enlève toutes les autres propriétés de l'être humain et réduit la question à « une machine peut-elle faire l'objet de sa propre pensée ? Peut-il penser à lui - même ? Vu de cette façon, un programme peut être écrit qui peut signaler ses propres états internes, comme un débogueur .

Une machine peut-elle être originale ou créative ?

Turing réduit cela à la question de savoir si une machine peut « nous surprendre » et soutient que cela est évidemment vrai, comme tout programmeur peut en témoigner. Il note qu'avec une capacité de stockage suffisante, un ordinateur peut se comporter d'un nombre astronomique de façons différentes. Il doit être possible, même trivial, pour un ordinateur qui peut représenter des idées de les combiner de manière nouvelle. ( Douglas Lenat de automatisé Mathématicien , à titre d'exemple, les idées combinées pour découvrir de nouvelles vérités mathématiques.) Kaplan et Haenlein suggèrent que les machines peuvent afficher la créativité scientifique, alors qu'il semble probable que les humains auront la haute main où la créativité artistique est concerné.

En 2009, des scientifiques de l'Université d'Aberystwyth au Pays de Galles et de l'Université de Cambridge au Royaume-Uni ont conçu un robot appelé Adam qu'ils pensent être la première machine à proposer de manière indépendante de nouvelles découvertes scientifiques. Toujours en 2009, des chercheurs de Cornell ont développé Eureqa , un programme informatique qui extrapole des formules pour s'adapter aux données saisies, par exemple pour trouver les lois du mouvement à partir du mouvement d'un pendule.

Une machine peut-elle être bienveillante ou hostile ?

Cette question (comme beaucoup d'autres dans la philosophie de l'intelligence artificielle) peut se présenter sous deux formes. « hostilité » peut être définie en termes de fonction ou de comportement , auquel cas « hostile » devient synonyme de « dangereux ». Ou il peut être défini en termes d'intention : une machine peut-elle « délibérément » entreprendre de faire du mal ? Cette dernière est la question "une machine peut-elle avoir des états conscients ?" (comme les intentions ) sous une autre forme.

La question de savoir si des machines hautement intelligentes et complètement autonomes seraient dangereuses a été examinée en détail par des futurologues (comme le Machine Intelligence Research Institute ). L'élément évident du drame a également rendu le sujet populaire dans la science-fiction , qui a envisagé de nombreux scénarios possibles dans lesquels les machines intelligentes constituent une menace pour l'humanité ; voir L'intelligence artificielle dans la fiction .

Un problème est que les machines peuvent acquérir l'autonomie et l'intelligence nécessaires pour être dangereuses très rapidement. Vernor Vinge a suggéré qu'en quelques années seulement, les ordinateurs deviendront soudainement des milliers ou des millions de fois plus intelligents que les humains. Il appelle cela " la Singularité ". Il suggère que cela peut être quelque peu ou peut-être très dangereux pour les humains. Ceci est discuté par une philosophie appelée Singularitarisme .

En 2009, des universitaires et des experts techniques ont assisté à une conférence pour discuter de l'impact potentiel des robots et des ordinateurs et de l'impact de la possibilité hypothétique qu'ils puissent devenir autonomes et capables de prendre leurs propres décisions. Ils ont discuté de la possibilité et de la mesure dans laquelle les ordinateurs et les robots pourraient acquérir n'importe quel niveau d'autonomie, et dans quelle mesure ils pourraient utiliser ces capacités pour éventuellement constituer une menace ou un danger. Ils ont noté que certaines machines ont acquis diverses formes de semi-autonomie, notamment la possibilité de trouver des sources d'énergie par elles-mêmes et la possibilité de choisir de manière indépendante des cibles à attaquer avec des armes. Ils ont également noté que certains virus informatiques peuvent échapper à l'élimination et ont atteint "l'intelligence des cafards". Ils ont noté que la conscience de soi telle que décrite dans la science-fiction est probablement peu probable, mais qu'il y avait d'autres dangers et pièges potentiels.

Certains experts et universitaires ont remis en question l'utilisation de robots pour le combat militaire, en particulier lorsque ces robots sont dotés d'un certain degré de fonctions autonomes. L'US Navy a financé un rapport qui indique qu'à mesure que les robots militaires deviennent plus complexes, il devrait y avoir une plus grande attention aux implications de leur capacité à prendre des décisions autonomes.

Le président de l' Association pour l'avancement de l'intelligence artificielle a commandé une étude pour examiner cette question. Ils désignent des programmes comme le Language Acquisition Device qui peuvent émuler l'interaction humaine.

Certains ont suggéré la nécessité de construire une " IA conviviale ", ce qui signifie que les progrès qui se produisent déjà avec l'IA devraient également inclure un effort pour rendre l'IA intrinsèquement amicale et humaine.

Une machine peut-elle imiter toutes les caractéristiques humaines ?

Turing a dit "Il est de coutume... d'offrir un grain de confort, sous la forme d'une déclaration selon laquelle une caractéristique particulièrement humaine ne pourrait jamais être imitée par une machine... Je ne peux pas offrir un tel confort, car je crois qu'aucun de telles limites peuvent être fixées."

Turing a noté qu'il existe de nombreux arguments de la forme « une machine ne fera jamais X », où X peut être plusieurs choses, telles que :

Soyez gentil, débrouillard, beau, amical, ayez l'initiative, ayez le sens de l'humour, distinguez le bien du mal, faites des erreurs, tombez amoureux, appréciez les fraises et la crème, faites tomber quelqu'un amoureux, apprenez de l'expérience, utilisez les mots correctement , faire l'objet de sa propre pensée, avoir autant de diversité de comportement qu'un homme, faire quelque chose de vraiment nouveau.

Turing soutient que ces objections sont souvent basées sur des hypothèses naïves sur la polyvalence des machines ou sont des « formes déguisées de l'argument de la conscience ». Écrire un programme qui présente l'un de ces comportements "ne fera pas grande impression". Tous ces arguments sont tangents aux prémisses de base de l'IA, à moins qu'il ne puisse être démontré que l'un de ces traits est essentiel pour l'intelligence générale.

Une machine peut-elle avoir une âme ?

Enfin, ceux qui croient en l'existence d'une âme peuvent argumenter que « la pensée est une fonction de l' âme immortelle de l'homme ». Alan Turing a appelé cela « l'objection théologique ». Il écrit

En essayant de construire de telles machines, nous ne devrions pas usurper irrévérencieusement son pouvoir de créer des âmes, pas plus que nous ne le sommes dans la procréation d'enfants : nous sommes plutôt, dans les deux cas, des instruments de sa volonté fournissant des demeures pour les âmes qu'il crée.

Points de vue sur le rôle de la philosophie

Certains chercheurs soutiennent que le rejet de la philosophie par la communauté de l'IA est préjudiciable. Dans l'Encyclopédie de philosophie de Stanford , certains philosophes soutiennent que le rôle de la philosophie dans l'IA est sous-estimé. Le physicien David Deutsch soutient que sans une compréhension de la philosophie ou de ses concepts, le développement de l'IA souffrirait d'un manque de progrès.

Conférences

La principale série de conférences sur la question est "Philosophie et théorie de l'IA" (PT-AI), animée par Vincent C. Müller .

La bibliographie principale sur le sujet, avec plusieurs sous-sections, se trouve sur PhilPapers .

Voir également

- Prise de contrôle de l'IA

- Cerveau artificiel

- Conscience artificielle

- Intelligence artificielle

- Réseau neuronal artificiel

- Chatterbot

- chambre chinoise

- Théorie computationnelle de l'esprit

- Machines informatiques et intelligence

- La critique de l'intelligence artificielle par Dreyfus

- Risque existentiel de l'intelligence artificielle avancée

- Fonctionnalisme

- Système multi-agents

- Philosophie de l'informatique

- Philosophie de l'information

- Philosophie de l'esprit

- Système de symboles physiques

- Réalité simulée

- Superintelligence : chemins, dangers, stratégies

- Intelligence synthétique

Remarques

Les références

Les références

- Adam, Alison (1989). Savoir artificiel : le genre et la machine à penser. Presse Routledge & CRC . https://www.routledge.com/Artificial-Knowing-Gender-and-the-Thinking-Machine/Adam/p/book/9780415129633

- Benjamin, Ruha (2019). Course après la technologie : outils abolitionnistes pour le nouveau code Jim . Wiley. ISBN 978-1-509-52643-7

- Blackmore, Susan (2005), Consciousness: A Very Short Introduction , Oxford University Press

- Bostrom, Nick (2014), Superintelligence : chemins, dangers, stratégies , Oxford University Press, ISBN 978-0-19-967811-2

- Brooks, Rodney (1990), "Les éléphants ne jouent pas aux échecs" (PDF) , Robotique et systèmes autonomes , 6 (1–2) : 3–15, CiteSeerX 10.1.1.588.7539 , doi : 10.1016/S0921-8890( 05) 80025-9 , récupéré le 2007-08-30

- Bryson, Joanna (2019). L'intelligence artificielle de l'éthique de l'intelligence artificielle : un aperçu introductif du droit et de la réglementation, 34.

- Chalmers, David J (1996), The Conscious Mind: In Search of a Fundamental Theory , Oxford University Press, New York, ISBN 978-0-19-511789-9

- Cole, David (automne 2004), "The Chinese Room Argument", dans Zalta, Edward N. (éd.), The Stanford Encyclopedia of Philosophy.

- Crawford, Kate (2021). L'Atlas de l'IA : pouvoir, politique et coûts planétaires de l'intelligence artificielle . Presse universitaire de Yale.

- Crevier, Daniel (1993). IA : la recherche tumultueuse de l'intelligence artificielle . New York, NY : BasicBooks. ISBN 0-465-02997-3.

- Dennett, Daniel (1991), La conscience expliquée , The Penguin Press, ISBN 978-0-7139-9037-9

- Dreyfus, Hubert (1972), Ce que les ordinateurs ne peuvent pas faire , New York : MIT Press, ISBN 978-0-06-011082-6

- Dreyfus, Hubert (1979), Ce que les ordinateurs ne peuvent toujours pas faire , New York : MIT Press.

- Dreyfus, Hubert ; Dreyfus, Stuart (1986), Mind over Machine: The Power of Human Intuition and Expertise in the Era of the Computer , Oxford, Royaume-Uni: Blackwell

- Fearn, Nicholas (2007), Les dernières réponses aux questions les plus anciennes : une aventure philosophique avec les plus grands penseurs du monde , New York : Grove Press

- Gladwell, Malcolm (2005), Blink : Le pouvoir de penser sans penser , Boston : Little, Brown, ISBN 978-0-316-17232-5.

- Harnad, Stevan (2001), « Qu'est-ce qui ne va pas et qu'il y a de vrai à propos de l'argument de la chambre chinoise de Searle ? », dans Bishop, M. ; Preston, J. (eds.), Essais sur l'argument de la chambre chinoise de Searle , Oxford University Press

- Haraway, Donna (1985). Un Manifeste Cyborg .

- Haugeland, John (1985), Intelligence artificielle : l'idée même , Cambridge, Mass. : MIT Press.

- Hofstadter, Douglas (1979), Gödel, Escher, Bach : une éternelle tresse dorée.

- Horst, Steven (2009), "The Computational Theory of Mind", dans Zalta, Edward N. (éd.), The Stanford Encyclopedia of Philosophy , Metaphysics Research Lab, Stanford University.

- Kaplan, Andréas ; Haenlein, Michael (2018), "Siri, Siri in my Hand, who's the Fairest in the Land? On the Interpretations, Illustrations and Implications of Artificial Intelligence", Business Horizons , 62 : 15–25, doi : 10.1016/j.bushor .2018.08.004

- Kurzweil, Ray (2005), La singularité est proche , New York : Viking Press, ISBN 978-0-670-03384-3.

- Lucas, John (1961), "Minds, Machines and Gödel", dans Anderson, AR (éd.), Minds and Machines.

- Malabou, Catherine (2019). Morphing Intelligence : de la mesure du QI aux cerveaux artificiels . (C. Shread, trad.). Presse universitaire de Columbia.

- McCarthy, John ; Minsky, Marvin ; Rochester, Nathan ; Shannon, Claude (1955), A Proposal for the Dartmouth Summer Research Project on Artificial Intelligence , archivé à partir de l'original le 2008-09-30.

- McDermott, Drew (14 mai 1997), "How Intelligent is Deep Blue" , New York Times , archivé à partir de l'original le 4 octobre 2007 , récupéré le 10 octobre 2007

- Moravec, Hans (1988), Mind Children , Harvard University Press

- Penrose, Roger (1989), The Emperor's New Mind: Concerning Computers, Minds, and The Laws of Physics , Oxford University Press, ISBN 978-0-14-014534-2

- Russell, Stuart J. ; Norvig, Peter (2003), Intelligence artificielle : une approche moderne (2e éd.), Upper Saddle River, New Jersey : Prentice Hall, ISBN 0-13-790395-2

- Searle, John (1980), "Minds, Brains and Programs" (PDF) , Behavioral and Brain Sciences , 3 (3) : 417–457, doi : 10.1017/S0140525X00005756 , archivé à partir de l'original (PDF) le 2015-09- 23

- Searle, John (1992), La redécouverte de l'esprit , Cambridge, Massachusetts : MIT Press

- Searle, John (1999), Mind, language and society , New York, NY: Basic Books, ISBN 978-0-465-04521-1, OCLC 231867665

- Turing, Alan (octobre 1950), "Computing Machinery and Intelligence", Mind , LIX (236): 433-460, doi : 10.1093/mind/LIX.236.433 , ISSN 0026-4423

- Yee, Richard (1993), « Machines de Turing et traitement sémantique des symboles : pourquoi les vrais ordinateurs ne dérangent pas les empereurs chinois » (PDF) , Lyceum , 5 (1) : 37-59

- Les numéros de page ci-dessus et le contenu du diagramme renvoient à l' impression Lyceum PDF de l'article.