Analyse de sensibilité - Sensitivity analysis

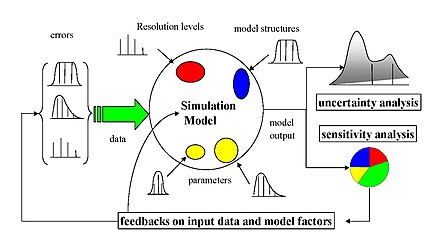

L'analyse de sensibilité est l'étude de la façon dont l' incertitude dans la sortie d'un modèle ou d'un système mathématique (numérique ou autre) peut être divisée et attribuée à différentes sources d'incertitude dans ses entrées. Une pratique connexe est l' analyse de l'incertitude , qui met davantage l'accent sur la quantification de l'incertitude et la propagation de l'incertitude ; idéalement, les analyses d'incertitude et de sensibilité devraient être menées en tandem.

Le processus de recalcul des résultats sous d'autres hypothèses pour déterminer l'impact d'une variable sous analyse de sensibilité peut être utile à diverses fins, notamment :

- Tester la robustesse des résultats d'un modèle ou d'un système en présence d'incertitude.

- Meilleure compréhension des relations entre les variables d'entrée et de sortie dans un système ou un modèle.

- Réduction de l'incertitude, grâce à l'identification des entrées du modèle qui provoquent une incertitude significative dans la sortie et devraient donc être au centre de l'attention afin d'augmenter la robustesse (peut-être par des recherches supplémentaires).

- Recherche d'erreurs dans le modèle (en rencontrant des relations inattendues entre les entrées et les sorties).

- Simplification du modèle – correction de l'entrée du modèle qui n'a aucun effet sur la sortie, ou identification et suppression des parties redondantes de la structure du modèle.

- Améliorer la communication entre les modélisateurs et les décideurs (par exemple en faisant des recommandations plus crédibles, compréhensibles, convaincantes ou persuasives).

- Trouver des régions dans l'espace des facteurs d'entrée pour lesquelles la sortie du modèle est soit maximale, soit minimale ou répond à un critère optimal (voir optimisation et filtrage Monte Carlo).

- En cas d'étalonnage de modèles avec un grand nombre de paramètres, un test de sensibilité primaire peut faciliter l'étape d'étalonnage en se concentrant sur les paramètres sensibles. Ne pas connaître la sensibilité des paramètres peut conduire à passer du temps inutilement sur des paramètres non sensibles.

- Chercher à identifier les liens importants entre les observations, les entrées de modèle et les prédictions ou prévisions, conduisant au développement de meilleurs modèles.

Aperçu

Un modèle mathématique (par exemple en biologie, changement climatique, économie ou ingénierie) peut être très complexe et, par conséquent, ses relations entre les intrants et les extrants peuvent être mal comprises. Dans de tels cas, le modèle peut être considéré comme une boîte noire , c'est-à-dire que la sortie est une fonction "opaque" de ses entrées. Très souvent, certaines ou toutes les entrées du modèle sont sujettes à des sources d' incertitude , notamment des erreurs de mesure , l'absence d'informations et une compréhension médiocre ou partielle des forces motrices et des mécanismes. Cette incertitude impose une limite à notre confiance dans la réponse ou la sortie du modèle. De plus, les modèles peuvent avoir à faire face à la variabilité intrinsèque naturelle du système (aléatoire), telle que l'occurrence d' événements stochastiques .

Une bonne pratique de modélisation exige que le modélisateur fournisse une évaluation de la confiance dans le modèle. Cela nécessite, tout d'abord, une quantification de l'incertitude dans les résultats de tout modèle ( analyse d'incertitude ) ; et deuxièmement, une évaluation de la contribution de chaque entrée à l'incertitude de la sortie. L'analyse de sensibilité aborde le deuxième de ces problèmes (bien que l'analyse d'incertitude soit généralement un précurseur nécessaire), jouant le rôle de classer par importance la force et la pertinence des entrées pour déterminer la variation de la sortie.

Dans les modèles impliquant de nombreuses variables d'entrée, l'analyse de sensibilité est un ingrédient essentiel de la construction du modèle et de l'assurance qualité. Les agences nationales et internationales impliquées dans les études d' évaluation d'impact ont inclus des sections consacrées à l'analyse de sensibilité dans leurs directives. Des exemples sont la Commission européenne (voir par exemple les lignes directrices pour l' évaluation d'impact ), le Bureau de la gestion et du budget de la Maison Blanche , le Groupe d'experts intergouvernemental sur l' évolution du climat et les lignes directrices de modélisation de l' Agence américaine de protection de l'environnement . Dans un commentaire publié en 2020 dans la revue Nature 22, les chercheurs profitent du COVID-19 pour suggérer cinq façons de faire en sorte que les modèles servent mieux la société. L'une des cinq recommandations, sous le titre « Attention aux hypothèses », consiste à « effectuer des analyses globales d'incertitude et de sensibilité [...] permettant à tout ce qui est incertain — variables, relations mathématiques et conditions aux limites — de varier simultanément au fur et à mesure modèle produire sa gamme de prédictions.

Paramètres et contraintes

Le choix de la méthode d'analyse de sensibilité est généralement dicté par un certain nombre de contraintes ou de paramètres problématiques. Certains des plus courants sont

-

Frais de calcul : L' analyse de sensibilité est presque toujours effectuée en exécutant le modèle un nombre (éventuellement grand) de fois, c'est-à-dire une approche basée sur l' échantillonnage . Cela peut être un problème important lorsque,

- Une seule exécution du modèle prend un temps considérable (minutes, heures ou plus). Ce n'est pas inhabituel avec des modèles très complexes.

- Le modèle a un grand nombre d'entrées incertaines. L'analyse de sensibilité est essentiellement l'exploration de l' espace d'entrée multidimensionnel , dont la taille augmente de façon exponentielle avec le nombre d'entrées. Voyez la malédiction de la dimensionnalité .

- Les dépenses de calcul sont un problème dans de nombreuses analyses de sensibilité pratiques. Certaines méthodes de réduction des dépenses de calcul incluent l'utilisation d'émulateurs (pour les grands modèles) et des méthodes de filtrage (pour réduire la dimensionnalité du problème). Une autre méthode consiste à utiliser une méthode d'analyse de sensibilité basée sur les événements pour la sélection de variables pour les applications limitées dans le temps. Il s'agit d'une méthode de sélection de variables d'entrée (IVS) qui rassemble des informations sur la trace des changements dans les entrées et les sorties du système à l'aide d'une analyse de sensibilité pour produire une matrice de déclenchement/d'événement d'entrée/sortie conçue pour mapper les relations entre les données d'entrée en tant que causes qui déclenchent des événements et les données de sortie qui décrivent les événements réels. La relation de cause à effet entre les causes du changement d'état, c'est-à-dire les variables d'entrée et les paramètres de sortie du système d'effet, détermine quel ensemble d'entrées a un impact réel sur une sortie donnée. La méthode présente un net avantage par rapport à la méthode IVS analytique et informatique, car elle essaie de comprendre et d'interpréter le changement d'état du système dans les plus brefs délais avec un minimum de temps de calcul.

- Entrées corrélées : les méthodes d'analyse de sensibilité les plus courantes supposent l' indépendance entre les entrées du modèle, mais parfois les entrées peuvent être fortement corrélées. Il s'agit d'un domaine de recherche encore immature et les méthodes définitives doivent encore être établies.

- Non-linéarité : certaines approches d'analyse de sensibilité, telles que celles basées sur la régression linéaire , peuvent mesurer de manière inexacte la sensibilité lorsque la réponse du modèle est non linéaire par rapport à ses entrées. Dans de tels cas, les mesures fondées sur la variance sont plus appropriées.

- Interactions de modèle : Les interactions se produisent lorsque la perturbation de deux entrées ou plus provoque simultanément une variation de la sortie supérieure à celle de la variation de chacune des entrées seules. De telles interactions sont présentes dans tout modèle non additif , mais seront négligées par des méthodes telles que les nuages de points et les perturbations un par un. L'effet des interactions peut être mesuré par l' indice de sensibilité d'ordre total .

- Sorties multiples : pratiquement toutes les méthodes d'analyse de sensibilité prennent en compte une seule sortie de modèle univariée , mais de nombreux modèles produisent un grand nombre de données pouvant dépendre de l' espace ou du temps. Notez que cela n'exclut pas la possibilité d'effectuer différentes analyses de sensibilité pour chaque sortie d'intérêt. Cependant, pour les modèles dans lesquels les sorties sont corrélées, les mesures de sensibilité peuvent être difficiles à interpréter.

- Données données : alors que dans de nombreux cas, le praticien a accès au modèle, dans certains cas, une analyse de sensibilité doit être effectuée avec des « données données », c'est-à-dire lorsque les points d'échantillonnage (les valeurs des entrées du modèle pour chaque série) ne peuvent pas être choisis par l'analyste. Cela peut se produire lorsqu'une analyse de sensibilité doit être effectuée rétrospectivement, peut-être en utilisant les données d'une analyse d'optimisation ou d'incertitude, ou lorsque les données proviennent d'une source discrète .

Hypothèses vs inférences

Dans l'analyse de l'incertitude et de la sensibilité, il existe un compromis crucial entre le degré de scrupule d'un analyste dans l'exploration des hypothèses d' entrée et l'étendue de l' inférence résultante . Le point est bien illustré par l'économètre Edward E. Leamer :

J'ai proposé une forme d'analyse de sensibilité organisée que j'appelle « analyse de sensibilité globale » dans laquelle un voisinage d'hypothèses alternatives est sélectionné et l'intervalle correspondant d'inférences est identifié. Les conclusions ne sont jugées solides que si le voisinage des hypothèses est suffisamment large pour être crédible et que l'intervalle correspondant d'inférences est suffisamment étroit pour être utile.

Remarque L'accent mis par Leamer est sur le besoin de « crédibilité » dans le choix des hypothèses. Le moyen le plus simple d'invalider un modèle est de démontrer qu'il est fragile par rapport à l'incertitude des hypothèses ou de montrer que ses hypothèses n'ont pas été prises « assez large ». Le même concept est exprimé par Jerome R. Ravetz, pour qui une mauvaise modélisation, c'est quand les incertitudes sur les entrées doivent être supprimées de peur que les sorties ne deviennent indéterminées.

Pièges et difficultés

Certaines difficultés courantes dans l'analyse de sensibilité comprennent

- Trop d'entrées de modèle à analyser. Le criblage peut être utilisé pour réduire la dimensionnalité. Une autre façon de lutter contre la malédiction de la dimensionnalité consiste à utiliser un échantillonnage basé sur des séquences à faible écart.

- Le modèle prend trop de temps à s'exécuter. Les émulateurs (y compris HDMR ) peuvent réduire le temps total en accélérant le modèle ou en réduisant le nombre d'exécutions de modèle nécessaires.

- Il n'y a pas suffisamment d'informations pour construire des distributions de probabilité pour les entrées. Les distributions de probabilité peuvent être construites à partir de l' élicitation d'experts , bien que même dans ce cas, il puisse être difficile de construire des distributions avec une grande confiance. La subjectivité des distributions ou des plages de probabilité affectera fortement l'analyse de sensibilité.

- L'objectif de l'analyse n'est pas clair. Différents tests et mesures statistiques sont appliqués au problème et différents classements de facteurs sont obtenus. Le test doit plutôt être adapté à l'objectif de l'analyse, par exemple, on utilise le filtrage Monte Carlo si l'on s'intéresse aux facteurs qui sont les plus responsables de la génération des valeurs élevées/faibles de la sortie.

- Trop de sorties de modèle sont prises en compte. Cela peut être acceptable pour l'assurance qualité des sous-modèles, mais doit être évité lors de la présentation des résultats de l'analyse globale.

- Sensibilité par morceaux. C'est à ce moment-là que l'on effectue une analyse de sensibilité sur un sous-modèle à la fois. Cette approche n'est pas conservatrice car elle pourrait ignorer les interactions entre les facteurs dans différents sous-modèles (erreur de type II).

- L' approche OAT couramment utilisée n'est pas valable pour les modèles non linéaires. Les méthodes globales doivent être utilisées à la place.

Méthodes d'analyse de sensibilité

Il existe un grand nombre d'approches pour effectuer une analyse de sensibilité, dont beaucoup ont été développées pour répondre à une ou plusieurs des contraintes évoquées ci-dessus. Ils se distinguent également par le type de mesure de sensibilité, qu'elle soit basée (par exemple) sur des décompositions de la variance , des dérivées partielles ou des effets élémentaires . En général, cependant, la plupart des procédures respectent le schéma suivant :

- Quantifier l'incertitude dans chaque entrée (par exemple, les plages, les distributions de probabilité). Notez que cela peut être difficile et qu'il existe de nombreuses méthodes pour obtenir des distributions d'incertitude à partir de données subjectives.

- Identifiez la sortie du modèle à analyser (la cible d'intérêt devrait idéalement avoir une relation directe avec le problème abordé par le modèle).

- Exécutez le modèle un certain nombre de fois en utilisant un certain plan d'expériences , dicté par la méthode de choix et l'incertitude d'entrée.

- À l'aide des sorties de modèle résultantes, calculez les mesures de sensibilité d'intérêt.

Dans certains cas, cette procédure sera répétée, par exemple dans les problèmes de grande dimension où l'utilisateur doit éliminer les variables sans importance avant d'effectuer une analyse de sensibilité complète.

Les différents types de "méthodes de base" (discutées ci-dessous) se distinguent par les diverses mesures de sensibilité qui sont calculées. Ces catégories peuvent en quelque sorte se chevaucher. Des moyens alternatifs d'obtenir ces mesures, sous les contraintes du problème, peuvent être donnés.

Un à la fois (OAT)

L'une des approches les plus simples et les plus courantes consiste à modifier un facteur à la fois (OAT), pour voir quel effet cela produit sur la sortie. L'OAT implique habituellement

- déplacer une variable d'entrée, en gardant les autres à leurs valeurs de base (nominales), puis,

- remettre la variable à sa valeur nominale, puis répéter pour chacune des autres entrées de la même manière.

La sensibilité peut alors être mesurée en surveillant les changements dans la sortie, par exemple par des dérivées partielles ou une régression linéaire . Cela semble une approche logique car tout changement observé dans la sortie sera sans ambiguïté dû à la seule variable modifiée. De plus, en changeant une variable à la fois, on peut garder toutes les autres variables fixées à leurs valeurs centrales ou de base. Cela augmente la comparabilité des résultats (tous les « effets » sont calculés en référence au même point central dans l'espace) et minimise les risques de plantage du programme informatique, plus probable lorsque plusieurs facteurs d'entrée sont modifiés simultanément. L'OAT est fréquemment préféré par les modélisateurs pour des raisons pratiques. En cas de défaillance du modèle sous l'analyse OAT, le modélisateur sait immédiatement quel est le facteur d'entrée responsable de la défaillance.

Cependant, malgré sa simplicité, cette approche n'explore pas complètement l'espace d'entrée, car elle ne prend pas en compte la variation simultanée des variables d'entrée. Cela signifie que l'approche OAT ne peut pas détecter la présence d' interactions entre les variables d'entrée.

Méthodes locales basées sur les dérivés

Les méthodes basées sur les dérivées locales impliquent de prendre la dérivée partielle de la sortie Y par rapport à un facteur d'entrée X i :

où l'indice x 0 indique que la dérivée est prise à un point fixe dans l'espace de l'entrée (d'où le 'local' dans le nom de la classe). La modélisation adjointe et la différenciation automatisée sont des méthodes de cette classe. Semblables à l'OAT, les méthodes locales ne tentent pas d'explorer complètement l'espace d'entrée, car elles examinent de petites perturbations, généralement une variable à la fois. Il est possible de sélectionner des échantillons similaires à partir de la sensibilité basée sur les dérivés via des réseaux neuronaux et d'effectuer une quantification de l'incertitude.

Analyse de régression

L'analyse de régression , dans le contexte de l'analyse de sensibilité, consiste à ajuster une régression linéaire à la réponse du modèle et à utiliser des coefficients de régression standardisés comme mesures directes de la sensibilité. La régression doit être linéaire par rapport aux données (ie un hyperplan, donc sans termes quadratiques, etc., comme régresseurs) car sinon il est difficile d'interpréter les coefficients standardisés. Cette méthode est donc la plus adaptée lorsque la réponse du modèle est en fait linéaire ; la linéarité peut être confirmée, par exemple, si le coefficient de détermination est grand. Les avantages de l'analyse de régression sont qu'elle est simple et a un faible coût de calcul.

Méthodes basées sur la variance

Les méthodes basées sur la variance sont une classe d'approches probabilistes qui quantifient les incertitudes d'entrée et de sortie sous forme de distributions de probabilité et décomposent la variance de sortie en parties attribuables aux variables d'entrée et aux combinaisons de variables. La sensibilité de la sortie à une variable d'entrée est donc mesurée par la quantité de variance dans la sortie causée par cette entrée. Celles-ci peuvent être exprimées sous forme d'espérances conditionnelles, c'est-à-dire qu'en considérant un modèle Y = f ( X ) pour X = { X 1 , X 2 , ... X k }, une mesure de sensibilité de la i ème variable X i est donnée par ,

où « Var » et « E » désignent respectivement les opérateurs de variance et de valeur attendue, et X ~i désigne l'ensemble de toutes les variables d'entrée à l'exception de X i . Cette expression mesure essentiellement la contribution X i seule à l'incertitude (variance) de Y (moyenne sur les variations d'autres variables), et est connue sous le nom d' indice de sensibilité de premier ordre ou indice d'effet principal . Surtout, il ne mesure pas l'incertitude causée par les interactions avec d'autres variables. Une autre mesure, connue sous le nom d' indice d'effet total , donne la variance totale de Y causée par X i et ses interactions avec l'une des autres variables d'entrée. Les deux quantités sont généralement normalisées en divisant par Var( Y ).

Les méthodes basées sur la variance permettent une exploration complète de l'espace d'entrée, en tenant compte des interactions et des réponses non linéaires. Pour ces raisons, ils sont largement utilisés lorsqu'il est possible de les calculer. Généralement, ce calcul implique l'utilisation de méthodes Monte Carlo , mais comme cela peut impliquer plusieurs milliers d'exécutions de modèles, d'autres méthodes (telles que des émulateurs) peuvent être utilisées pour réduire les dépenses de calcul si nécessaire. Notez que les décompositions complètes de la variance ne sont significatives que lorsque les facteurs d'entrée sont indépendants les uns des autres.

Analyse par variogramme des surfaces de réponse ( VARS )

L'un des défauts majeurs des méthodes d'analyse de sensibilité précédentes est qu'aucune d'entre elles ne considère la structure ordonnée spatialement de la surface de réponse/sortie du modèle Y = f ( X ) dans l'espace des paramètres. En utilisant les concepts de variogrammes directionnels et de covariogrammes, l'analyse par variogramme des surfaces de réponse (VARS) corrige cette faiblesse en reconnaissant une structure de corrélation spatialement continue aux valeurs de Y , et donc également aux valeurs de .

Fondamentalement, plus la variabilité est élevée, plus la surface de réponse est hétérogène le long d'une direction/paramètre particulier, à une échelle de perturbation spécifique. En conséquence, dans le cadre VARS, les valeurs des variogrammes directionnels pour une échelle de perturbation donnée peuvent être considérées comme une illustration complète des informations de sensibilité, en liant l'analyse du variogramme aux concepts d'échelle de direction et de perturbation. En conséquence, le cadre VARS tient compte du fait que la sensibilité est un concept dépendant de l'échelle, et surmonte ainsi le problème d'échelle des méthodes traditionnelles d'analyse de sensibilité. Plus important encore, VARS est capable de fournir des estimations relativement stables et statistiquement robustes de la sensibilité des paramètres avec un coût de calcul beaucoup plus faible que d'autres stratégies (environ deux ordres de grandeur plus efficaces). Il est à noter qu'il a été démontré qu'il existe un lien théorique entre le cadre VARS et les approches basées sur la variance et sur les dérivées.

Dépistage

Le dépistage est un cas particulier d'une méthode basée sur l'échantillonnage. L'objectif ici est plutôt d'identifier quelles variables d'entrée contribuent de manière significative à l'incertitude de sortie dans les modèles à haute dimensionnalité, plutôt que de quantifier exactement la sensibilité (c'est-à-dire en termes de variance). Le dépistage a tendance à avoir un coût de calcul relativement faible par rapport à d'autres approches, et peut être utilisé dans une analyse préliminaire pour éliminer les variables non influentes avant d'appliquer une analyse plus informative à l'ensemble restant. L'une des méthodes de criblage les plus couramment utilisées est la méthode des effets élémentaires .

Nuages de points

Un outil simple mais utile consiste à tracer des nuages de points de la variable de sortie par rapport aux variables d'entrée individuelles, après avoir échantillonné (au hasard) le modèle sur ses distributions d'entrée. L'avantage de cette approche est qu'elle peut également traiter des "données données", c'est-à-dire un ensemble de points de données placés arbitrairement, et donne une indication visuelle directe de la sensibilité. Des mesures quantitatives peuvent également être tirées, par exemple en mesurant la corrélation entre Y et X i , ou encore en estimant des mesures basées sur la variance par régression non linéaire .

Méthodes alternatives

Un certain nombre de méthodes ont été développées pour surmonter certaines des contraintes discutées ci-dessus, qui rendraient autrement l'estimation des mesures de sensibilité irréalisable (le plus souvent en raison des dépenses de calcul ). En général, ces méthodes se concentrent sur le calcul efficace de mesures de sensibilité basées sur la variance.

Émulateurs

Les émulateurs (également appelés métamodèles, modèles de substitution ou surfaces de réponse) sont des approches de modélisation des données / apprentissage automatique qui impliquent la construction d'une fonction mathématique relativement simple, appelée émulateur , qui se rapproche du comportement d'entrée/sortie du modèle lui-même. En d'autres termes, il s'agit du concept de « modélisation d'un modèle » (d'où le nom de « métamodèle »). L'idée est que, bien que les modèles informatiques puissent être une série très complexe d'équations qui peuvent prendre beaucoup de temps à résoudre, ils peuvent toujours être considérés en fonction de leurs entrées Y = f ( X ). En exécutant le modèle à un certain nombre de points dans l'espace d'entrée, il peut être possible d'adapter un émulateur beaucoup plus simple η ( X ), tel que η ( X ) ≈ f ( X ) dans une marge d'erreur acceptable. Ensuite, des mesures de sensibilité peuvent être calculées à partir de l'émulateur (soit avec Monte Carlo ou de manière analytique), ce qui aura un coût de calcul supplémentaire négligeable. Il est important de noter que le nombre d'exécutions du modèle requis pour s'adapter à l'émulateur peut être inférieur d'un ordre de grandeur au nombre d'exécutions nécessaires pour estimer directement les mesures de sensibilité à partir du modèle.

Il est clair que l'essentiel de l'approche de l' émulateur est de trouver un η (émulateur) qui est une approximation suffisamment proche du modèle f . Cela nécessite les étapes suivantes,

- Échantillonner (exécuter) le modèle à un certain nombre de points dans son espace d'entrée. Cela nécessite une conception d'échantillon.

- Sélection d'un type d'émulateur (fonction mathématique) à utiliser.

- "Former" l'émulateur à l'aide des données d'échantillon du modèle - cela implique généralement d'ajuster les paramètres de l'émulateur jusqu'à ce que l'émulateur imite le plus possible le vrai modèle.

L'échantillonnage du modèle peut souvent être effectué avec des séquences à faible divergence , telles que la séquence de Sobol - en raison du mathématicien Ilya M. Sobol ou de l'échantillonnage par hypercube latin , bien que des plans aléatoires puissent également être utilisés, au détriment d'une certaine efficacité. La sélection du type d'émulateur et l'apprentissage sont intrinsèquement liés puisque la méthode d'apprentissage dépendra de la classe d'émulateur. Certains types d'émulateurs qui ont été utilisés avec succès pour l'analyse de sensibilité comprennent,

- Processus gaussiens (également connus sous le nom de krigeage ), où toute combinaison de points de sortie est supposée être distribuée sous la forme d'une distribution gaussienne multivariée . Récemment, des processus gaussiens « arborescents » ont été utilisés pour traiter les réponses hétéroscédastiques et discontinues.

- Forêts aléatoires , dans lesquelles un grand nombre d' arbres de décision sont formés, et le résultat moyenné.

- Amplification de gradient , où une succession de régressions simples sont utilisées pour pondérer les points de données afin de réduire séquentiellement les erreurs.

- Développements de chaos polynomial , qui utilisent des polynômes orthogonaux pour approximer la surface de réponse.

- Splines de lissage , normalement utilisées en conjonction avec les troncatures HDMR (voir ci-dessous).

L'utilisation d'un émulateur introduit un problème d' apprentissage automatique , qui peut être difficile si la réponse du modèle est fortement non linéaire . Dans tous les cas, il est utile de vérifier l'exactitude de l'émulateur, par exemple à l'aide de la validation croisée .

Représentations de modèles de grande dimension (HDMR)

Une représentation de modèle de grande dimension (HDMR) (le terme est dû à H. Rabitz) est essentiellement une approche d'émulateur, qui consiste à décomposer la sortie de la fonction en une combinaison linéaire de termes d'entrée et d'interactions de dimensionnalité croissante. L'approche HDMR exploite le fait que le modèle peut généralement être bien approximé en négligeant les interactions d'ordre supérieur (deuxième ou troisième ordre et au-dessus). Les termes de la série tronquée peuvent alors chacun être approximés par, par exemple, des polynômes ou des splines (REFS) et la réponse exprimée comme la somme des principaux effets et interactions jusqu'à l'ordre de troncature. De ce point de vue, les HDMR peuvent être vus comme des émulateurs qui négligent les interactions d'ordre élevé ; l'avantage est qu'ils sont capables d'émuler des modèles avec une dimensionnalité plus élevée que les émulateurs d'ordre complet.

Test de sensibilité d'amplitude de Fourier (FAST)

Le test de sensibilité à l'amplitude de Fourier (FAST) utilise la série de Fourier pour représenter une fonction multivariée (le modèle) dans le domaine fréquentiel, en utilisant une seule variable de fréquence. Par conséquent, les intégrales requises pour calculer les indices de sensibilité deviennent univariées, ce qui entraîne des économies de calcul.

Autre

Méthodes basées sur le filtrage Monte Carlo. Celles-ci sont également basées sur l'échantillonnage et l'objectif ici est d'identifier des régions dans l'espace des facteurs d'entrée correspondant à des valeurs particulières (par exemple hautes ou basses) de la sortie.

Applications

Des exemples d'analyses de sensibilité peuvent être trouvés dans divers domaines d'application, tels que :

- Sciences environnementales

- Entreprise

- Sciences sociales

- Chimie

- Ingénierie

- Épidémiologie

- Méta-analyse

- Prise de décision multicritères

- Prise de décision urgente

- Calibrage du modèle

- Quantification de l'incertitude

Audit de sensibilité

Il peut arriver qu'une analyse de sensibilité d'une étude basée sur un modèle soit destinée à étayer une inférence et à certifier sa robustesse, dans un contexte où l'inférence alimente un processus politique ou décisionnel. Dans ces cas, le cadrage de l'analyse elle-même, son contexte institutionnel et les motivations de son auteur peuvent devenir une question de grande importance, et une analyse de sensibilité pure - avec son accent sur l'incertitude paramétrique - peut être considérée comme insuffisante. L'accent mis sur le cadrage peut provenir, entre autres, de la pertinence de l'étude de politique pour différents groupes d'intérêt caractérisés par des normes et des valeurs différentes, et donc par une histoire différente sur « quel est le problème » et avant tout sur « qui dit le histoire'. Le plus souvent, le cadrage comprend des hypothèses plus ou moins implicites, qui peuvent être politiques (par exemple quel groupe doit être protégé) jusqu'à techniques (par exemple quelle variable peut être traitée comme une constante).

Afin de tenir dûment compte de ces préoccupations, les instruments de la SA ont été étendus pour fournir une évaluation de l'ensemble du processus de génération de connaissances et de modèles. Cette approche a été appelée « audit de sensibilité ». Il s'inspire de NUSAP, une méthode utilisée pour qualifier la valeur des informations quantitatives avec la génération de « pedigrees » de nombres. De même, l'audit de sensibilité a été développé pour fournir des pedigrees de modèles et des inférences basées sur des modèles. L'audit de sensibilité a été spécialement conçu pour un contexte contradictoire, où non seulement la nature de la preuve, mais aussi le degré de certitude et d'incertitude associé à la preuve, feront l'objet d'intérêts partisans. L'audit de sensibilité est recommandé dans les lignes directrices de la Commission européenne pour l'évaluation d'impact, ainsi que dans le rapport Science Advice for Policy by European Academies.

Concepts associés

L'analyse de sensibilité est étroitement liée à l'analyse d'incertitude ; alors que ce dernier étudie l' incertitude globale dans les conclusions de l'étude, l'analyse de sensibilité tente d'identifier quelle source d'incertitude pèse le plus sur les conclusions de l'étude.

La problématique de l'analyse de sensibilité présente également de fortes similitudes avec le domaine de la conception des expériences . Dans un plan d'expériences, on étudie l'effet d'un processus ou d'une intervention (le « traitement ») sur certains objets (les « unités expérimentales »). Dans l'analyse de sensibilité, on examine l'effet de la variation des entrées d'un modèle mathématique sur la sortie du modèle lui-même. Dans les deux disciplines, on s'efforce d'obtenir des informations du système avec un minimum d'expériences physiques ou numériques.

Voir également

- Causalité

- Méthode des effets élémentaires

- Analyse de l'incertitude expérimentale

- Test de sensibilité d'amplitude de Fourier

- Théorie de la décision sur l'écart d'information

- Intervalle MEF

- Analyse des perturbations

- Conception probabiliste

- Analyse des limites de probabilité

- Robustification

- courbe ROC

- Quantification de l'incertitude

- Analyse de sensibilité basée sur la variance

Les références

Lectures complémentaires

- Cannavó, F. (2012). « Analyse de sensibilité pour l'évaluation de la qualité de la modélisation des sources volcaniques et la sélection du modèle ». Informatique & Géosciences . 44 : 52-59. Bibcode : 2012CG ..... 44 ... 52C . doi : 10.1016/j.cageo.2012.03.008 .

- Fassò A. (2007) "Analyse de sensibilité statistique et qualité de l'eau". Dans Wymer L. Ed, Statistical Framework for Water Quality Criteria and Monitoring . Wiley, New York.

- Fassò A., Perri PF (2002) "Analyse de sensibilité". Dans Abdel H. El-Shaarawi et Walter W. Piegorsch (eds) Encyclopedia of Environmetrics , Volume 4, pp 1968-1982, Wiley.

- Fassò A., Esposito E., Porcu E., Reverberi AP, Vegliò F. (2003) "Analyse de sensibilité statistique des réacteurs à colonne remplie pour les eaux usées contaminées". Environmétrie . Vol. 14, n.8, 743-759.

- Haug, Edward J.; Choi, Kyung K. ; Komkov, Vadim (1986) Analyse de sensibilité de conception des systèmes structuraux . Mathématiques en sciences et en ingénierie, 177. Academic Press, Inc., Orlando, FL.

- Pianosi, F.; Beven, K.; Freer, J.; Hall, JW ; Rougier, J. ; Stephenson, DB ; Wagener, T. (2016). « Analyse de sensibilité des modèles environnementaux : une revue systématique avec un flux de travail pratique » . Modélisation environnementale et logiciel . 79 : 214-232. doi : 10.1016/j.envsoft.2016.02.008 .

- Pilkey, OH et L. Pilkey-Jarvis (2007), Arithmétique inutile. Pourquoi les scientifiques de l'environnement ne peuvent pas prédire l'avenir. New York : Columbia University Press.

- Santner, TJ; Williams, BJ; Notz, WI (2003) Conception et analyse d'expériences informatiques ; Springer-Verlag.

- Taleb, NN, (2007) Le cygne noir : L'impact de la maison aléatoire hautement improbable .

Problèmes spéciaux

- Reliability Engineering & System Safety , 2003, 79:121-2 : SAMO 2001 : Avancées méthodologiques et applications innovantes de l'analyse de sensibilité , édité par Tarantola S, Saltelli.

- Reliability Engineering and System Safety , Volume 91, 2006, Numéro spécial sur l'analyse de sensibilité, édité par Helton JC, Cooke RM, McKay MD, Saltelli.

- International Journal of Chemical Kinetics 2008, Volume 40, Numéro 11 - Numéro spécial sur l'analyse de sensibilité, édité par Turányi T.

- Reliability Engineering & System Safety , Volume 94, Numéro 7, Pages 1133-1244 (Juillet 2009), Numéro spécial sur l'analyse de sensibilité, édité par Andrea Saltelli.

- Reliability Engineering & System Safety , Volume 107, novembre 2012, Advances in sensibilité analysis, SAMO 2010, édité par Borgonovo E, Tarantola S.

- Journal of Statistical Computation and Simulation Volume 85, 2015 - Numéro 7 : Numéro spécial : Articles sélectionnés de la 7e Conférence internationale sur l'analyse de sensibilité des sorties de modèles, juillet 2013, Nice, France, édité par David Ginsbourger, Bertrand Iooss & Luc Pronzato.

- Reliability Engineering & System Safety , Volume 134, février 2015, édité par Stefano Tarantola, et Nathalie Saint-Geours.

- Environmental Modeling & Software , Numéro spécial : Analyse de sensibilité pour la modélisation environnementale (2021), édité par Saman Razavi, Andrea Saltelli, Tony Jakeman, Qiongli Wu.

Liens externes

- Joseph Hart, Julie Bessac, Emil Constantinescu (2018), "Global sensibilité analysis for statistics model parameters", arXiv : 1708.07441

- page web sur l'analyse de sensibilité – (Centre commun de recherche de la Commission européenne)

- SimLab , le logiciel gratuit d'analyse de sensibilité globale du Centre commun de recherche

- Projet MUCM - Ressources étendues pour l'analyse d'incertitude et de sensibilité des modèles exigeants en calcul.