Exploration de texte - Text mining

L'exploration de texte , également appelée exploration de données de texte , similaire à l' analyse de texte , est le processus consistant à dériver des informations de haute qualité à partir de texte . Il s'agit de « la découverte par ordinateur de nouvelles informations auparavant inconnues, en extrayant automatiquement des informations à partir de différentes ressources écrites ». Les ressources écrites peuvent inclure des sites Web , des livres , des e - mails , des critiques et des articles. Des informations de haute qualité sont généralement obtenues en concevant des modèles et des tendances par des moyens tels que l'apprentissage statistique de modèles . Selon Hotho et al. (2005), nous pouvons différer trois perspectives différentes de l'exploration de texte : l' extraction d'informations , l'exploration de données et un processus KDD (Knowledge Discovery in Databases). L'exploration de texte implique généralement le processus de structuration du texte d'entrée (généralement l'analyse, avec l'ajout de certaines caractéristiques linguistiques dérivées et la suppression d'autres, et l'insertion ultérieure dans une base de données ), la dérivation de modèles dans les données structurées , et enfin l'évaluation et l'interprétation de la sortie. « Haute qualité » dans l'exploration de texte fait généralement référence à une combinaison de pertinence , de nouveauté et d'intérêt. Les tâches d'exploration de texte typiques comprennent la catégorisation de textes , le regroupement de texte , le concept / extraction d'entités, la production de taxonomies granulaire, l' analyse des sentiments , documents summarization et entité relation modélisation ( à savoir , les relations d' apprentissage entre les entités nommées ).

L'analyse de texte implique la récupération d'informations , l'analyse lexicale pour étudier les distributions de fréquence de mots, la reconnaissance de formes , le marquage / annotation , l' extraction d'informations , les techniques d' exploration de données, y compris l'analyse de liens et d'associations, la visualisation et l'analyse prédictive . L'objectif global est essentiellement de transformer le texte en données à analyser, via l'application du traitement du langage naturel (TAL), différents types d' algorithmes et de méthodes analytiques. Une phase importante de ce processus est l'interprétation des informations recueillies.

Une application typique consiste à numériser un ensemble de documents écrits dans un langage naturel et soit à modéliser l' ensemble de documents à des fins de classification prédictive , soit à remplir une base de données ou un index de recherche avec les informations extraites. Le document est l'élément de base en commençant par le text mining. Ici, nous définissons un document comme une unité de données textuelles, qui existe normalement dans de nombreux types de collections.

Analyse de texte

Le terme analyse de texte décrit un ensemble de techniques linguistiques , statistiques et d' apprentissage automatique qui modélisent et structurent le contenu informationnel des sources textuelles pour la veille économique , l'analyse exploratoire des données , la recherche ou l'investigation. Le terme est à peu près synonyme de text mining ; en effet, Ronen Feldman a modifié une description de 2000 de « text mining » en 2004 pour décrire « text analytics ». Ce dernier terme est maintenant utilisé plus fréquemment dans les milieux d'affaires tandis que « l'exploration de texte » est utilisé dans certains des premiers domaines d'application, datant des années 1980, notamment la recherche en sciences de la vie et le renseignement gouvernemental.

Le terme analyse de texte décrit également cette application de l'analyse de texte pour répondre à des problèmes commerciaux, que ce soit de manière indépendante ou en conjonction avec la requête et l'analyse de données numériques sur le terrain. C'est un truisme que 80% des informations pertinentes pour l'entreprise proviennent d'une forme non structurée , principalement du texte. Ces techniques et processus découvrent et présentent des connaissances (faits, règles métier et relations) qui sont autrement verrouillées sous forme textuelle, impénétrables au traitement automatisé.

Processus d'analyse de texte

Les sous-tâches (composantes d'un effort d'analyse de texte plus large) comprennent généralement :

- La réduction de la dimensionnalité est une technique importante pour le prétraitement des données. La technique est utilisée pour identifier le mot racine des mots réels et réduire la taille des données de texte.

- La recherche d'informations ou l'identification d'un corpus est une étape préparatoire : la collecte ou l'identification d'un ensemble de documents textuels, sur le Web ou conservés dans un système de fichiers, une base de données ou un gestionnaire de corpus de contenu , en vue de leur analyse.

- Bien que certains systèmes d'analyse de texte appliquent exclusivement des méthodes statistiques avancées, de nombreux autres appliquent un traitement du langage naturel plus étendu , comme une partie du balisage de la parole , l' analyse syntaxique et d'autres types d'analyse linguistique.

- La reconnaissance d'entités nommées est l'utilisation de répertoires géographiques ou de techniques statistiques pour identifier des éléments de texte nommés : personnes, organisations, noms de lieux, symboles boursiers, certaines abréviations, etc.

- La désambiguïsation - l'utilisation d' indices contextuels - peut être nécessaire pour décider où, par exemple, "Ford" peut faire référence à un ancien président américain, un constructeur automobile, une star de cinéma, une traversée de rivière ou une autre entité.

- Reconnaissance des entités identifiées par modèle : des caractéristiques telles que les numéros de téléphone, les adresses e-mail, les quantités (avec unités) peuvent être discernées via une expression régulière ou d'autres correspondances de modèle.

- Regroupement de documents : identification d'ensembles de documents de texte similaires.

- Coréférence : identification de syntagmes nominaux et d'autres termes qui se réfèrent au même objet.

- Extraction de relations, de faits et d'événements : identification des associations entre les entités et d'autres informations dans le texte

- L'analyse des sentiments implique de discerner du matériel subjectif (par opposition aux faits) et d'extraire diverses formes d'informations sur les attitudes : sentiment, opinion, humeur et émotion. Les techniques d'analyse de texte sont utiles pour analyser le sentiment au niveau de l'entité, du concept ou du sujet et pour distinguer le détenteur d'opinion et l'objet d'opinion.

- L'analyse quantitative de texte est un ensemble de techniques issues des sciences sociales où un juge humain ou un ordinateur extrait les relations sémantiques ou grammaticales entre les mots afin de découvrir le sens ou les modèles stylistiques d'un texte personnel occasionnel dans le but de profilage psychologique, etc.

Applications

La technologie d'exploration de texte est maintenant largement appliquée à une grande variété de besoins gouvernementaux, de recherche et d'affaires. Tous ces groupes peuvent utiliser le text mining pour la gestion des enregistrements et la recherche de documents pertinents pour leurs activités quotidiennes. Les professionnels du droit peuvent utiliser le text mining pour l' e-discovery , par exemple. Les gouvernements et les groupes militaires utilisent le text mining à des fins de sécurité nationale et de renseignement. Les chercheurs scientifiques de text mining intégrer des approches dans les efforts pour organiser de grands ensembles de données de textes ( par exemple, résoudre le problème des données non structurées ), afin de déterminer les idées communiquées par le texte (par exemple, l' analyse des sentiments dans les médias sociaux ) et pour soutenir la découverte scientifique dans des domaines tels que les sciences de la vie et la bioinformatique . En entreprise, les applications sont utilisées pour soutenir la veille concurrentielle et le placement automatisé d' annonces , parmi de nombreuses autres activités.

Applications de sécurité

De nombreux progiciels d'exploration de texte sont commercialisés pour des applications de sécurité , en particulier la surveillance et l'analyse de sources de texte brut en ligne telles que les actualités Internet , les blogs , etc. à des fins de sécurité nationale . Il est également impliqué dans l'étude du chiffrement / déchiffrement du texte .

Applications biomédicales

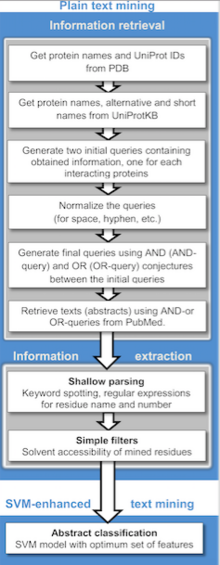

Une gamme d'applications d'exploration de texte dans la littérature biomédicale a été décrite, y compris des approches informatiques pour faciliter les études sur l'amarrage des protéines , les interactions protéiques et les associations protéine-maladie. De plus, avec de grands ensembles de données textuelles de patients dans le domaine clinique, des ensembles de données d'informations démographiques dans les études de population et les rapports d'événements indésirables, l'exploration de texte peut faciliter les études cliniques et la médecine de précision. Les algorithmes d'exploration de texte peuvent faciliter la stratification et l'indexation d'événements cliniques spécifiques dans de grands ensembles de données textuelles de patients sur les symptômes, les effets secondaires et les comorbidités à partir des dossiers de santé électroniques, des rapports d'événements et des rapports de tests de diagnostic spécifiques. Une application d'exploration de texte en ligne dans la littérature biomédicale est PubGene , un moteur de recherche accessible au public qui combine l'exploration de texte biomédicale et la visualisation de réseau. GoPubMed est un moteur de recherche basé sur la connaissance pour les textes biomédicaux. Les techniques d'exploration de texte nous permettent également d'extraire des connaissances inconnues à partir de documents non structurés dans le domaine clinique

Applications de programme

Des méthodes et des logiciels d'exploration de texte sont également recherchés et développés par de grandes entreprises, dont IBM et Microsoft , pour automatiser davantage les processus d'exploration et d'analyse, et par différentes entreprises travaillant dans le domaine de la recherche et de l'indexation en général afin d'améliorer leurs résultats. . Au sein du secteur public, beaucoup d'efforts ont été concentrés sur la création de logiciels pour le suivi et la surveillance des activités terroristes . À des fins d'étude, le logiciel Weka est l'une des options les plus populaires dans le monde scientifique, agissant comme un excellent point d'entrée pour les débutants. Pour les programmeurs Python, il existe une excellente boîte à outils appelée NLTK à des fins plus générales. Pour les programmeurs plus avancés, il existe également la bibliothèque Gensim , qui se concentre sur les représentations textuelles basées sur l'incorporation de mots.

Applications médias en ligne

L'exploration de texte est utilisée par de grandes sociétés de médias, telles que la Tribune Company , pour clarifier les informations et offrir aux lecteurs de meilleures expériences de recherche, ce qui augmente à son tour la « viscosité » du site et les revenus. De plus, sur le back-end, les éditeurs bénéficient de la possibilité de partager, d'associer et de regrouper les actualités entre les propriétés, ce qui augmente considérablement les opportunités de monétisation du contenu.

Applications commerciales et marketing

L'analyse de texte est utilisée dans les affaires, en particulier dans le marketing, comme dans la gestion de la relation client . Coussement et Van den Poel (2008) l'appliquent pour améliorer les modèles d' analyse prédictive de l' attrition des clients ( usure des clients ). L'exploration de texte est également appliquée à la prévision des rendements boursiers.

Analyse des sentiments

L'analyse des sentiments peut impliquer l'analyse des critiques de films pour estimer à quel point une critique est favorable pour un film. Une telle analyse peut nécessiter un ensemble de données étiquetées ou un étiquetage de l' affectivité des mots. Des ressources pour l'affectivité des mots et des concepts ont été créées pour WordNet et ConceptNet , respectivement.

Le texte a été utilisé pour détecter les émotions dans le domaine connexe de l'informatique affective. Les approches textuelles de l'informatique affective ont été utilisées sur plusieurs corpus tels que les évaluations des étudiants, les histoires pour enfants et les reportages.

Exploitation de la littérature scientifique et applications académiques

La question de l'exploration de texte est importante pour les éditeurs qui détiennent de grandes bases de données d'informations nécessitant une indexation pour la récupération. Cela est particulièrement vrai dans les disciplines scientifiques, dans lesquelles des informations très spécifiques sont souvent contenues dans le texte écrit. Par conséquent, des initiatives ont été prises , telles que la nature de la proposition d'Open Text Interface Mining (OTMI) et l' Institut national de la santé commune de Journal Publishing Document Type Definition (DTD) qui fournirait des indices sémantiques aux machines à des requêtes spécifiques de réponse contenue dans le texte sans supprimer les barrières de l'éditeur à l'accès public.

Les institutions académiques se sont également impliquées dans l'initiative de text mining :

- Le National Center for Text Mining (NaCTeM) est le premier centre de text mining au monde financé par des fonds publics. NaCTeM est exploité par l' Université de Manchester en étroite collaboration avec le Tsujii Lab de l' Université de Tokyo . NaCTeM fournit des outils personnalisés, des installations de recherche et offre des conseils à la communauté universitaire. Ils sont financés par le Joint Information Systems Committee (JISC) et deux des conseils de recherche britanniques ( EPSRC et BBSRC ). En se concentrant initialement sur l'exploration de texte dans les sciences biologiques et biomédicales , la recherche s'est depuis étendue aux domaines des sciences sociales .

- Aux États-Unis, la School of Information de l' Université de Californie à Berkeley développe un programme appelé BioText pour aider les chercheurs en biologie dans l'exploration et l'analyse de textes.

- Le Text Analysis Portal for Research (TAPoR), actuellement hébergé à l' Université de l'Alberta , est un projet universitaire visant à cataloguer les applications d'analyse de texte et à créer une passerelle pour les chercheurs novices dans la pratique.

Méthodes d'exploration de la littérature scientifique

Des méthodes informatiques ont été développées pour faciliter la recherche d'informations dans la littérature scientifique. Les approches publiées comprennent des méthodes de recherche, de détermination de la nouveauté et de clarification des homonymes parmi les rapports techniques.

Humanités numériques et sociologie computationnelle

L'analyse automatique de vastes corpus textuels a créé la possibilité pour les chercheurs d'analyser des millions de documents dans plusieurs langues avec une intervention manuelle très limitée. Les principales technologies habilitantes ont été l'analyse, la traduction automatique , la catégorisation des sujets et l'apprentissage automatique.

L'analyse automatique des corpus textuels a permis d'extraire les acteurs et leurs réseaux relationnels à grande échelle, transformant les données textuelles en données de réseau. Les réseaux résultants, qui peuvent contenir des milliers de nœuds, sont ensuite analysés en utilisant des outils de la théorie des réseaux pour identifier les acteurs clés, les communautés ou parties clés, et des propriétés générales telles que la robustesse ou la stabilité structurelle de l'ensemble du réseau, ou la centralité de certains nœuds. Cela automatise l'approche introduite par l'analyse narrative quantitative, où des triplets sujet-verbe-objet sont identifiés à des paires d'acteurs liés par une action, ou des paires formées par acteur-objet.

L'analyse de contenu est depuis longtemps une partie traditionnelle des sciences sociales et des études sur les médias. L'automatisation de l'analyse de contenu a permis une révolution du « big data » dans ce domaine, avec des études sur le contenu des médias sociaux et des journaux qui incluent des millions d'articles d'actualité. Les préjugés sexistes , la lisibilité , la similarité du contenu, les préférences des lecteurs et même l'humeur ont été analysés sur la base de méthodes d'exploration de texte sur des millions de documents. L'analyse de la lisibilité, des préjugés sexistes et des préjugés thématiques a été démontrée dans Flaounas et al. montrer comment différents sujets ont des préjugés sexistes et des niveaux de lisibilité différents ; la possibilité de détecter des modèles d'humeur dans une vaste population en analysant le contenu de Twitter a également été démontrée.

Logiciel

Les programmes informatiques d'exploration de texte sont disponibles auprès de nombreuses sociétés et sources commerciales et open source . Voir Liste des logiciels de text mining .

Loi sur la propriété intellectuelle

Situation en Europe

En vertu des lois européennes sur le droit d'auteur et les bases de données , l'extraction d'œuvres protégées par le droit d'auteur (par exemple par l'extraction Web ) sans l'autorisation du propriétaire du droit d'auteur est illégale. Au Royaume-Uni en 2014, sur la recommandation de l' examen Hargreaves , le gouvernement a modifié la loi sur le droit d'auteur pour autoriser l'exploration de texte en tant que limitation et exception . C'était le deuxième pays au monde à le faire, après le Japon , qui a introduit une exception spécifique à l'exploitation minière en 2009. Cependant, en raison de la restriction de la directive sur la société de l' information (2001), l'exception britannique n'autorise l'extraction de contenu que pour les non-utilisateurs. fins commerciales. La loi britannique sur le droit d'auteur ne permet pas que cette disposition soit annulée par des conditions contractuelles.

La Commission européenne a facilité la discussion des parties prenantes sur l'exploration de textes et de données en 2013, sous le titre de Licences pour l'Europe. Le fait que l'accent mis sur la solution à ce problème juridique était les licences, et non les limitations et exceptions au droit d'auteur, a conduit des représentants d'universités, de chercheurs, de bibliothèques, de groupes de la société civile et d' éditeurs en libre accès à quitter le dialogue avec les parties prenantes en mai 2013.

Situation aux États-Unis

La loi américaine sur le droit d'auteur , et en particulier ses dispositions sur l' utilisation équitable , signifie que l'exploration de texte en Amérique, ainsi que dans d'autres pays d'utilisation équitable tels qu'Israël, Taïwan et la Corée du Sud, est considérée comme légale. Comme le text mining est transformateur, c'est-à-dire qu'il ne remplace pas l'œuvre originale, il est considéré comme licite dans le cadre d'un usage loyal. Par exemple, dans le cadre du règlement Google Book, le président de l'affaire a statué que le projet de numérisation de Google de livres protégés par le droit d'auteur était licite, en partie à cause des utilisations transformatrices affichées par le projet de numérisation, l'une de ces utilisations étant l'exploration de texte et de données. .

Implications

Jusqu'à récemment, les sites Web utilisaient le plus souvent des recherches textuelles, qui ne trouvaient que des documents contenant des mots ou des phrases spécifiques définis par l'utilisateur. Désormais, grâce à l'utilisation d'un web sémantique , l'exploration de texte peut trouver du contenu basé sur le sens et le contexte (plutôt que simplement par un mot spécifique). De plus, un logiciel d'exploration de texte peut être utilisé pour créer de grands dossiers d'informations sur des personnes et des événements spécifiques. Par exemple, de grands ensembles de données basés sur des données extraites de reportages peuvent être construits pour faciliter l'analyse des réseaux sociaux ou le contre-espionnage . En effet, le logiciel d'exploration de texte peut agir dans une capacité similaire à celle d'un analyste du renseignement ou d'un bibliothécaire de recherche, mais avec une portée d'analyse plus limitée. L'exploration de texte est également utilisée dans certains filtres anti-spam pour déterminer les caractéristiques des messages susceptibles d'être des publicités ou d'autres éléments indésirables. L'exploration de texte joue un rôle important dans la détermination du sentiment des marchés financiers .

Futur

Un intérêt croissant est porté à l'exploration de données multilingues : la capacité d'obtenir des informations dans plusieurs langues et de regrouper des éléments similaires provenant de différentes sources linguistiques en fonction de leur signification.

Le défi d'exploiter la grande proportion d'informations d'entreprise provenant d'une forme « non structurée » est reconnu depuis des décennies. Il est reconnu dans la première définition de la Business Intelligence (BI), dans un article de l'IBM Journal d'octobre 1958 par HP Luhn, A Business Intelligence System, qui décrit un système qui :

"...utiliser des machines de traitement de données pour l'auto-abstrait et l'auto-encodage des documents et pour créer des profils d'intérêt pour chacun des "points d'action" dans une organisation. Les documents entrants et générés en interne sont automatiquement abstraits, caractérisés par un mot modèle, et envoyé automatiquement aux points d'action appropriés."

Pourtant, alors que les systèmes d'information de gestion se développaient à partir des années 1960 et que la BI émergeait dans les années 80 et 90 en tant que catégorie de logiciels et domaine de pratique, l'accent était mis sur les données numériques stockées dans des bases de données relationnelles. Ce n'est pas surprenant : le texte dans les documents "non structurés" est difficile à traiter. L'émergence de l'analyse de texte dans sa forme actuelle découle d'un recentrage de la recherche à la fin des années 1990 du développement d'algorithmes à l'application, comme décrit par le professeur Marti A. Hearst dans l'article Untangling Text Data Mining :

Pendant près d'une décennie, la communauté de la linguistique informatique a considéré les grandes collections de textes comme une ressource à exploiter afin de produire de meilleurs algorithmes d'analyse de texte. Dans cet article, j'ai tenté de suggérer un nouvel accent : l'utilisation de grandes collections de textes en ligne pour découvrir de nouveaux faits et tendances sur le monde lui-même. Je suggère que pour progresser, nous n'avons pas besoin d'une analyse de texte intelligente entièrement artificielle ; au contraire, un mélange d'analyses basées sur le calcul et guidées par l'utilisateur peut ouvrir la porte à de nouveaux résultats passionnants.

L'énoncé des besoins de Hearst en 1999 décrit assez bien l'état de la technologie et de la pratique de l'analyse de texte une décennie plus tard.

Voir également

- Exploitation de concept

- Traitement des documents

- Recherche en texte intégral

- Liste des logiciels de text mining

- Sentiment du marché

- Résolution de noms (sémantique et extraction de texte)

- Reconnaissance d'entité nommée

- Analyse de l'actualité

- Apprentissage des ontologies

- Couplage d'enregistrements

- Extraction de motifs séquentiels ( extraction de chaînes et de séquences)

- w-bardeau

- Web mining , une tâche qui peut impliquer du text mining (par exemple, trouver d'abord les pages Web appropriées en classant les pages Web explorées, puis extraire les informations souhaitées du contenu textuel de ces pages considérées comme pertinentes)

Les références

Citations

Sources

- Ananiadou, S. et McNaught, J. (Editeurs) (2006). Text Mining pour la biologie et la biomédecine . Livres de la Maison Artech. ISBN 978-1-58053-984-5

- Bilisoly, R. (2008). Extraction de texte pratique avec Perl . New York : John Wiley & Fils. ISBN 978-0-470-17643-6

- Feldman, R., et Sanger, J. (2006). Le manuel de Text Mining . New York : Cambridge University Press. ISBN 978-0-521-83657-9

- Hotho, A., Nürnberger, A. et Paaß, G. (2005). « Une brève enquête sur l'exploration de texte ». Dans Ldv Forum, Vol. 20(1), p. 19-62

- Indurkhya, N., et Damerau, F. (2010). Manuel de traitement du langage naturel , 2e édition. Boca Raton, Floride : CRC Press. ISBN 978-1-4200-8592-1

- Kao, A., et Poteet, S. (éditeurs). Traitement du langage naturel et Text Mining . Springer. ISBN 1-84628-175-X

- Konchady, M. Programmation d'applications de Text Mining (Série de programmation) . Charles River Media. ISBN 1-58450-460-9

- Manning, C., et Schutze, H. (1999). Fondements du traitement statistique du langage naturel . Cambridge, MA : Presse du MIT. ISBN 978-0-262-13360-9

- Miner, G., Elder, J., Hill. T, Nisbet, R., Delen, D. et Fast, A. (2012). Exploration de texte pratique et analyse statistique pour les applications de données textuelles non structurées . Elsevier Academic Press. ISBN 978-0-12-386979-1

- McKnight, W. (2005). « Construire l'intelligence d'affaires : l'exploration de données textuelles dans l'intelligence d'affaires ». Revue DM , 21-22.

- Srivastava, A. et Sahami. M. (2009). Exploration de texte : classification, regroupement et applications . Boca Raton, Floride : CRC Press. ISBN 978-1-4200-5940-3

- Zanasi, A. (éditeur) (2007). Text Mining et ses applications à l'intelligence, au CRM et à la gestion des connaissances . WIT Appuyez sur. ISBN 978-1-84564-131-3