Méthode de goulot d'étranglement de l'information - Information bottleneck method

La méthode du goulot d'étranglement de l'information est une technique de la théorie de l'information introduite par Naftali Tishby , Fernando C. Pereira et William Bialek . Il est conçu pour trouver le meilleur compromis entre la précision et la complexité ( compression ) lors de la synthèse (par exemple, le regroupement ) d'une variable aléatoire X , étant donné une distribution de probabilité conjointe p(X,Y) entre X et une variable pertinente observée Y - et auto-décrit comme fournissant "un cadre étonnamment riche pour discuter d'une variété de problèmes dans le traitement du signal et l'apprentissage" .

Les applications incluent le regroupement distributionnel et la réduction de dimension , et plus récemment , il a été suggéré comme fondement théorique de l' apprentissage en profondeur . Il généralise la notion classique de minimes statistiques suffisantes à partir des statistiques paramétriques des distributions arbitraires, pas nécessairement la forme exponentielle. Il le fait en assouplissant la condition de suffisance pour capturer une partie de l' information mutuelle avec la variable pertinente Y .

Le goulot d'étranglement de l'information peut également être considéré comme un problème de distorsion de débit , avec une fonction de distorsion qui mesure à quel point Y est prédit à partir d'une représentation compressée T par rapport à sa prédiction directe à partir de X . Cette interprétation fournit un algorithme itératif général pour résoudre le compromis du goulot d'étranglement de l'information et calculer la courbe d'information à partir de la distribution p(X,Y) .

Soit la représentation compressée donnée par une variable aléatoire . L'algorithme minimise la fonctionnelle suivante par rapport à la distribution conditionnelle :

où et sont les informations mutuelles de et , et de et , respectivement, et est un multiplicateur de Lagrange .

Statistiques suffisantes minimales

Équations auto-cohérentes

Théorie de l'apprentissage

Transitions de phase

Théorie de l'information de l'apprentissage profond

La théorie des goulots d'étranglement de l'information est récemment utilisée pour étudier les réseaux de neurones profonds (DNN). Considérons et respectivement comme les couches d'entrée et de sortie d'un DNN, et soit n'importe quelle couche cachée du réseau. Shwartz-Ziv et Tishby ont proposé le goulot d'étranglement de l'information qui exprime le compromis entre les mesures d'information mutuelle et . Dans ce cas, et respectivement quantifier la quantité d'informations que la couche cachée contient sur l'entrée et la sortie. Ils ont conjecturé que le processus de formation d'un DNN se compose de deux phases distinctes ; 1) une phase d'ajustement initiale dans laquelle augmente, et 2) une phase de compression ultérieure dans laquelle diminue. Saxe et al. en a contré l'affirmation de Shwartz-Ziv et Tishby, déclarant que ce phénomène de compression dans les DNN n'est pas exhaustif et qu'il dépend de la fonction d'activation particulière. En particulier, ils ont affirmé que la compression ne se produit pas avec les fonctions d'activation de ReLu. Shwartz-Ziv et Tishby ont contesté ces affirmations, arguant que Saxe et al n'avaient pas observé de compression en raison de faibles estimations de l'information mutuelle. Récemment, Noshad et al. ont utilisé un estimateur de taux optimal d'informations mutuelles pour explorer cette controverse, en observant que l'estimateur optimal basé sur le hachage révèle le phénomène de compression dans une plus large gamme de réseaux avec des activations ReLu et maxpooling. D'autre part, récemment Goldfeld et al. ont fait valoir que la compression observée est le résultat de phénomènes géométriques et non de la théorie de l'information, un point de vue qui a également été partagé.

Goulot d'étranglement variationnel

goulet d'étranglement gaussien

Le goulot d'étranglement gaussien, à savoir l'application de l'approche du goulot d'étranglement de l'information aux variables gaussiennes, conduit à des solutions liées à l' analyse de corrélation canonique . Supposons que sont conjointement des vecteurs normaux nuls multivariés avec des covariances et qu'il s'agit d'une version compressée de qui doit maintenir une valeur donnée d'information mutuelle avec . On peut montrer que l'optimum est un vecteur normal constitué de combinaisons linéaires des éléments dont la matrice a des lignes orthogonales.

La matrice de projection contient en fait des lignes sélectionnées parmi les vecteurs propres gauches pondérés de la décomposition en valeurs singulières de la matrice (généralement asymétrique)

Définir la décomposition en valeur singulière

et les valeurs critiques

alors le nombre de vecteurs propres actifs dans la projection, ou ordre d'approximation, est donné par

Et nous obtenons enfin

Dans lequel les poids sont donnés par

où

L'application du goulot d'étranglement de l'information gaussien aux séries temporelles (processus) donne des solutions liées au codage prédictif optimal. Cette procédure est formellement équivalente à l' analyse linéaire des caractéristiques lentes.

Les structures temporelles optimales dans les systèmes dynamiques linéaires peuvent être révélées dans ce que l'on appelle le goulot d'étranglement des informations passé-futur, une application de la méthode du goulot d'étranglement aux données échantillonnées non gaussiennes. Le concept, tel qu'il est traité par Creutzig, Tishby et al., n'est pas sans complication car deux phases indépendantes composent l'exercice : d'une part l'estimation des densités de probabilité parent inconnues à partir desquelles les échantillons de données sont tirés et d'autre part l'utilisation de ces densités au sein de le cadre théorique de l'information du goulot d'étranglement.

Estimation de la densité

Étant donné que la méthode du goulot d'étranglement est formulée en termes probabilistes plutôt que statistiques, la densité de probabilité sous-jacente aux points d'échantillonnage doit être estimée. Il s'agit d'un problème bien connu avec plusieurs solutions décrites par Silverman . Dans la présente méthode, les probabilités d'échantillons conjoints sont trouvées en utilisant une méthode de matrice de transition de Markov et cela a une certaine synergie mathématique avec la méthode du goulot d'étranglement elle-même.

La métrique de distance augmentant arbitrairement entre toutes les paires d'échantillons et la matrice de distance est . Ensuite, les probabilités de transition entre les paires d'échantillons pour certains doivent être calculées. En traitant les échantillons comme des états, et une version normalisée de comme une matrice de probabilité de transition d'état de Markov, le vecteur des probabilités des « états » après les étapes, conditionné par l'état initial , est . Le vecteur de probabilité d'équilibre donné, de façon habituelle, par le vecteur propre dominant de la matrice qui est indépendant du vecteur d'initialisation . Cette méthode de transition de Markov établit une probabilité aux points de l'échantillon qui est censée être proportionnelle aux densités de probabilités là-bas.

D'autres interprétations de l'utilisation des valeurs propres de la matrice de distance sont discutées dans Silverman's Density Estimation for Statistics and Data Analysis .

Groupes

Dans l'exemple de clustering souple suivant, le vecteur de référence contient des catégories d'échantillons et la probabilité conjointe est supposée connue. Une grappe souple est définie par sa distribution de probabilité sur les échantillons de données . Tishby et al. a présenté l'ensemble itératif d'équations suivant pour déterminer les clusters qui sont finalement une généralisation de l' algorithme de Blahut-Arimoto , développé dans la théorie de la distorsion de taux . L'application de ce type d'algorithme dans les réseaux de neurones semble provenir d'arguments d'entropie résultant de l'application des distributions de Gibbs dans le recuit déterministe.

La fonction de chaque ligne de l'itération se développe comme

Ligne 1 : Il s'agit d'un ensemble matriciel de probabilités conditionnelles

La divergence de Kullback-Leibler entre les vecteurs générés par les données de l'échantillon et ceux générés par son proxy d'information réduit est appliquée pour évaluer la fidélité du vecteur compressé par rapport aux données de référence (ou catégorielles) conformément à l'équation fondamentale du goulot d'étranglement. est la divergence de Kullback-Leibler entre les distributions

et est une normalisation scalaire. La pondération par l'exposant négatif de la distance signifie que les probabilités des clusters antérieurs sont sous-pondérées sur la ligne 1 lorsque la divergence Kullback-Leibler est grande, ainsi les clusters réussis augmentent en probabilité tandis que ceux qui échouent décroissent.

Ligne 2 : Deuxième ensemble matriciel de probabilités conditionnelles. Par définition

où les identités de Bayes sont utilisées.

Ligne 3 : cette ligne trouve la distribution marginale des clusters

Il s'agit d'un résultat standard.

D'autres entrées de l'algorithme sont la distribution marginale de l'échantillon qui a déjà été déterminée par le vecteur propre dominant de et la fonction de divergence de Kullback-Leibler à valeur matricielle

dérivées des espacements des échantillons et des probabilités de transition.

La matrice peut être initialisée de manière aléatoire ou avec une estimation raisonnable, tandis que la matrice n'a pas besoin de valeurs préalables. Bien que l'algorithme converge, plusieurs minima peuvent exister et doivent être résolus.

Définir les contours de décision

Pour catégoriser un nouvel échantillon externe à l'ensemble d'apprentissage , la métrique de distance précédente recherche les probabilités de transition entre et tous les échantillons dans , avec une normalisation. Deuxièmement, appliquez les deux dernières lignes de l'algorithme à 3 lignes pour obtenir les probabilités de cluster et de catégorie conditionnelle.

finalement

Le paramètre doit être surveillé de près car, à mesure qu'il est augmenté à partir de zéro, un nombre croissant de caractéristiques, dans l'espace de probabilité de catégorie, se mettent au point à certains seuils critiques.

Un exemple

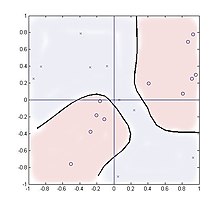

Le cas suivant examine le regroupement dans un multiplicateur à quatre quadrants avec des entrées aléatoires et deux catégories de sortie, , généré par . Cette fonction a deux clusters séparés spatialement pour chaque catégorie et démontre ainsi que la méthode peut gérer de telles distributions.

20 échantillons sont prélevés, uniformément répartis sur le carré . Le nombre de clusters utilisés au-delà du nombre de catégories, deux dans ce cas, a peu d'effet sur les performances et les résultats sont affichés pour deux clusters à l'aide de paramètres .

La fonction de distance est où tandis que la distribution conditionnelle est une matrice 2 × 20

et zéro ailleurs.

La sommation de la ligne 2 n'intègre que deux valeurs représentant les valeurs d'apprentissage de +1 ou -1, mais fonctionne néanmoins bien. La figure montre les emplacements des vingt échantillons avec '0' représentant Y = 1 et 'x' représentant Y = -1. Le contour au niveau du rapport de vraisemblance unitaire est montré,

comme un nouvel échantillon est balayé sur le carré. Théoriquement, le contour doit s'aligner sur les coordonnées et , mais pour de si petits nombres d'échantillons, ils ont plutôt suivi les regroupements parasites des points d'échantillonnage.

Analogies réseau de neurones/logique floue

Cet algorithme est quelque peu analogue à un réseau de neurones avec une seule couche cachée. Les nœuds internes sont représentés par les clusters et les première et deuxième couches de poids de réseau sont les probabilités conditionnelles et respectivement. Cependant, contrairement à un réseau de neurones standard, l'algorithme repose entièrement sur les probabilités comme entrées plutôt que sur les valeurs d'échantillon elles-mêmes, tandis que les valeurs internes et de sortie sont toutes des distributions de densité de probabilité conditionnelles. Les fonctions non linéaires sont encapsulées dans la métrique de distance (ou fonctions d'influence/fonctions à base radiale ) et les probabilités de transition au lieu de fonctions sigmoïdes.

L'algorithme à trois lignes de Blahut-Arimoto converge rapidement, souvent en dizaines d'itérations, et en faisant varier , et et la cardinalité des clusters, divers niveaux de concentration sur les caractéristiques peuvent être atteints.

La définition statistique de clustering souple a un certain chevauchement avec le concept d'appartenance verbale floue de la logique floue .

Rallonges

Une extension intéressante est le cas du goulot d'étranglement de l'information avec des informations secondaires. Ici, les informations sont maximisées sur une variable cible et minimisées sur une autre, apprenant une représentation informative sur des aspects sélectionnés des données. Officiellement

Bibliographie

- Weiss, Y. (1999), « Segmentation using eigenvectors: a unifying view », Actes de la Conférence internationale IEEE sur la vision par ordinateur (PDF) , pp. 975-982

- P. Harremoes et N. Tishby "Le goulot d'étranglement de l'information revisité ou comment choisir une bonne mesure de distorsion". Dans les actes du Symposium international sur la théorie de l'information (ISIT) 2007

![{\displaystyle A=[w_{1}U_{1},\dots ,w_{M}U_{M}]^{T}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2452fbcc21043b263e6427f67922d2f3794ed0da)

![{\displaystyle {\begin{cases}p(c|x)=Kp(c)\exp {\Big (}-\beta \,D^{KL}{\Big [}p(y|x)\, ||\,p(y|c){\Grand ]}{\Grand )}\\p(y|c)=\textstyle \sum _{x}p(y|x)p(c|x)p (x){\big /}p(c)\\p(c)=\textstyle \sum _{x}p(c|x)p(x)\\\end{cases}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f9b29faec038fbb2da40e4ba191be82a2fd73760)

![{\displaystyle A_{i,j}=p(c_{i}|x_{j})=Kp(c_{i})\exp {\Big (}-\beta \,D^{KL}{\Big [}p(y|x_{j})\,||\,p(y|c_{i}){\Grand ]}{\Grand )}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6f287e6823ebfa39f521fe993a875691ff778fdc)

![{\style d'affichage [-1,1]^{2}\,}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a4376d6f93ed4561418bc9e39a4992b97da77bc0)