La loi de Zipf - Zipf's law

|

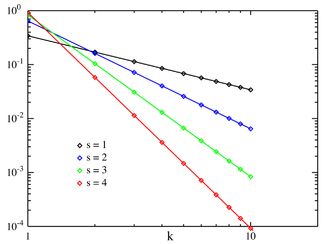

Fonction de masse

Zipf PMF pour N = 10 sur une échelle log–log. L'axe horizontal est l'indice k . (Notez que la fonction n'est définie qu'à des valeurs entières de k . Les lignes de connexion n'indiquent pas la continuité.) | |||

|

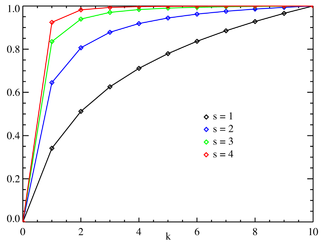

Fonction de distribution cumulative

Zipf CDF pour N = 10. L'axe horizontal est l'indice k . (Notez que la fonction n'est définie qu'à des valeurs entières de k . Les lignes de connexion n'indiquent pas la continuité.) | |||

| Paramètres |

( réel ) ( entier ) |

||

|---|---|---|---|

| Soutien | |||

| CMP | où H N,s est le N ième harmonique généralisé | ||

| CDF | |||

| Moyenne | |||

| Mode | |||

| Variance | |||

| Entropie | |||

| MGF | |||

| FC | |||

La loi de Zipf ( / z ɪ f / , not / t s ɪ p f / comme en allemand) est une loi empirique formulée à l'aide de statistiques mathématiques qui fait référence au fait que pour de nombreux types de données étudiées en sciences physiques et sociales , le rang -la distribution de fréquence est une relation inverse. La distribution zipfienne fait partie d'une famille de distributions de probabilité de loi de puissance discrète apparentées . Elle est liée à la distribution zêta , mais n'est pas identique.

La loi de Zipf a été formulée à l'origine en termes de linguistique quantitative , stipulant qu'étant donné un corpus d' énoncés en langage naturel , la fréquence d'un mot est inversement proportionnelle à son rang dans le tableau des fréquences . Ainsi , le mot le plus fréquent se produit environ deux fois plus que le deuxième mot le plus fréquent, trois fois plus souvent que le troisième mot le plus fréquent, etc. Par exemple, dans le Brown Corpus du texte anglais américain, le mot « le » est le mot le plus fréquent et représente à lui seul près de 7 % de toutes les occurrences de mots (69 971 sur un peu plus de 1 million). Fidèle à la loi de Zipf, le mot de deuxième place « de » représente un peu plus de 3,5 % des mots (36 411 occurrences), suivi de « et » (28 852). Seuls 135 éléments de vocabulaire sont nécessaires pour représenter la moitié du corpus brun.

La loi porte le nom du linguiste américain George Kingsley Zipf (1902-1950), qui l'a popularisée et a cherché à l'expliquer (Zipf 1935, 1949), bien qu'il ne prétende pas en être à l'origine. Le sténographe français Jean-Baptiste Estoup (1868-1950) semble avoir remarqué la régularité avant Zipf. Il a également été noté en 1913 par le physicien allemand Felix Auerbach (1856-1933).

La loi est similaire dans son concept, mais pas identique dans sa distribution, à la loi de Benford .

Autres ensembles de données

La même relation se produit dans de nombreux autres classements de systèmes créés par l'homme, tels que les rangs d'expressions mathématiques ou les rangs de notes dans la musique et même dans des environnements non contrôlés, tels que les rangs de population des villes dans divers pays, la taille des entreprises, les classements des revenus, rangs du nombre de personnes regardant la même chaîne de télévision, transcriptomes des cellules, etc. L'apparition de la distribution dans les classements des villes par population a été remarquée pour la première fois par Felix Auerbach en 1913. Empiriquement, un ensemble de données peut être testé pour voir si la loi de Zipf s'applique en vérifiant la qualité de l'ajustement d'une distribution empirique à la distribution hypothétique de la loi de puissance avec un test de Kolmogorov-Smirnov , puis en comparant le rapport de vraisemblance (log) de la distribution de la loi de puissance à des distributions alternatives comme une distribution exponentielle ou une distribution lognormale.

Lorsque la loi de Zipf est vérifiée pour les villes, un meilleur ajustement a été trouvé avec l'exposant s = 1,07 ; à savoir le n ième plus grande colonie est la taille de la plus grande colonie, autrement dit: que selon la loi de Zipf.

Revue théorique

La loi de Zipf est plus facilement observée en traçant les données sur un graphique log-log , les axes étant log (ordre de rang) et log (fréquence). Par exemple, le mot "le" (comme décrit ci-dessus) apparaîtrait à x = log(1), y = log(69971). Il est également possible de tracer le rang réciproque en fonction de la fréquence ou la fréquence réciproque ou l'intervalle entre les mots en fonction du rang. Les données sont conformes à la loi de Zipf dans la mesure où le tracé est linéaire .

Formellement, soit :

- N le nombre d'éléments ;

- k être leur rang ;

- s la valeur de l'exposant caractérisant la distribution.

La loi de Zipf prédit alors que sur une population de N éléments, la fréquence normalisée de l'élément de rang k , f ( k ; s , N ), est :

La loi de Zipf est vraie si le nombre d'éléments avec une fréquence donnée est une variable aléatoire avec une distribution de loi de puissance

Il a été affirmé que cette représentation de la loi de Zipf est plus appropriée pour les tests statistiques, et de cette manière, elle a été analysée dans plus de 30 000 textes anglais. Les tests d'adéquation indiquent que seulement 15 % environ des textes sont statistiquement compatibles avec cette forme de loi de Zipf. De légères variations dans la définition de la loi de Zipf peuvent augmenter ce pourcentage jusqu'à près de 50 %.

Dans l'exemple de la fréquence des mots de la langue anglaise, N est le nombre de mots de la langue anglaise et, si on utilise la version classique de la loi de Zipf, l'exposant s vaut 1. f ( k ; s , N ) va alors être la fraction du temps où le k ième mot le plus courant apparaît.

La loi peut aussi s'écrire :

où H N,s est le N ième harmonique généralisé .

Le cas le plus simple de la loi de Zipf est un "1/F". Étant donné un ensemble de fréquences distribuées Zipfian, triées de la plus courante à la moins courante, la deuxième fréquence la plus courante se produira deux fois moins souvent que la première, la troisième fréquence la plus courante se produira 1/3aussi souvent que la première et la n ième fréquence la plus courante se produira1/maussi souvent que le premier. Cependant, cela ne peut pas tenir exactement, car les éléments doivent apparaître un nombre entier de fois ; il ne peut pas y avoir 2,5 occurrences d'un mot. Néanmoins, sur des étendues assez larges, et à une assez bonne approximation, de nombreux phénomènes naturels obéissent à la loi de Zipf.

Dans les langues humaines, les fréquences des mots ont une distribution à queue très lourde et peuvent donc être modélisées assez bien par une distribution Zipf avec un s proche de 1.

Tant que l'exposant s dépasse 1, il est possible qu'une telle loi soit valable avec une infinité de mots, car si s > 1 alors

où ζ est la fonction zêta de Riemann .

Explication statistique

Bien que la loi de Zipf s'applique à toutes les langues, même non naturelles comme l' espéranto , la raison n'est toujours pas bien comprise. Cependant, cela peut s'expliquer en partie par l'analyse statistique de textes générés aléatoirement. Wentian Li a montré que dans un document dans lequel chaque caractère a été choisi au hasard parmi une distribution uniforme de toutes les lettres (plus un caractère espace), les "mots" de longueurs différentes suivent la macro-tendance de la loi de Zipf (le plus probable les mots sont les plus courts avec une probabilité égale). Vitold Belevitch , dans un article intitulé On the Statistical Laws of Linguistic Distribution , propose une dérivation mathématique. Il a pris une grande classe de distributions statistiques bien comportées (pas seulement la distribution normale ) et les a exprimées en termes de rang. Il a ensuite développé chaque expression en une série de Taylor . Dans tous les cas, Belevitch a obtenu le résultat remarquable qu'une troncature du premier ordre de la série a abouti à la loi de Zipf. De plus, une troncature de second ordre de la série de Taylor a abouti à la loi de Mandelbrot .

Le principe du moindre effort est une autre explication possible : Zipf lui-même a proposé que ni les locuteurs ni les auditeurs utilisant une langue donnée ne veulent travailler plus que nécessaire pour parvenir à la compréhension, et le processus qui aboutit à une distribution à peu près égale de l'effort conduit à la distribution Zipf observée. .

De même, il a été démontré que l' attachement préférentiel (intuitivement, « les riches s'enrichissent » ou « le succès engendre le succès ») qui aboutit à la distribution Yule-Simon s'adapte mieux à la fréquence des mots par rapport au rang dans la langue et la population par rapport à la ville se classe mieux que la loi de Zipf. Il a été initialement dérivé pour expliquer la population par rapport au rang des espèces par Yule, et appliqué aux villes par Simon.

Explication mathématique

Les modèles Atlas sont des systèmes de processus de diffusion à valeur positive échangeables avec des paramètres de dérive et de variance qui ne dépendent que du rang du processus. Il a été démontré mathématiquement que la loi de Zipf est valable pour les modèles Atlas qui satisfont à certaines conditions de régularité naturelle. Les modèles Atlas peuvent être utilisés pour représenter des systèmes empiriques de données multivariées dépendant du temps, y compris, par exemple, la fréquence des mots dans une langue écrite, la population des villes et la taille des entreprises. Un modèle Atlas qui représente un système empirique aura la même distribution stationnaire que le système empirique, donc si le modèle Atlas suit la loi de Zipf, le système suivra également la loi de Zipf. Puisque les modèles Atlas qui satisfont aux conditions de régularité naturelle suivent la loi de Zipf, cela explique son universalité.

Dans la figure ci-dessus des 10 millions de mots Wikipédia, les tracés log-log ne sont pas précisément des lignes droites mais plutôt des courbes légèrement concaves avec une tangente de pente -1 à un certain point le long de la courbe. De telles distributions sont généralement appelées distributions quasi-Zipfiennes , et la plupart des systèmes de données empiriques dépendant du temps qui sont censés suivre la loi de Zipf sont en fait quasi-Zipfiens. Les systèmes quasi-Zipfiens peuvent être représentés par des modèles quasi-Atlas , et les modèles quasi-Atlas se prêtent à un traitement mathématique similaire à celui de la loi de Zipf.

Lois connexes

La loi de Zipf , en fait , se réfère plus généralement aux distributions de fréquence des « données de rang », dans lequel la fréquence relative du n article classé th-est donné par la loi zêta , 1 / ( n s Ç ( s , où le paramètre)) s > 1 indexe les membres de cette famille de distributions de probabilité . En effet, la loi de Zipf est parfois synonyme de « distribution zêta », puisque les distributions de probabilité sont parfois appelées « lois ». Cette distribution est parfois appelée distribution zipfienne .

Une généralisation de la loi de Zipf est la loi de Zipf-Mandelbrot , proposée par Benoit Mandelbrot , dont les fréquences sont :

La "constante" est l'inverse de la fonction zêta de Hurwitz évaluée à s . En pratique, comme facilement observable dans les diagrammes de distribution pour les grands corpus, la distribution observée peut être modélisée plus précisément comme une somme de distributions séparées pour différents sous-ensembles ou sous-types de mots qui suivent différentes paramétrisations de la distribution Zipf-Mandelbrot, en particulier la classe fermée des mots fonctionnels présentent s inférieur à 1, tandis que la croissance du vocabulaire ouvert avec la taille du document et la taille du corpus nécessite s supérieur à 1 pour la convergence de la série harmonique généralisée .

Les distributions zipfiennes peuvent être obtenues à partir des distributions de Pareto par un échange de variables.

La distribution Zipf est parfois appelée distribution de Pareto discrète car elle est analogue à la distribution de Pareto continue de la même manière que la distribution uniforme discrète est analogue à la distribution uniforme continue .

Les fréquences de queue de la distribution Yule-Simon sont approximativement

pour tout choix de ρ > 0.

Dans la distribution fractale parabolique , le logarithme de la fréquence est un polynôme quadratique du logarithme du rang. Cela peut nettement améliorer l'ajustement par rapport à une simple relation de loi de puissance. Comme la dimension fractale, il est possible de calculer la dimension Zipf, qui est un paramètre utile dans l'analyse des textes.

Il a été soutenu que la loi de Benford est un cas particulier limité de la loi de Zipf, le lien entre ces deux lois étant expliqué par leurs deux provenant de relations fonctionnelles invariantes d'échelle de la physique statistique et des phénomènes critiques. Les rapports de probabilités dans la loi de Benford ne sont pas constants. Les premiers chiffres des données satisfaisant la loi de Zipf avec s = 1 satisfont la loi de Benford.

| La loi de Benford : |

||

|---|---|---|

| 1 | 0.30103000 | |

| 2 | 0,17609126 | -0,7735840 |

| 3 | 0,12493874 | −0.8463832 |

| 4 | 0,09691001 | −0.8830605 |

| 5 | 0,07918125 | -0.9054412 |

| 6 | 0,06694679 | −0.9205788 |

| 7 | 0,05799195 | -0,9315169 |

| 8 | 0,05115252 | −0.9397966 |

| 9 | 0,04575749 | -0,9462848 |

Applications

En théorie de l'information , un symbole (événement, signal) de probabilité contient des bits d'information. Par conséquent, la loi de Zipf pour les nombres naturels : est équivalente à un nombre contenant des bits d'information. Pour ajouter des informations d'un symbole de probabilité dans des informations déjà stockées dans un nombre naturel , nous devrions aller à tel que , ou de manière équivalente . Par exemple, dans un système binaire standard, nous aurions , ce qui est optimal pour la distribution de probabilité. L'utilisation d'une règle pour une distribution de probabilité générale est la base de la famille des systèmes numériques asymétriques de méthodes de codage entropique utilisées dans la compression de données , dont la distribution d'état est également régie par la loi de Zipf.

La loi de Zipf a été utilisée pour extraire des fragments parallèles de textes à partir de corpus comparables. La loi de Zipf a également été utilisée par Laurance Doyle et d'autres à l' Institut SETI dans le cadre de la recherche d'intelligence extraterrestre .

Voir également

- Règle du 1% (culture Internet)

- La loi de Benford

- La loi de Bradford

- Loi sur la brièveté

- Gravité démographique

- Liste des fréquences

- la loi de Gibrat

- Hapax legomenon

- La loi des tas

- Effet roi

- courbe de Lorenz

- La loi de Lotka

- La loi de Menzerath

- Répartition de Pareto

- Principe de Pareto , alias la "règle des 80-20"

- La loi des prix

- Principe du moindre effort

- Distribution rang-taille

- La loi d'éponymie de Stigler

- Longue queue

Les références

Lectures complémentaires

Primaire:

- George K. Zipf (1949) Le comportement humain et le principe du moindre effort . Addison-Wesley. « Texte en ligne [1] »

- George K. Zipf (1935) La psychobiologie du langage . Houghton-Mifflin.

Secondaire:

- Alexander Gelbukh et Grigori Sidorov (2001) "Les coefficients des lois Zipf et Heaps dépendent de la langue" . Proc. CICLing -2001, Conférence sur le traitement de texte intelligent et la linguistique informatique , 18-24 février 2001, Mexico. Notes de cours en informatique N 2004, ISSN 0302-9743 , ISBN 3-540-41687-0 , Springer-Verlag: 332-335.

- Damián H. Zanette (2006) " La loi de Zipf et la création du contexte musical ", Musicae Scientiae 10 : 3–18.

- Frans J. Van Droogenbroeck (2016), Gestion de la distribution Zipf dans l'attribution de la paternité informatisée

- Frans J. Van Droogenbroeck (2019), Une reformulation essentielle de la loi de Zipf-Mandelbrot pour résoudre les applications d'attribution de paternité par la statistique gaussienne

- Kali R. (2003) "The city as a Giant component: a random graph approach to Zipf's law," Applied Economics Letters 10 : 717-720(4)

- Gabaix, Xavier (août 1999). « La loi de Zipf pour les villes : une explication » (PDF) . Journal trimestriel d'économie . 114 (3) : 739–67. CiteSeerX 10.1.1.180.4097 . doi : 10.1162/003355399556133 . ISSN 0033-5533 .

- Axtell, Robert L; Distribution Zipf de la taille des entreprises américaines , Science, 293, 5536, 1818, 2001, American Association for the Advancement of Science

- Ramu Chenna, Toby Gibson; Evaluation of the Suitability of a Zipfian Gap Model for Pairwise Sequence Alignment , International Conference on Bioinformatics Computational Biology: 2011.

- Shyklo A. (2017) ; Explication simple du mystère de Zipf via une nouvelle distribution de partage de rang, dérivée de la combinatoire du processus de classement , disponible sur SSRN : https://ssrn.com/abstract=2918642 .

Liens externes

|

Ressources de la bibliothèque sur la loi de Zipf |

- Strogatz, Steven (2009-05-29). "Chronique d'invité : les maths et la ville" . Le New York Times . Récupéré le 29-05-2009 .—Un article sur la loi de Zipf appliquée aux populations urbaines

- Seeing Around Corners (Les sociétés artificielles appliquent la loi de Zipf)

- Article PlanetMath sur la loi de Zipf

- Distributions de type "fractal parabolique" dans la Nature

- Une analyse de la répartition des revenus

- Zipf Liste des mots français

- Liste Zipf pour l'anglais, le français, l'espagnol, l'italien, le suédois, l'islandais, le latin, le portugais et le finnois du projet Gutenberg et calculatrice en ligne pour classer les mots dans les textes

- Les citations et la loi de Zipf-Mandelbrot

- Exemples et modélisation de la loi de Zipf (1985)

- Systèmes complexes : décompresser la loi de Zipf (2011)

- La loi de Benford, la loi de Zipf et la distribution de Pareto par Terence Tao.

- « Loi Zipf » , Encyclopédie des mathématiques , EMS Press , 2001 [1994]

![{\displaystyle f(k;N,q,s)={\frac {[{\text{constant}}]}{(k+q)^{s}}}.\,}](https://wikimedia.org/api/rest_v1/media/math/render/svg/fa491882940976898252010592e6c19ce6092ba9)

![{\displaystyle f(k;\rho )\approx {\frac {[{\text{constant}}]}{k^{\rho +1}}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/78fb2a5a8523f03c5e11716e40fd9627c18ff49f)